7-шаговая Аутрич-инструкция: «Как бесплатно найти самые релевантные страницы сайтов для размещения ссылок»

Недавно я публиковал свою статистику по OutReach в Рунете. Из-за положительных откликов в комментариях продолжаю эту тему. Сегодня на конкретном примере расскажу, как я ищу релевантные площадки для размещения ссылок. Инструкция будет по шагам. Ею сможет воспользоваться любой желающий (вложений не потребуется, то есть бесплатно).

На самом деле, у Outreach есть несколько методов поиска подходящий сайтов:

- справочники и рейтинги — ищем в них тематические ресурсы и связываемся с владельцами;

- поиск площадок из уже существующей ссылочной массы;

- поиск самых релевантных страниц по семантическому ядру;

- и т.п.

В основном я пользуюсь третьим способом. Сам по себе аутрич довольно хлопотное по времени и ресурсам занятие, поэтому оно должно быть максимально эффективным . Почему? Сейчас объясню.

Предположим, что я продвигаюсь по запросу "продвижение сайтов в Google". Ссылка с какой страницы будет самой "сочной" и релевантной? Правильно, с ТОП-1 по этой ключевой фразе в выбранном поисковике (Яндекс или Гугл). По данной аналогии и работает способ, которым я пользуюсь — нахожу площадки, которые выдаются в ТОП по продвигаемым ключевым словам.

Итоговая задача – поиск релевантных тематичных сайтов, на которых можно опубликовать ссылку. Ниже инструкция, как делаю это я (можете параллельно чтению делать вместе со мной). Если вы знаете, где можно ускорить или упростить процесс, то буду рад комментариям .

Содержание:

- 1. Определение списка ключевых фраз

- 2. Поиск ТОП 100 страниц по каждому запросу

- 3. Объединение столбцов, удаление ключей

- 4. Удаление заведомо неподходящих площадок

- 5. Объединение URL одного сайта и сортировка по количеству встречаний

- 6. Удаляем площадки, которые торгуют ссылками

- 7. Удаление площадок вручную

- Результаты деньрожденского конкурса

1. Определение списка ключевых фраз

Здесь все просто. В идеале у каждой продвигаемой страницы должна быть своя семантика. В большинстве случаев список продвигаемых ключевых фраз страницы и будет списком для одного поиска. То есть мы ищем релевантные площадки конкретно под каждый документ.

Исключение — схожие по содержанию документы. Например, садовые лестницы и строительные лестницы могут находиться на разных посадочных страницах, но поиск outreach-площадок лучше проводить по объединенному списку фраз. Иначе возможно сильное пересечение сайтов. Могут отправляться несколько предложений одному и тому же владельцу.

Если у вас еще нет семантики, то:

- Кейс по созданию и распределению семантического ядра;

- Бесплатные методы составления семантики;

- Платные способы

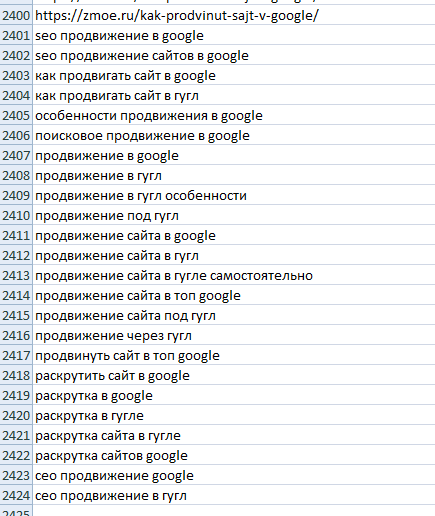

Вернусь к своему примеру. Предположим, что необходимы линки для страницы про продвижение в google. У нее следующая семантика.

24 запроса — более чем достаточно. Переходим к следующему шагу.

2. Поиск ТОП 100 страниц по каждому запросу

Сначала необходимо найти документы из ТОП 100 по каждой ключевой фразе. Почему ТОП-100, а не ТОП-10, 20 или 30? Я согласен, что ранжирование в первой двадцатке-тридцатке и первой сотне — это 2 не совсем, но разных алгоритма. Но нам необходимо собрать как можно больше релевантных страниц. Потом мы будем их объединять по количеству встречаний в выдаче. Поэтому если какой-то сайт единожды-дважды случайно забрался в ТОП-100, то мы его рассматривать все равно не будем (об этом ниже ) .

Для поиска я использую один из инструментов Арсенкина https://arsenkin.ru/tools/check-top/ . Сервис бесплатный, поэтому если вы как-то можете его поддержать, то сделайте это, не стесняйтесь .

Это единственный из инструментов, который у меня получилось найти. Он может массово парсить Яндекс (скорее всего, используются xml-лимиты). На входе — список ключевых слов, на выходе — список страниц из ТОПа, да еще и в CSV-файле. Красота!

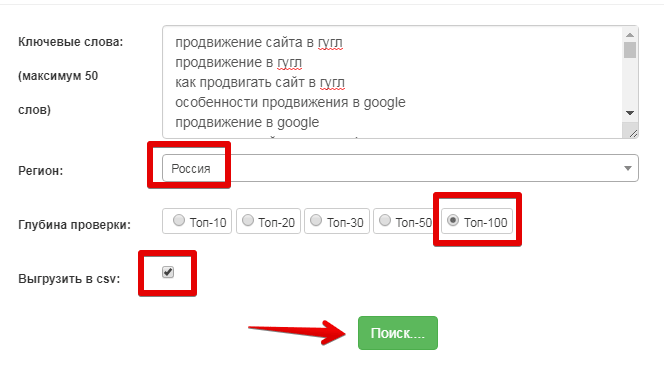

Я указываю такие настройки.

Можно указать регион (ваш главный регион продвижения; для информационных запросов можно использовать "Россия", хотя они итак в большинстве случаев геонезависимые ). Максимум 50 ключевых слов. Обычно хватает, но если вы объединили семантику нескольких документов (в шаге №1, чтобы не было пересечений площадок), то иногда нужно будет "подрезать" семантику под данный лимит — ничего страшного.

Если кто-то продвигает сайт под google, то в идеале, конечно, нужен ТОП именно из этого поисковика. Но, во-первых, такого бесплатного инструмента я не нашел (есть, но каждый запрос отдельно; если кто знает, можно даже платный вариант, напишите в комментариях). Во-вторых, выдача Яндекса и Гугла для 100 результатов будет неплохо пересекаться. Поэтому сервис можно использовать и при продвижении под зарубежную поисковую систему.

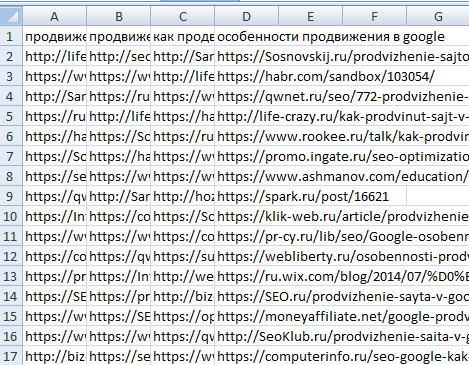

Получаем CSV-файл вот с таким списком страниц с запросами.

Ценная информация, но для нашей задачи ее вид совсем неподходящий. Идем дальше.

3. Объединение столбцов, удаление ключей

На всякий случай, я сохраняю CSV-файл в XLSX. Один раз я уже обжегся с CSV и потерял результат нескольких часов работы. Теперь все длительные операции предпочитаю проводить в стандартном excel-расширении.

А. Для удобства необходимо объединить столбцы. Для этого нужно запустить следующий макрос (большое спасибо за все макросы и помощь по Excel https://twitter.com/MVKirilov ).

Sub Макрос1()

'

' Макрос1 Макрос

''

Dim i&

For i = 2 To Cells(1, Columns.Count).End(xlToLeft).Column

Range(Cells(1, i), Cells(Rows.Count, i).End(xlUp)).Copy _

Cells(Rows.Count, 1).End(xlUp).Offset(1)

Next

Range("L16").Select

ActiveWindow.Close

End Sub

Если вы не в курсе про макросы, то погуглите тему. Если после выполнения макроса таблица захочет закрыться, то просто нажмите "Отмена".

Второй, третий и так далее столбцы скопируются под первый. Далее все столбцы кроме первого нужно удалить.

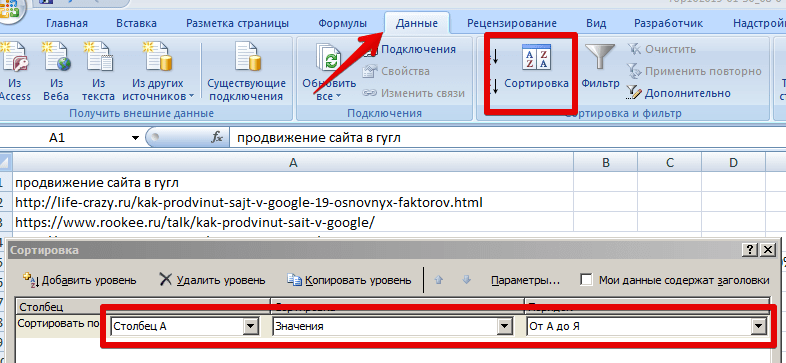

Б. Среди спарсенных страниц остаются сами запросы и пустые строки. Их нужно удалить. Для этого необходимо отсортировать столбец (выделяем его), например, от А до Я (Вкладка "Данные" -> "Сортировка").

Пролистываем вниз. Все запросы оказались здесь.

Удаляем их и переходим к следующему шагу.

4. Удаление заведомо неподходящих площадок

Чтобы тратить меньше ручной работы, нужно сразу удалить площадки, которые нам не будут подходить. Какой процент вероятности, что получится опубликовать ссылку на:

- интернет-магазине;

- сайте-услуг;

- агрегаторе (в выдаче они встречаются часто);

- доске-объявлений (имеется в виду постоянный линк);

- википедии (есть варианты, но это отдельное направление).

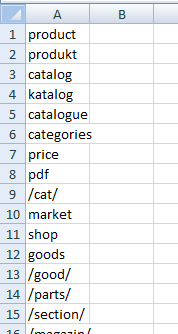

Правильно, он будет стремиться к 0. Поэтому такие ресурсы нужно сразу исключить. Как это сделать?

В Лист2 (нужно его создать, если нет) excel-файла добавляем доменные имена, их части и части URL страниц, которые заведомо указывают на коммерческую составляющую площадок. Каждое исключение с новой строки. Вот мой изначальный список:

product

produkt

catalog

katalog

catalogue

categories

price

/cat/

market

shop

goods

/good/

/parts/

/section/

/magazin/

/offers/

/list/

tovar

store

categoryID

regmarkets

promportal

propartner

satom

tiu.ru

pulscen

neobroker

avito

bizorg

all.biz

portall.zp.ua

flagma

fb.ru

goodster

StudFiles.net

aliexpress.com

blizko.ru

wikipedia

studopedia

syl.ru

alibaba.com

joom.com

geobrand

kakprosto

youla

Этот список не окончательный. Если в процессе поиска площадок будут попадаться универсальные элементы в URL (плюс какой-то популярный интернет-магазин, к примеру, wb.ru, wildberries.ru и т.п.), которые можно включить в список, то его можно дополнять уже самостоятельно.

Далее переходим на страницу со списком спарсенных URL, выделяем главный столбец (под всеми выделениями я имею в виду полное выделение, например, по клику на букву "А") и запускаем следующий макрос:

Sub Del_Array_SubStr()

Dim sSubStr As String 'Искомое слово или фраза

Dim lCol As Long 'Номер столбца с просматриваемыми значениями

Dim lLastRow As Long, li As Long

Dim avArr, lr As Long

Dim arrlCol = Val(InputBox("Укажите номер столбца со значениями", "Запрос параметра", 1))

If lCol = 0 Then Exit Sub

Application.ScreenUpdating = 0

lLastRow = ActiveSheet.UsedRange.Row - 1 + ActiveSheet.UsedRange.Rows.Count

'заносим в массив значения листа, в котором необходимо удалить строки

arr = Cells(1, lCol).Resize(lLastRow).Value

'Получаем с Лист2 значения, которые надо удалить в активном листе

With Sheets("Лист2") 'Имя листа с диапазоном значений на удаление

avArr = .Range(.Cells(1, 1), .Cells(.Rows.Count, 1).End(xlUp))

End With

'удаляем

Dim rr As Range

For lr = 1 To UBound(avArr, 1)

sSubStr = avArr(lr, 1)

For li = 1 To lLastRow 'Цикл с первой строки до конца

If InStr(1, arr(li, 1), sSubStr, 1) > 0 Then

If rr Is Nothing Then

Set rr = Cells(li, 1)

Else

Set rr = Union(rr, Cells(li, 1))

End If

End If

DoEvents

Next li

DoEvents

Next lr

If Not rr Is Nothing Then rr.EntireRow.Delete

Application.ScreenUpdating = 1

End Sub

Во всплывающем окошке в поле "Укажите номер столбца со значениями" оставляйте единицу. Было 2400 (24 запроса по 100 страниц) строк, стало 2338. На самом деле, удалилось маленькое количество URL из-за специфики изначальной семантики. Если проводится поиск площадок в e-commerce сегменте, где в выдаче много интернет-магазинов, то список зачастую сокращается в 1,5-2 раза .

В итоге предпочтительны:

- информационные сайты;

- тематические порталы;

- форумы;

- социальные сети (здесь же youtube, ролики только от пользователей, не от компаний);

- блоги;

- сообщества.

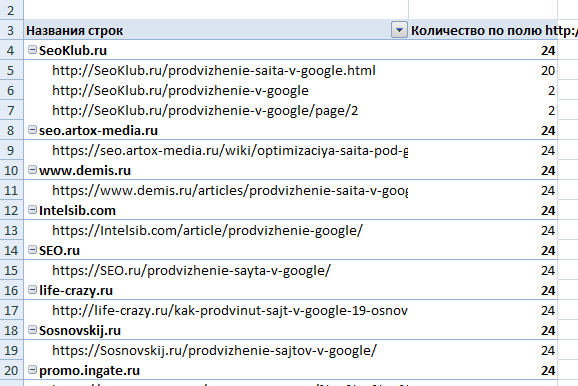

5. Объединение URL одного сайта и сортировка по количеству встречаний

Переходим к самому интересному . Теперь нужно определить, какой сайт и какие его страницы встречаются в выдаче чаще всего: 1 URL = 1 встречание. Для этого:

А. Копируем первый столбец во второй и третий столбцы.

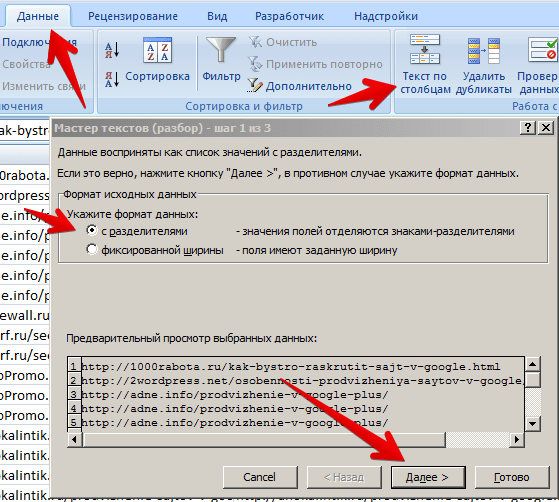

Б. Выделяем третий столбец, переходим во вкладку "Данные" и кликаем "Текст по столбцам". В "укажите формат данных" – с разделителями.

Нажимаем "Далее". Символом разделителем является "Другой", ставим слеш – "/" (без кавычек). "Далее" и "Готово".

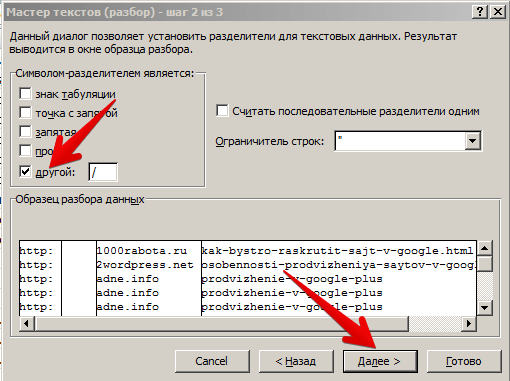

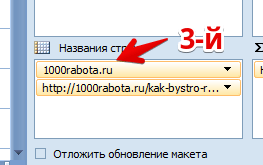

В. Получилось, что 3-й столбец разбился еще на несколько. Нам нужен столбец с доменным именем, остальные (те, которые новые) — удалить.

В итоге получаем 1 и 2 столбцы – списки страниц, 3 – список доменов соответствующих страниц.

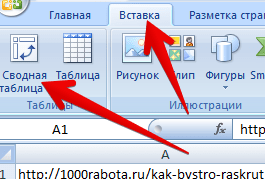

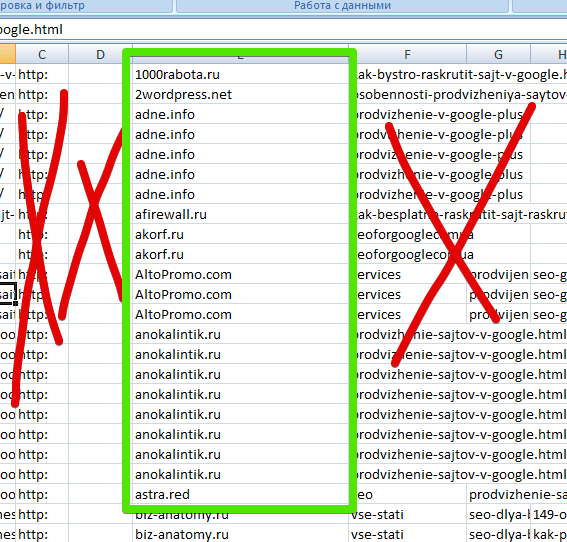

Г. Создаем сводную таблицу по трем столбцам (она создастся на новом листе). Выделяем их, далее "Вставка" -> "Сводная таблица" -> "Ок".

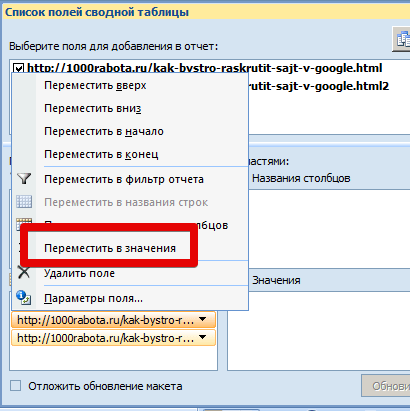

Ставим галочки у каждого столбца, а потом первый или второй отправляем в значения.

Важно – третий должен стоять выше другого (зажать кликом и переместить вверх)!

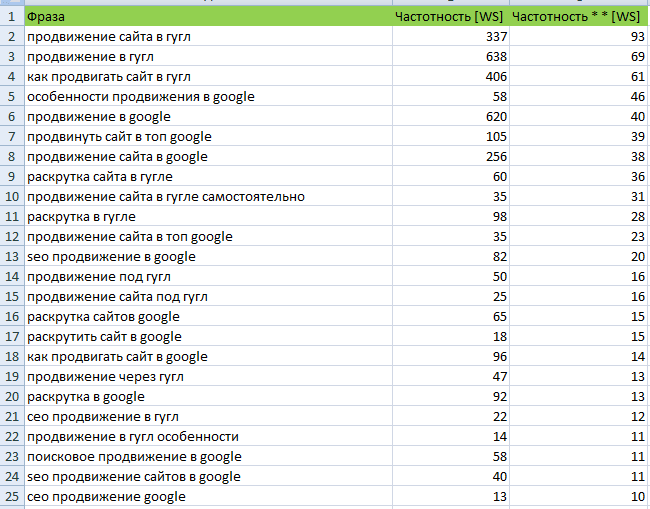

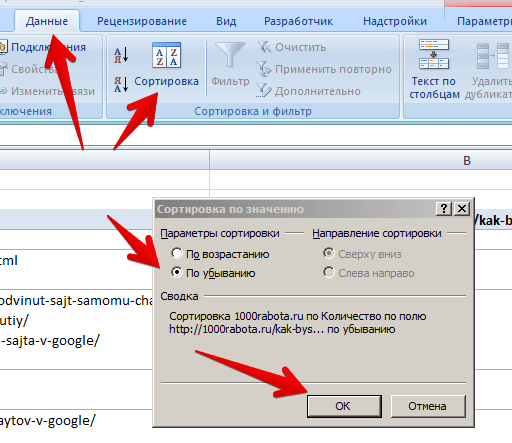

Д. Выделяем все полученные значения во втором столбце после слова "Количество по полю…". Название столбца и сумму по столбцу не выделяем. Далее "Данные", "Сортировка", "По убыванию".

Вуаля, получили самые встречающиеся (релевантные) сайты с конкретными страницами. С них-то и необходимо будет получать ссылки.

Но осталось еще немного .

Е. Выделяем и копируем столбцы "Названия строк" и "Количество по полю" на какой-нибудь новый лист (любой). Удаляем сайты, которые в сумме встречаний меньше 3. Эту цифру можно увеличивать или уменьшить в зависимости от количества найденных площадок/URL.

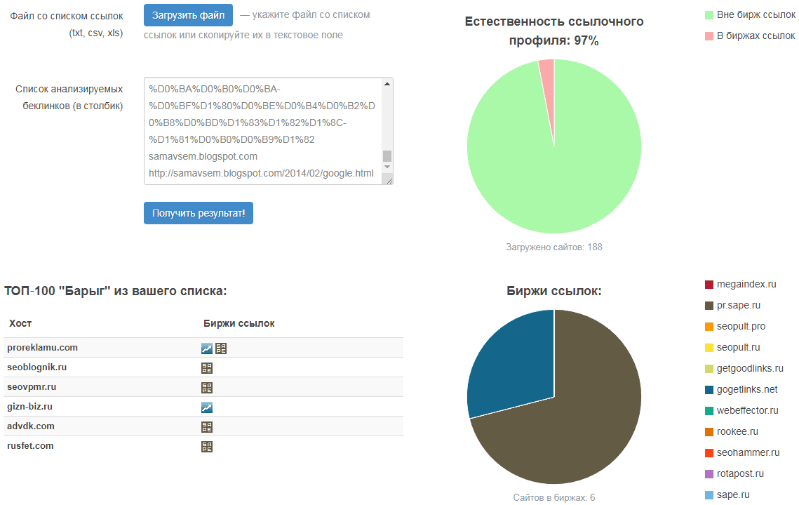

6. Удаляем площадки, которые торгуют ссылками

Этот пункт можно использовать и на 7-м шаге. Плюс использования на 6-м — вручную необходимо будет обрабатывать меньше площадок. Минус — могут удалиться качественные сайты, которые минимально торгуют или торговали ранее ссылками. Определите для себя, что вам важнее или протестируйте, меняя пункты местами.

В ЧекТрасте есть полезный и бесплатный инструмент "Барыга Чекер" https://checktrust.ru/baryga-checker.html. Копируем все строки с URL (можно так, как есть в таблице) и вставляем в окно "Список анализируемых беклинков". На выходе получаем список площадок, которые торгуют ссылками (miralinks не в счет).

7. Удаление площадок вручную

Если до этого все было достаточно автоматизировано, то теперь необходимо поработать руками . Нужно пройтись по каждому из найденных доменов, начиная с самых встречаемых, и удалить неподходящие (все те же: коммерческие сайты, агрегаторы и так далее), а также площадки с маленькой посещаемостью.

Лимит по посещаемости зависит от тематики. Мой минимальный порог 100 посещений в сутки в узких тематиках, 500 — в средних, 1000 — в широких. Ориентир по открытой статистике liveinternet, alexa и similarweb.

Все, поздравляю! Вы дошли до конца. Перед вами список самых релевантных страниц для получения ссылок под ваше семантическое ядро. Приноровившись, весь процесс до 7 пункта занимает пару минут.

В следующей части я расскажу, что с ним делать и как связываться/общаться с владельцами площадок.

Несколько советов, уточнений и примечаний:

- В конечном списке внутри домена нет сортировки по частоте встречаний URL. Необходимо стремиться получить линк с документа с максимальным количеством встречаний (исключения: главная, служебные страницы и т.п.).

- Оставляйте только крупные видеохостинги (в 99,9% youtube). Иногда попадаются сайты-дорвеи, основанные на парсинге того же ютьюба.

- Если на найденной странице есть открытые ссылки на другие сайты (они их получили таким же outreach-путем), то они не подходят.

- Если вам необходимо разместить 3 аутрич-ссылки на документ, то в среднем достаточно найти 30-40 подходящих площадок (после всех исключений/удалений), а не обрабатывать абсолютно весь список. У меня процент публикаций на уровне 10%. Конечно, возможен и другой процент, тогда просто подстраивайтесь под него.

- Если вам попалась площадка, на которой любой желающий может публиковать контент (youtbe, тематические сообщества), то изначально обращайте внимание на автора контента. Он может быть опубликован от лица компании. Естественно, предложение такому автору, скорее всего, закончится безрезультативно.

Результаты деньрожденского конкурса

Всем спасибо за поздравления с днем рождения ! Очень приятно! Подвожу итоги мини-конкурса. Победителем и единственным призером стал Иван. Поздравляю и жду R-кошелек с того же e-mail, который был указан при публикации комментария.

Мы с семьей ездили в Адыгею, и каждый день ездили на Лаго-Наки. О поездке напишу в одном из следующих постов. Пока же с нетерпением жду вопросы и комментарии .

Как автоматизировать получение обратных ссылок с помощью кросспостинга

Как автоматизировать получение обратных ссылок с помощью кросспостинга  Промежуточные результаты эксперимента: seopult, rookee или webeffector (Часть 2)?

Промежуточные результаты эксперимента: seopult, rookee или webeffector (Часть 2)?  Как я выбираю и продвигаю поисковые запросы для блога

Как я выбираю и продвигаю поисковые запросы для блога

Да, слишком геморройно стало продвигать сайты

Титанический труд, — спасибо за публикацию!

Благодарю за подробную информацию, всё четко и по делу!

мегаполезно, спасибо

Спасибо за полезную и актуальную статью))

Спасибо! Как раз вовремя наткнулся на Вашу статью

Хоть это всё и сложновато, но благодаря вашим пошаговым объяснениям становится более понятным определенные моменты. Спасибо за такое подробное разъяснение.

serprobot дешевый и качественный парсер SERP google

Он умеет то, что было опубликовано в посте?

Подробное пошаговое руководство использования сервиса. Спасибо за ваш труд. Остается только применить на практике.

Отличная инструкция. Нашёл для себя много ценной информации. Теперь буду применять на практике.

Ещё пару раз прочитаю, думаю дойдёт.

Спасибо за отличную статью!

Попробую обязательно на практике.

А по поводу выгрузки ТОПа из гугла, то у того же замечательного Арсенкинк, наконец-то, появилась эта функция, только она платная.

Александр, спасибо за статью.

1. Что думаешь на счёт утверждения — «ссылки в старых статьях выглядят неестественно в глазах ПС и следовательно могут навредить. Нужно ставить ссылки только в не проиндексированных статьях.» ?

2. И вот этот пункт можешь пояснить: «Д. Выделяем все полученные значения во втором столбце после слова «Количество по полю…». Название столбца и сумму по столбцу не выделяем. Далее «Данные», «Сортировка», «По убыванию».»

После выделения значений кнопка сортировки становится неактивной prntscr.com/tygdi6 . Что тут может быть не так?

1. Если все ссылки получены только с помощью размещения в уже проиндексированных страницах, то не ок. Если ссылочная масса строится комплексно с разных источников, то ок .

. .

.

2. Здесь не подскажу, но судя по скриншоту, уже есть необходимая сортировка

Сергей, спасибо за такой алгоритм, попробую реализовать для продвижения нескольких страниц на сайте.

Как я понял из статьи, в результате ссылки все будут со старых веток и статей релевантных площадок?

А где инфа про «В следующей части я расскажу, что с ним делать и как связываться/общаться с владельцами площадок.» ?

Скорее, не старых, а актуальных .

.

Продолжение по outreach:

— https://sosnovskij.ru/free-outreach/

— https://sosnovskij.ru/ssylki-ankory-outreach/

— https://sosnovskij.ru/outreach-perepiska-s-vebmasterami/

муторно слишком… и главное зачем? Чтобы купить потом рекламу у другого блогера? Не проще сразу пойти на биржу ссылок?

Как правило, на биржах площадки более заспамленные, зачастую с внешними коммерческими анкорами.