Эксперимент: Как быстрее всего удалить сайт из индекса Яндекса и Google

Привет, друзья! Надеюсь, что вы отлично отдохнули на майские праздники: наездились на природу, наелись шашлык и нагулялись по расцветающей природе. Теперь же нужно возвращаться к активной работе =) .

Сегодня я покажу результаты одного небольшого эксперимента по удалению всех страниц сайта из поисковых систем Яндекса и Google. Его выводы помогут при выборе одного из методов для запрета индексирования всего ресурса или отдельных его частей.

Передо мной встала задача — закрыть сайт к индексированию без потери его функционала. То есть ресурс должен работать, но удалиться из индекса поисковых систем. Конечно, самый верный способ просто удалить проект с хостинга. Документы будут отдавать 404-ошибку и со временем "уйдут" из базы поисковиков. Но задача у меня была другая.

Содержание:

Детали эксперимента

Цели:

- определить, какой метод запрета индексации приоритетней для поисковых систем;

- понаблюдать в динамике за скоростью удаления страниц из индекса;

- собственно, удалить проекты из баз ПС.

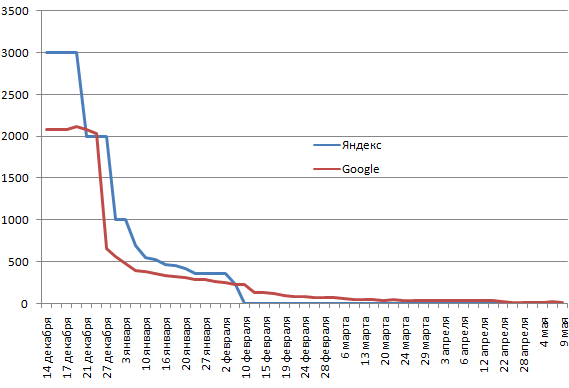

В эксперименте участвовало 2 сайта (всем больше года). Первый: в индексе Яндекса 3000 страниц, Google - 2090. Второй: Яндекс - 734, Google - 733. Если не удалять ресурс с хостинга, то остаются 2 популярных варианта: тег meta name="robots" и запрет в robots.txt.

Для первого сайта на каждой странице была добавлена строка:

<meta name="robots" content="noindex, nofollow"/>

Для второго был составлен следующий robots.txt:

User-agent: *

Disallow: /

Эксперимент стартовал 14 декабря и продолжился до 9 мая. Данные снимались примерно на даты апдейтов Яндекса.

Результаты

Ниже графики динамики количества проиндексированных страниц. Сначала сайт №1 (метод удаления тег meta name="robots").

Как видно, поисковые системы вели себя примерно по одному сценарию. Но есть и различия. В Яндексе ресурс был полностью удален 10 февраля, когда в Google оставалось еще 224 страницы. Что говорить, спустя 5 месяцев там еще остается 2 десятка документов. Гугл очень трепетно относится к проиндексированным страницам и не хочет никак их отпускать .

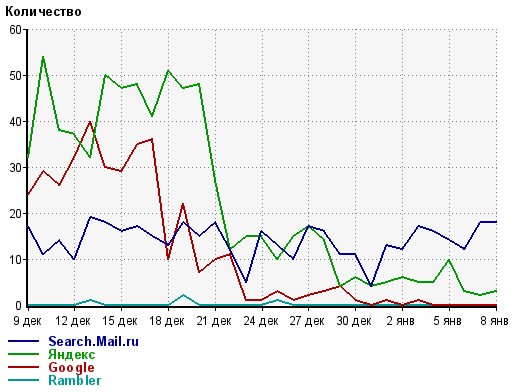

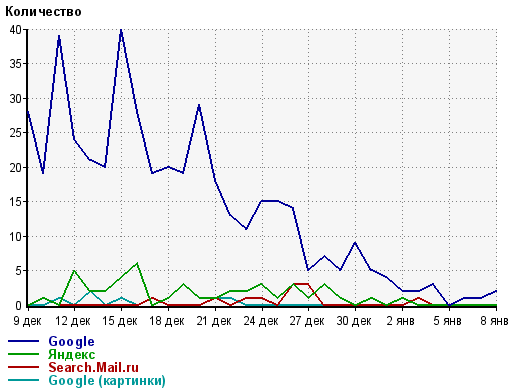

Сайт №2 (способ запрета файл — robots.txt).

Здесь ситуация разворачивалась интереснее . Яндекс достаточно быстро (меньше чем за месяц) удалил все страницы. Гугл же за месяц выкинул из индекса около 100 документов, потом через месяц еще 200 и практически застыл на месте.

4 апреля мне надоело ждать и я поменял метод запрета с robots.txt на meta name="robots". Это принесло свои плоды — через месяц в базе Google осталось только 160 страниц. Примерно такое же количество остается и по сей день.

Примечателен еще один момент. Несмотря на то, что страницы из индекса удалялись достаточно долго, трафик с поисковиков начал падать значительно быстрее.

Получается, что ПС понимают, что вебмастер запретил ресурс или его документы к индексированию, но почему-то продолжают их там держать .

Выводы

- Яндекс любит больше работу с robots.txt;

- Google любит больше работу с meta name="robots". В связи с тем, что Гугл крайне не любит robots.txt, то универсальным будет именно способ с тегом. Совмещать методы нельзя, потому как, запретив ресурс в robots.txt, поисковый паук не сможет прочитать правила для meta name="robots".

- Зеркало Рунета достаточно быстро удаляет документы при любом методе. Зарубежный поисковик делает это неохотно — очень тяжело добиться полного удаления из базы.

Вот такой получился небольшой эксперимент. Да, конечно, выборка совсем небольшая, но и она смогла подтвердить мои предположения. В прикладном плане это можно использовать, когда есть необходимость закрыть определенные документы для индексирования: предпочтительно использовать meta name="robots" вместо директив в robots.txt.

А какие наблюдения по этой теме есть у вас? Поделитесь своим опытом в комментариях !

Как распределить ключевые слова в семантике, которые подходят под разные страницы?

Как распределить ключевые слова в семантике, которые подходят под разные страницы?  10 бесплатных источников ключевых слов, которыми не пользуются 90% вебмастеров

10 бесплатных источников ключевых слов, которыми не пользуются 90% вебмастеров  Попробовал выйти из под Баден-Бадена изменением структуры контента — результаты эксперимента

Попробовал выйти из под Баден-Бадена изменением структуры контента — результаты эксперимента

Проводил похожий анализ для одного сайта. Сначала в robots.txt закрыл его от Яши, а потом от Гоши. Яша выкинул из индекса за 2 недели, гугл удалил только половину страниц.

Игорь, а как вы закрыли отдельно для яндекса и отдельно для гугла?

Жека, ну тут легко Запрещаю индексацию только для Яши:

Запрещаю индексацию только для Яши:

User-agent: Yandex

Disallow: /

Только для Гоши:

User-agent: Googlebot

Disallow: /

Ну вот дождались,лучший результат дает именно эксперимент а не тыканье пальцем …

Спасибо за эксперимент

Спасибо-)!!!

Очень интересный эксперимент.

На мой взгляд, как повезет, robots возможно и помогает, а возможно и не всегда. Я пробовал robots и на мой взгляд это долго и непонятно как реагируют поисковики.

Для себя сделал вывод, действующий способ, это запрет по ip в файле .htaccess для всех кроме меня, работает точно.

Если нужно, чтобы сайт вылетел, запрещайте доступ сайту по ip для всех в файле .htaccess, как вариант, если robots не сработал или не хотите долго ждать.

Александр, да, хороший метод, но у меня задача была такая, чтобы сайты работали для всех

А почему бы не отдавать ответ сервера 404? Через .htaccess или php это можно сделать даже для существующих страниц.

NMitra, а как они будут функционировать для рядового пользователя?

Sosnovskij, как обычные страницы. Одно время на всех конференциях трубили: делайте на несуществующих страницах ответ ошибки 404, а не 200. Накосячить наоборот так же легко

NMitra, точно. Не в ту степь «подумал» Спасибо за вариант, но, скорее всего, он мне бы не совсем подходил.

Спасибо за вариант, но, скорее всего, он мне бы не совсем подходил.

Спасибо за материал.

Sosnovskij, а не подскажите директива disallow: * и disallow: / равнозначны?

Николай, правило должно начинаться со слеша. Ваш первый вариант некорректный.

Что один способ, что второй показал довольно быстрый результат. Здесь особо считаю выбирать и нечего…

Надеюсь, что мне не пригодятся эти методы, но на всякий пожарный, закинул в закладки)))))