Как устроена индексация сайтов в Google

Привет, друзья! В сегодняшнем посте я затрону тему индексации сайта в поисковой системе Google. Какие проблемы возникают с ней? Существует ли сейчас основной и дополнительный индекс? Все мои наблюдения на этот счет ниже.

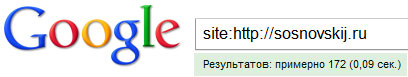

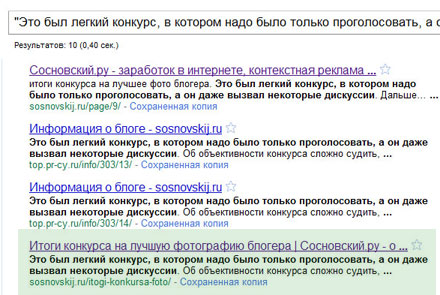

Не знаю как у вас, а у меня Google индексирует меньше страниц, чем Яндекс. По крайней мере он показывает это по таким запросам:

Кстати в этой записи все буду разбирать на примере блога. Он находится в dmoz-каталоге, на нем авторские уникальные статьи, теги, архивы и другие, дублирующие контент страницы (кроме категорий и нумерации страниц по средствам плагины PageNavi) запрещены в robots.txt. Что на такой запрос говорит Яндекс?

Тут уже 281 страница. Причем вообще в sitemap записано примерно 200 страниц + примерно 80 - это как раз те, которые создаются постраничной навигацией. Эти цифры ближе к реальности .

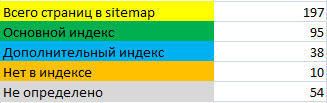

Вернемся опять к гуглу. Получилось, что сейчас он знает только о 172 страницах моего блога. Что же на самом деле? У меня получилась следующая картина:

Сейчас я объясню всю эту таблицу .

- Основной индекс. Существуют такие понятия как основной индекс в Google и дополнительный. Страницы основного участвуют в ранжировании на общих основаниях. Страницы, которые находятся в дополнительном ("в соплях" - supplemental) очень редко появляются в выдаче, и то только по тем запросам, по которым нет ответов у страниц из "основы" (например, некоторые низкочастотные запросы или long tail). Чтобы определить, сколько документов находится в основном индексе Google, необходимо ввести запрос site:https://sosnovskij.ru/&. У меня получилось 95. А у вас сколько? Причем интересно то, что сюда попадают страницы вида https://sosnovskij.ru/page/4/, то есть не особо полезные для пользователей.

- Дополнительный индекс. По мнению гугла это некачественные страницы, которые не могут дать хороших, исчерпывающих ответов на поисковые запросы. Эти страницы часто включаются в "опущенные результаты<". Они были определены путем исключения из тех 172 страниц 95, которые находятся в основном. Как видно, что 172-95=77, а не 38. В цифре 172 также много страниц навигации.

- Нет в индексе. Это самый понятный пункт

.

- Не определено. Этих страниц не было в числе 172, не было в числе основного индекса, но Google о них знает. Поиск был как просто по url, так и по кускам текста.

- Всего страниц в sitemap. Это только посты, страницы и категории.

Что же получается? Google оказывается знает о 187 страницах + несколько десятков навигационных, а не о 172. По-моему кто-то что-то скрывает или прячет .

Выводы по поводу индексации в Google

- Дополнительный индекс или "сопли" точно существует, потому что некоторые из страниц выдаются по запросу url не на первой строчке. Также я проверил некоторые среднечастотные и низкочастотные запросы на этих страницах. Их не было в ТОП 100.

- В категории "не определено" скорее всего, те же "сопли", так как страницы ведут себя также.

- Часто страницы, которые находятся в дополнительном индексе, находятся в выдаче ниже сайтов, копирующих и грабящих контент. То есть одна из причин попадания в "сопли" - это неуникальный контент.

- Нельзя судить по запросу site:https://sosnovskij.ru/ о точном количестве проиндексированных страниц в этой поисковой системе. Их больше, но они будут не в основном индексе, и посетителей с гугла скорее всего не принесут. В доказательство этому 185 страниц, на которые были посещения в течение месяца.

До проведения данного анализа я считал, что у моих сайтов проблемы с индексацией страниц в Google. На самом же деле проблемы с тем, что некоторые документы попадают в дополнительный индекс, а о других Google знает, но молчит .

Почему Google отправляет страницы в дополнительный индекс?

- Как я уже написал выше, причиной может служить дублирование контента. Для этого можно запретить к индексации дублирующие страницы: теги, архивы и так далее.

- Часто страницы с копированным контентом тоже отправляются в сопли, либо просто с незначительным его количеством или низким качеством.

- Ошибки поисковой системы. Поисковой робот может неправильно проанализировать страницу, несмотря на то, что она будет являться первоисточником с уникальным и интересным контентом.

Как же вывести страницы из соплей? А вот этим я и буду заниматься. В одном из последующих постов опубликую результаты эксперимента, который должен будет вытащить некоторые страницы блога в основной индекс. Не пропустите . Что вы думаете по поводу индексации ваших сайтов в гугл? Какие особенности были замечены?

(9 голос., в среднем: 4,56 из 5)

(9 голос., в среднем: 4,56 из 5) Эксперимент: эффективное расположение ключевого слова в заголовке страницы

Эксперимент: эффективное расположение ключевого слова в заголовке страницы  Мой список dofollow блогов

Мой список dofollow блогов  Закрытые сценарии от RooKee — зарабатывай на своих знаниях + конкурс.

Закрытые сценарии от RooKee — зарабатывай на своих знаниях + конкурс.

Интересно, а автор в курсе, что у гугла уже годика два нет разделения индекса на дополнительный и основной?

Sasha_RIS, я где-то видел, что гугловцы отрицают разделение. Как вы, например, объясните наличие тех страниц, которые по урлу находятся на 5-6 строчках? Дополнительный индекс, скрытый индекс можно называть это по-разному. Тот факт, что страницы ведут себя по-разному есть.

Sosnovskij, раньше Гугл подтверждал наличие разделения индекса на дополнительный и основной. Сейчас же этой грани нет.. скорее вообще граней нет… уже работает совсем другой алгоритм, который по-другому оценивает релевантность страницы определенному запросу..

У меня в Google наоборот больше страниц в индексе. Возможно потому, что блогу всего месяц .

.

С Директа как прибыль Саня?

В Google за сателлитами забавно наблюдать: значения ежедневно могут меняться процентов на 80. В Яндексе такое невозможно в принципе.

Sasha_RIS, согласен, может и другой алгоритм, но очень схож со старым.

haserk, это вопрос к Sasha_RIS?

zusicks438, в гугле все меняется намного динамичней

Проставьте внешних ссылок на нужные страницы, они и вылезут. Бывает, что Google скрывает страницы, сильно похожие друг на друга. Например, на странице небольшой пост, а «окружение» (меню, код, метатеги и т.д.) одинаковое для всех и сильно больше поста. С вероятностью в 90 % этой страницы не будет в основном индексе.

С удовольствием почитаю, как можно вытягивать из неосновного индекса. У меня там много страниц блога.

seoded, спасибо за советы.

А у меня точно та же ботва, что и у автора — ровно 172 страницы выдает)) а в яхе 400.

Нет я думаю все таки разделение на дополнительный и основной индекс есть. Это можно сказать по падению траффика на сайте. В общем история такая. Было два сайта сайт N и сайт X. Домен сайта N трастовый, сайта X свежий. Оба сайта постоянно обновлялись и в основном индексе были почти все важные страницы. Индексация сайта Яндексом была примерно на том же уровне. В Я. где то 380 страниц в Г. 400 на обоих сайтах. На сайт N была установлена sape, а через пол года обновление закончили. Сайт X продолжал обновляться. В итоге страницы с сайта N вылетели с основного индекса полностью и трафик с гугла упал в 3раза. Позже медленно, но страницы стали возвращаться, но даже сейчас в основном индексе их не более 120 и постоянно +-20. Сайт X так и остался в основном индексе.

Тематика одинаковая. Контент уникальный. Делаем выводы.

Индексация у гугла чем-то напоминает американские горки

Мой конкурент имеет пиар 0-ТИЦ10. И ссылок меньше. В Гугле выше меня в выдаче

Блог о Диабете, Тиц ни чего не решает! главное сколько ссылок на конкурента ведёт и какие они:)

У меня гугл вообще кажет в 3 раза больше страниц.

Есть вопросы! В самом начале статьи ты прописывал site:https://sosnovskij.ru/ — и получил «Результатов: 172, страницы 23 (0,05 сек.) «. Но дело в том, что чаще всего,когда начинаешь листать выдачу по страничкам то получается не 172, а 100

Только что сканировал твой сайт и мне google показал 306 страниц, но когда я листал выдачу,оказалось 230 страниц.

Почему такая разница в цифрах? Это глюк google?

Если вводить site:_https://sosnovskij.ru/& то в этом случае все совпадает

95 страниц найдено и я могу просмотреть все 95 страниц.

Eugene, да, сейчас количество проиндексированных выросло практически в 2 раза. Ищется меньше страниц, потому что остальные типо «скрытые» и содержат «похожие результаты». Точную формулу какие страницы, где находятся так и не получилось добиться.

Sosnovskij, почему через robots на блоге не закроешь tags и categories?

Eugene, они у меня не индексируются. Через плагин All in one seo закрыты, но надо и туда добавить. Спасибо .

.

Sosnovskij, пусть твой блог растет бальшой и сильный

Eugene, спасибо

Странно, но гугл мои новые блоги индексирует относительно быстро, а от Яши как всегда индексацию нужно ждать прилично времени. Интересно, с чем это связанно?

Новичок, google в принципе быстрее индексирует сайты, но в посте речь все же не о скорости, а о количестве проиндексированных страниц.

Sosnovskij, Чтобы узнать, какие страницы находятся в основном индексе Гугла, существует (недокументированный) запрос:

«site:/*» — (имя домена, слэш, звездочка).

Таким образом, на данный момент на сайте sosnovskij.ru 110 страниц в основном индексе, и там же видно, какие именно.

Более подробно читайте у меня на сайте: bizsoftlab.com/blog/archives/302 .

Но там с супплементалом все не так просто. Дело в том, что по данным одного западного исследования есть страницы, которые виртуально присутствуют и там, и там. Так что возможно, «сопли» — вещь динамическая.

Александр, я его и указал в статье, только там не *, а &. Результаты одни и те же. На счет «соплей» все верно. Они есть, но «пляшут» туда сюда и точно их сложно отследить.

Да не совсем одни и теже, цифры то близки, но набор страниц разный.

Пытаюсь разобраться, но не выходит.

Мне б кто про сайт рассказал ))) больше 400 стр, в индексе кажет 116, в основном где-то 40, а об остальных знает гад, но ни туда ни сюда не сует.

Для отслеживания соплей даже сервис специальный есть, если кому интеренсо)):

supplemental.name

Вот что он говорит, о данном сайте:

—————————————————————

В индексе гугла 208 страниц сайта sosnovskij.ru

Из них в основном индексе 110 страниц;

В дополнительном индексе 98 страниц.

Качество сайта sosnovskij.ru 53%

Это отличный показатель — сайт явно трастовый.

—————————————————————

Хвалит))

Дмитрий, потестил несколько сайтов и порой показатели, которые дает сервис) очень сильно отличаются от того, что дает google через site:mysite/*

Но вобщем тема хорошая. Спасибо.

Eugene, пожалуйста.

Дмитрий, да, Дмитрий, видел я этот сервис, но встречал противоречивые мнения о нем. Что типа не всегда точные результаты.

Что типа не всегда точные результаты.

Sosnovskij, да, но и поисковые системы — это, само собой, вещи не определенные, что уж о сервисах говорить))

А как можно избавиться от шаблонности wordpress. Ведь на каждой странице есть меню, категории, и прочее?

И еще хотелось бы узнать, рисунок в посте четвертый сверху (таблица) — это результат какого нибудь сервиса или ручной подсчет? Просто у меня постоянно скачет число страниц в индексе гугла и хотелось бы определить что в основном индексе, а что в дополнительном

strikestar, удалить ненужные элементы

Таблица — это ручной подсчет.

Sosnovskij, лишнего не держу. Просто думал может есть какой то способ чтобы отражать определенные элементы не на всех страницах, а на нескольких…

strikestar, какие-то решения наверняка есть, но стоит ли их реализовывать? Меню и категории плохого не сделают, а архивы и теги можно просто убрать .

.

Sosnovskij, понятно, спасибо , а архивов, тегов у меня и так нет

, а архивов, тегов у меня и так нет

Точно молчит, у меня так же. Забьёшь в поиск находит, а в админ панели Гугла ее нет среди проиндексированных.

Тоже хочу провести эксперимент. Как можно получить список страниц которые находятся в «соплях»?

Данила, я ручками определял. Достаточно муторное и долгое дело .

.

Может Гугл плохо индексирует зону ru, Яндекс все-таки наш Российский, а Гугл буржуй.

mixac, не уверен, что корни проблемы в зоне ru.

Пробую сделать сайт для англоязычной аудитории. Добавил пока 10 новостей по прошествии недели ни одной страницы в индекс google не добавилось. Знание английского языка у меня среднее поэтому попробовал писать уникальные тексты на русском языке, а затем переводить на английский с помощью переводчика (например онлайн переводчик Google – translate.google.com).

Как вы считаете достаточно ли такого перевода для поисковика Google, чтобы он заносил эти тексты в поисковой запрос? Или же это будет отсеиваться, как корявый текст?

Илья, проиндексировать то он такие тексты сможет, но вряд ли они будут показываться высоко в выдаче. Нужна хотя бы какая-нибудь редакция.

Здравствуйте! Вот ВЕЗДЕ указывается, как проверить какие страницы попали в сопливый индекс гугл, — вводишь в поисковую строку site:ваш сайт.ru — site:v-ваш сайт.ru/& (или на конце *), и гугл вам выдает, какие же страницы в его сопливом отстое. Ерунда полная!

Мой сайт bablo-v-seti.ru/, ввожу сначала «site:bablo-v-seti.ru/&» или «site:bablo-v-seti.ru/*» — выдает почти все страницы сайта. Это основной индекс.

Дале ввожу site:bablo-v-seti.ru/-site:bablo-v-seti.ru/& (*) — также все страницы.

Никакой разницы. Такое впечатление, что по этому запросу — как определить споливый индекс своего сайта, — переписали статью друг у друга и все.

Хрень полная.

Петр, о второй конструкции я не писал.

Да.. вот как обстоят дела.

Было бы лучше если бы гугл научился не индексировать канонические ссылки, как например, яндекс. В выдаче по условиях в файле robots.txt указано четко и ясно не сканировать такой параметр, а в выдачу лезет пустые ссылки без описаний и т.д.

С яндексом вообще проблем нет, robots.txt создал и радуйся жизни.

У меня вообще солянку выдает при запросах!

Дмитрий,

Присоединяюсь ))

Здравствуйте!

google.com.ua/?gws_rd=ssl#q=terratel

Помогите пожалуйста разобраться, 5 строка «террател — terratel», откуда взялся такой тайтл страницы и как ее изменить (в коде вообще ничего подобного не было).

Анатолий, у меня на 5-й строчке другой title. Покажите скриншот

Я тоже давно еще заметила, что проиндексированные страницы в Гугле и Яндексе значительно разнятся, и как-то просто смирилась с этим, поставив плагины, запрещающие дубли и ссылки, а оказывается нужно принимать радикальные меры по борьбе с ними

Сергей, здравствуйте!

Сайту уже 10 месяцев. Тематика: заболевания суставов. Трафик с ПС около 1,6 к в сутки — и все Яндекс. Домен куплен без истории, сайт наполняется постоянно, ссылки покупаются ежемесячно. Гугл вообще не дает трафика (20 чел в сутки это смешно). Индексация в Яше — 410 стр, в гугле — 344 стр.

В чем может быть проблема и как ее решить?

Владимир, всегда ли был такой трафик с google и довольно большое количество рекламы?

Трафика не было с гугла сразу и по сей день его нет. Обильная монетизация началась примерно месяца с 5-6 существования сайта, как пошел трафик (перевалил за 300-400).

Владимир, значит, скорее всего, какой-то фильтр. Нужно анализировать детальнее.

Не могу представить даже какой это может быть фильтр, а главное ЗА ЧТО. Ведь реклама вешалась, когда трафик пошел с Яндекса, а с гугла как не было так и нет. Может идти речь о какой то жесткой песочнице для мед сайтов?

P.S. Кстати ссылочное, которое так любит гугл пристутствует. Закупаем (понемногу 3-4 шт ежемесячно) вечные ссылки с ГГЛ и Миралинкса, почекав доноров чектрастом и xtool. Именно поэтому теряюсь просто в вопросе. Может ли редирект с нового домена, например комовский решить проблему?

Владимир, о жесткой песочнице для медицинских проектов со стороны google не слышал.

Редирект с какого-то другого домена на существующий вряд ли изменит ситуацию.