Эксперимент по возврату посещаемости после Google Penguin

Привет, друзья! Большое спасибо за поздравления с трехлетием блога. Было очень приятно. В прошлом посте я упомянул о том, что гугл "помог" мне увеличить посещаемость блога за последние полгода. Как вы уже могли понять по заголовку, относительно новый алгоритм Penguin не обошел и мой дневник. Почему так произошло? Что предпринимать в данной ситуации? Как вернуть посещаемость с этой поисковой системы? Всеми этими вопросами я начинаю новый эксперимент по возврату посещаемости с google.ru.

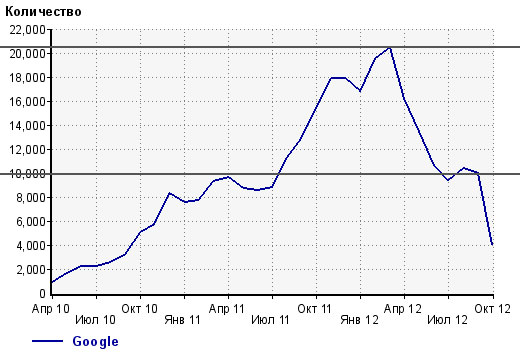

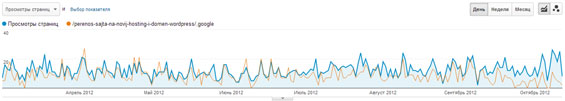

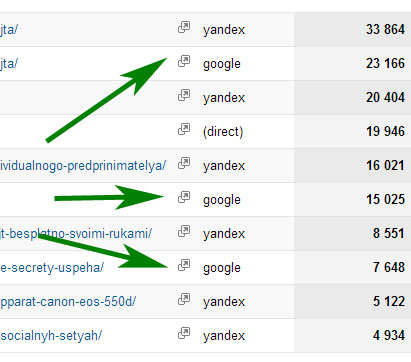

"Прошло практически полгода! Уже не актуально!" - могут сказать некоторые. Во-первых, для меня это актуально (ранее не нашел время, чтобы этим заняться). Во-вторых, это актуально и для многих сайтов, которые мне попадались, и которые до сих пор находятся под влиянием Пингвина от Гугла. В-третьих, данный алгоритм не был одноразовым. Он работает и усовершенствуется до сих пор. В связи с этим, поизучать его никогда не поздно . Вот мой график посещаемости с этой ПС. Она упала в 2 раза.

Суть алгоритма

В первую очередь, Google Penguin был направлен на борьбу с веб-спамом: внутренним (на сайте) и внешним (в виде обратных ссылок). Раньше считалось, что гугл любит немного переспамленные тексты и анкор-листы с прямым вхождением продвигаемого ключевого слова. Данный алгоритм перевернул понятие о продвижении в google у вебмастеров и оптимизаторов.

По внутренним факторам в принципе все понятно - не нужно переоптимизировать тексты, внутренние линки. По обратным ссылкам складывается не совсем однозначная ситуация.

Мэтт Катс в интервью на searchengineland говорит о том, что они много работы проделали для того, чтобы один человек не смог негативно подействовать на сайт другого человека. Имеется в виду негативное влияние ссылок. Также он говорит, что плохие ссылки в глаза Пингвина игнорируются, а не негативно сказываются на ранжировании ресурса.

Почему же тогда многие проекты потеряли столько трафика? Если эти сайты по большей части держались в ТОПах из-за покупного ссылочного, то оно для них перестало действовать. По внутренним же факторам они не дотягивали до хороших мест в выдаче. Другими словами, определяющий на тот момент ссылочный фактор, который держал проекты в десятке, потерял свое былое значение. По большей части, действию алгоритма не подверглись старые трастовые сайты с хорошей контентной составляющей и естественными ссылками. C этими выводами, конечно, можно спорить, потому как попадаются частные ситуации, которые выбиваются из общей картины. Это, на мой взгляд, недостаток, присущий любым алгоритмам и фильтрам, которые несправедливо наказывают качественные ресурсы.

Google Penguin анонсировался 24-25 апреля. На самом же деле, по моим наблюдениям, его влияние началось несколько ранее. Это можно увидеть и на моем графике и на некоторых других.

Мэтт Катс говорит, что если на вашем сайте упала посещаемость с ПС google, то это не говорит о том, что постарался Пингвин. Борьба с низкокачественными ссылками происходит давно. Я думаю, что он все-таки лукавит, а действовать данный алгоритм начал немного раньше его официального запуска.

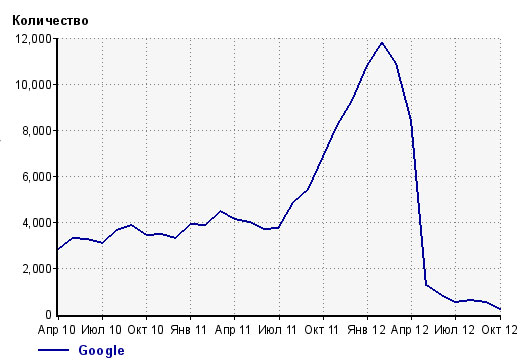

Анализируя посещаемость блога с гугла за последние полгода, я сделал вывод, что алгоритм по большей части затрагивал конкретные страницы, а не сайт целиком или отдельные запросы (поэтому статистику по отдельным ключевым словам я не рассматриваю в этом посте). Например, на некоторые документы трафик с этой поисковой системы не упал.

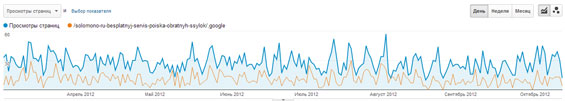

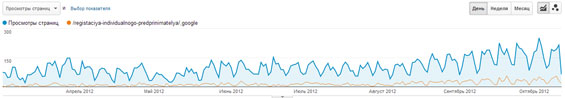

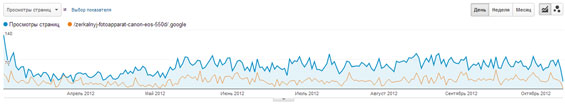

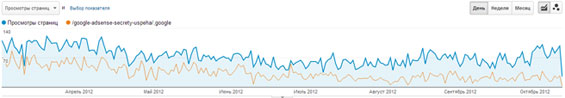

Все графики с google analytics увеличиваются по клику (в новом окне). Синяя линия - это общее число просмотров страницы, оранжевая - переходы с гугла.

А по некоторым увеличился.

На все эти страницы не приобретались ссылки. Текст, соответственно, писался для людей . Это лишний раз подтверждает, что просто нормальные страницы с нормальным контентом и без внешнего продвижения ведут себя стабильно. Выявить те документы, на которых подросла посещаемость или осталась на том же уровне также полезно. Они станут "примером подражания" для остальных. То есть, анализируя их, можно понять, что нравится поисковой системе, ее алгоритму.

Как выявить проблемные страницы?

Способ №1.

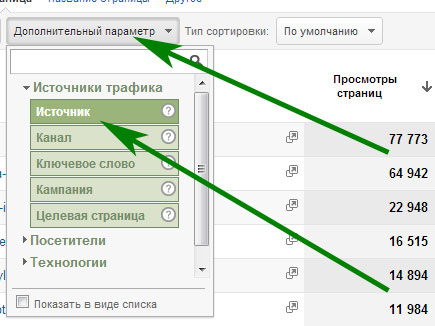

Разберу на примере Google Analytics. Сначала необходимо определить на какие документы шло больше всего посетителей с гугла. Заходим "Содержание" -> "Обзор" -> "Содержание сайта" -> "Все страницы". Далее нужно внести дополнительный параметр по трафику с поисковиков. Для этого нужно нажать "Дополнительный параметр", затем "Источник трафика" -> "Источник".

Появится список самых посещаемых документов в разрезе с источниками. Нужно смотреть на те строки, где числится google.

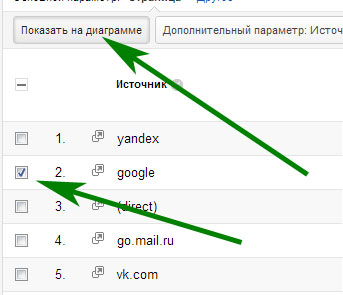

Например, кликаем на первую страницу, на которую за выбранный период приходился максимум посетителей с гугла. Далее также добавляем параметр "Источник". Нажимаем чекбокс на строке, где красуется "google" и кликаем "Показать на диаграмме".

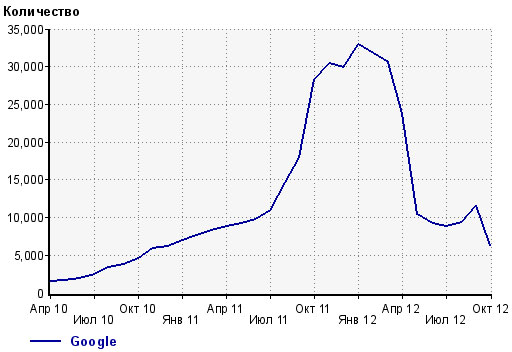

Таким образом, получаются графики, которые я публиковал выше (с общим трафиком на документ и посетителями с гугл). Вот примеры со снижением количества ежесуточных посетителей.

Видите, посещаемость упала, но не пропала. Я проверил некоторые запросы в поисковой выдаче. Они упали на 5-15 позиций. Существенно для снижения количества посетителей, но не совсем критично для видимости сайта в ПС (позиции в пределах ТОП 10-20).

В идеале, так нужно посмотреть все страницы, которые приносили с данной поисковой системы хотя бы какой-то трафик, но не ниже 100-200 в месяц. Если будет меньше, например, 1-2 посещения в сутки, то по данным полученного графика можно сделать неправильные выводы.

Найденные страницы, на которых упал трафик, нужно проверить на:

- Качество контента. Возможно, ваш документ ранее не заслуживал высоких позиций. Гугл просто восстановил справедливость. В таком случае, нужно поднять его качества.

- Переспам в ключевых словах, нечеловеческие словоформы. Тексты для людей становятся более актуальными. В этом пункте нужно "очеловечить" существующие тексты.

- Переспам в анкор-листе, например, прямыми вхождениями. Необходимо разбавить ссылочную массу: изменить старую, либо дополнительно создать "естественную" новую.

В некоторых случаях нужен комплексный подход. Что касается малопосещаемых страниц, низкочастотных запросов и длинного хвоста, то, на мой взгляд, посещаемость на них и по ним может вернуться, когда с основными трафикогенерирующими документами будет все в порядке. Вернется доверие и траст со стороны поисковика (в случае если со страницами будет все нормально, а в алгоритме заложено взаимодействие анкор-листа страницы с анкор-листом всего сайта). "Нормализация" анкор-листов отдельных документов приведет к "нормализации" анкор-листа всего проекта.

Это я разбирал по аналитиксу. В статистике liveinternet тоже можно делать подобное, но необходимо добавить срез по поисковой системе гугл. К сожалению, если ранее он у вас не был установлен, то данные по посещаемости конкретных страниц с конкретных источников получить нельзя. По крайней мере, я не смог найти. Если вы знаете, как это сделать, то напишите в комментариях . Правда, можно анализировать посещаемость страниц (здесь же можно и запросов) в целом. В таком случае, конечно, могут появиться погрешности, но все равно картина должна быть понятна. Насчет метрики и других сервисов статистики ничего не могу сказать.

Способ №2.

В первом способе анализ шел от полученных изменений. Второй способ попроще, но подольше. Нужно "вручную" проанализировать каждую страницу вашего ресурса на качество контента, а также обратные ссылки на предмет переспама анкор-листа. Довольно-таки не технологический способ, но в некоторых ситуациях не менее эффективный.

Этот пост является началом эксперимента по возврату посещаемости. В нем я рассказал, как можно искать проблемные страницы и немного затронул особенности самого Google Penguin. В следующей части эксперимента, который должен выйти после очередного апдейта этого алгоритма (последний был 5 октября), я расскажу, что делал и что из этого получилось. Надеюсь, что мне удастся вернуть тенденцию развития посещаемости с гугла.

А вас коснулся гугловский пингвин? Получилось найти проблемные документы на сайте? Что-нибудь предпринимали или пускали на самотек? Чего получилось добиться? Жду ваши отзывы и мысли в комментариях .

У меня после Пингвина несколько сайтов просело. Но тенденции именно по отдельным страницам замечено небыло. Фильтр накладывается как бы на весь домен. Причём по большеё части на ВЧ ключевики по НЧ трафик продолжает идти. Плюс наблюдалась смена релевантной страницы в выдаче. Например под запрос «купить телевизор» была специально заточеная страница, которая висела в ТОП 10, после пингвина эта страница исчезла из выдаче, а где-то за ТОП 50 появилась страница заточеная под запрос «телевизоры самсунг», и теперь показывается по запросу «купить телевизор», но только как уже написал, на позициях за ТОП 50. Причём заметил, что если поставить несколько ссылок с чистым вхождением анкора «купить телевизор», на страницу «телевизоры самсунг», то она через пару недель исчезает из выдачи. Таким образом даже получилось вернуть пару запросов, правда не на такие хорошие позиции, как раньше.

Прежде всего, Сергей, спасибо вам за проделанную работу.

На моем блоге картина в принципе не изменилась: трафик как рос, так и продолжает расти. Но я и не закупал большого числа ссылок, не переспамливал тексты. По идее, даже наоборот должен был вырасти трафик с гугла, но нет.

В общем, я вообще не заметил появления нового алгоритма =)

Большое спасибо за статью. Ваше замечание о том, что проверять нужно прежде всего качество контента и ключевики на самом сайте, а ссылки — уже во вторую очередь, заставило меня пересмотреть текущую работу над пострадавшими сайтами.

Кстати, может быть посоветуете, что делать с интернет-магазином, у которого посещаемость с Google не превышают 5-10% от всего трафика с ПС, а по большинству коммерческих запросов магазин находится за 10 страницей поиска?

Мне кажется, что с Яндексом в этом плане проще. Вначале сложнее раскрутиться в яндексе, так как он с большим недоверием относится к новым сайтам. У Google более лояльная политика к новым сайтам, но здесь важно держаться, так как много подводных камней. Как бороться с данным фильтром? Наверное, не нужно идти легким путем — путем массовой закупки ссылок

по-моему тут вывод один (в принципе для чего все эти фильтры и накладываются) — пишите тексты в первую очередь для людей. тем более сейчас все алгоритмы совершенствуются, и точное вхождение ключевиков не так уж и необходимо =)

Сделал следующее: Отыскал все копии статей в интернете — получилось 267 копий. Пожаловался в Гугл на несоблюдение авторских прав- в течение 2 недель все копии были удалены из индекса.

Часто текстов (10-15% от общей массы сайта) были копипастом — их переписал до 100% уникальности и увеличил объемы статей с 1000-1500 символов до 2500-3000 символов.

Ссылочного на сайт вообще не покупалось. Контентный проект.

Пока никаких изменений. Ждем дальше.

Спасибо. Прочитала. Но разобралась не до конца. Вернусь ещё раз к этой статье в ближайшее время.

seostager, Самое простое всегда истинно.

Попробую воспользоваться способом № 1. Не все пока понятно, думаю, что разберусь. Ну, проблемные страницы, держитесь.

Автору спасибо за статью. Много нового для себя узнала

Сдается мне, что ты, Сергей, как и многие банально путаешь Пингвина и Панду…

Судя по тому, что вжарило тебя не четко 24.04 или же 25.05, а еще раньше, и по тому, что позиции не выкинуло за 100, то это Панда — переспам контента, а не Пингвин — ссылочный переспам… Так что перепиши заголовки с точных вхождений ключевых фраз, и будет тебе реабилитация… Пингвин четко определяется сроками удара + однозначным вылетом практически всех (в моем случае 98%) позиций за сотню, то есть отнимает 98% трафика из Гугла, а не как у тебя — по отдельным статьям просто позиции просели…

Рекомендую попробовать разобраться в отличиях, а то из-за массовой паники вокруг Пингвина многие блоггеры про существование других фильтров вообще забыли и поголовно вводят читателей в заблуждение.

Sickboy,

будьте любезны,подскажите, а куда же в гугле на воров можно пожаловаться?

Вадим, я не делаю акцент на внутренних изменениях. Google Penguin — это в основном внешние ссылки :).

Работать над магазином. Коммерческого трафика в гугле всегда было меньше.

nikolas_sharp, были сомнения на этот счет. Мониторил я последние апдейты гугла seomoz.org/google-algorithm-change . В принципе попадает Panda 3.4 — March 23, 2012. Но на втором графике (сразу после моего) посещаемость сайта, у которого позиции ушли за сотню. По графику видно, что это случилось ранее чем 24-25 апреля. Еще, на основные страницы, на которых упала посещаемость ранее как раз приобретались ссылки с преимущественно одинаковыми анкорами. После изменений буду следить за обновлениями алгоритмов. Если это будет Панда, то с удовольствием изменю пост

Тексты для людей — это конечно замечательно, но как продвигать интернет-магазин, если не покупными ссылками? только контекстной?

Андрей, можно и покупными ссылками, только создавать ссылочную массу нужно с умом, не переоптимизируя анкор-лист.

Я заметил, чем меньше покупных ссылок на сайт, тем и пингвин меньше. На одном моем покупных вообще нет, правда он и без монетизации и пингвин ему только плюсики дал.

На моем сайте 24 апреля было резкое падение, но я не знал, с чего начать, да и времени не было заняться, поэтому пустил на самотек. В итоге посещаемость вернулась.

s018.radikal.ru/i508/1210/d6/51f6517b603e.jpg

18 сентября был апдейт панды. Посещаемость также резко упала. Но не вернулась.

s45.radikal.ru/i108/1210/5b/254118b79aff.jpg

На маултоке посоветовали поработать над заголовками и уменьшить оптимизацию контента

Буду пробовать…

Блог практически никогда не продвигался покупными ссылками (за все время было куплено не более 10 ссылок с блогов). Видимость в ПС Google упала просто критично. Продвигал внутренней оптимизацией, размещение статей, регистрация в каталогах (ручная без фанатизма), dofollow, обмен (без фанатизма).

Так что исследование интересные, но не отвечает на все вопросы, по крайней мере в Украине это так.

с моим сайтом от первого пингвина и с приходом панды ничего не было! но 5 Октября погнал резкий спад посещаемости и позиций. Движок dle. Когда я всё это приметил то, заметил что проиндексировался текст с ключевыми запросами на page/2 — хотя второй страницы в природе не существовало… но по особенностям движка оптимизированный текст там отображался. так же в интернете приметил копии сайта, на которые уже пожаловался и их уже удаляют. но фишка в том, что по среднечастотному запросу сайт сейчас поднимается хотя по вч ещё не видно. Веду работы с закрытием дублей на страничках, так как ссылок никаких не покупал.

maksimus, как раз 5 октября было обновление пингвина

просто нужно с самого начала делать СДЛ’ы, а не ГС и все будет нормально)

На пингвина надо поставить капкан Думаю вебмастера что-нибудь придумают, со временем…

Думаю вебмастера что-нибудь придумают, со временем…

seoak, вы считаете этот сайт ГС?

у меня ваще с гугла трафик ушёл, он и так был небольшим….

Мне порой кажется, что выйти в топ, яндекса стало намного легче чем в гугле

Много нового узнала, спасибо за подробную статью, буду изучать, разбираться

Будем ждать конца результата)

Тексты для людей пишите сколько угодно, пингвину все равно на него это не действует уже проверенно, копипаст — вот что нужно, находите сайты с качественным уникальным контентом для людей, но которые почему- то попали под фильтр гугла. Далее делаете себе нулевой сайт, и скопипастте все новости с этих сайтов чем больше тем лучше. Через пару месяцев посещаловка с гугла поднимется до небес, вот такой вот этот пингвин — непонятный, одна надежда на то, что он поумнеет ибо примеров выведения сайта из под этого фильтра видеть пока не доводилось.