Clean-param Пам-Пам или об одном простом способе закрытия страниц от индексации в Яндексе

Если сделать опрос среди вебмастеров/оптимизаторов, слышали ли они про директиву Clean-param (от англ. clean parameters — чистые параметры), то практически все ответят положительно. Но если задать вопрос про ее использование, то ответы будут уже отрицательными. Что же это за такой зверь, которого все боятся и "с чем его едят"?

Для кого будет полезен Clean-param

Могу поздравить тех, кто до сих пор с потом на лбу читает про эту директиву . В большинстве случаев применять ее не нужно. Но также есть достаточно большой пул проектов, для которых ее применение необходимо или желательно:

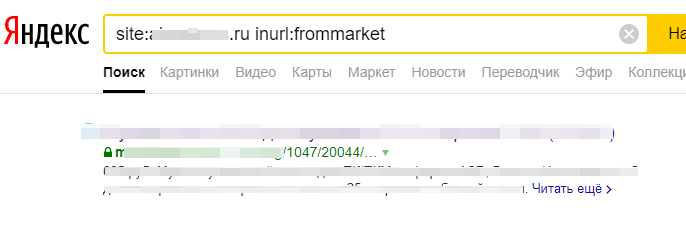

1. Рекламируются на сторонних площадках, а переходы осуществляются не по прямым ссылкам. Например, при переходе с Яндекс.Маркета открывается URL с параметром frommarket.

В данном случае в индексе оказывается страница мобильной версии на поддомене. На ней стоИт междоменный rel="canonical", который не учитывается Яндексом (хотя были случаи, когда учитывался).

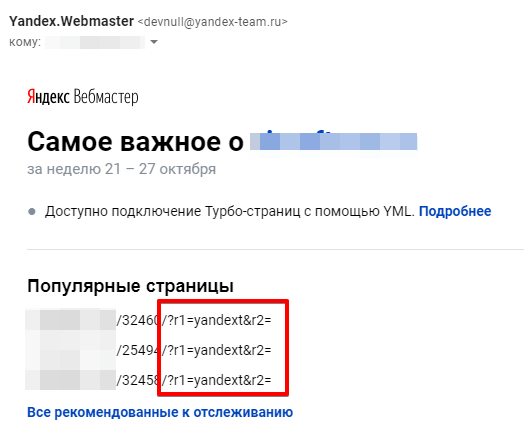

Вот другой случай проиндексированных документов с параметрами.

2. Используют UTM-метки во внешних ссылках. Например, таким образом отслеживают эффективность рекламных каналов.

https://sosnovskij.ru/catalog/?utm_source=yandex&utm_medium=cpc&utm_campaign=audit

3. Содержат в URL параметры, не меняющие содержание страницы, например, идентификаторы сессий.

https://sosnovskij.ru/index.php?sessionID=jf1d3ks2fj7dss3fs33

4. Имеют большие масштабы — от нескольких десятков тысяч документов.

Робот Яндекса не будет каждый раз перезагружать страницы с множеством параметров (указанные в директиве параметры будут "опускаться" или не учитываться, как будто их и нет — объединяться в рамках одного URL). Тем самым краулинговый бюджет будет направлен на по-настоящему важные страницы. Дополнительно улучшится индексация сайта (ускорится переиндексация), в индекс будут быстрее попадать новые материалы, уменьшится нагрузка на сервер.

Как применять директиву?

Директива прописывается в robots.txt в любом месте файла. В примерах официальной инструкции clean-param всегда указывался после User-agent: Yandex.

Я уточнил, обязательно ли указывать директиву именно для Yandex (я сторонник не плодить лишних юзер-агентов в роботсе, если на то нет объективных причин). Ответили следующее:

Директива Clean-param - межсекционная, поэтому будет учитываться в любом месте robots.txt, как для User-Agent: *, так и User-Agent: Yandex

Например, необходимо, чтобы все приведенные примеры не попадали в индекс (+ добавлю openstat):

- https://sosnovskij.ru/catalog/3447/magazin/?frommarket=

- https://sosnovskij.ru/catalog-old/54347/?r1=yandext&r2=

- https://sosnovskij.ru/catalog/?utm_source=yandex&utm_medium=cpc&utm_campaign=audit

- https://sosnovskij.ru/index.php?sessionID=jf1d3ks2fj7dss3fs33

- https://sosnovskij.ru/page.php?_openstat=dTsx2MjM0OzU2Ndzg5O3lhbmRleC5ydT54pwcmVtaXVt

Добавляем в robots.txt в любое место под User-Agent: * или под User-Agent: Yandex (если есть оба, то под User-Agent: Yandex) следующие правила:

Clean-param: frommarket /catalog*/magazin/

Clean-param: yandext /catalog-old/

Clean-param: utm_source&utm_medium&utm_campaign /catalog/

Clean-param: sessionID /index.php

Clean-param: _openstat /page.php

Директива состоит из 2-х важных частей (с пробелом между ними):

1. Параметр. Здесь указываются параметры, которые необходимо игнорировать поисковому роботу (в примере "frommarket", "sessionID" и т.д). На 3-й строчке вы можете видеть конструкцию со знаком "&". Амперсанд используется в качестве аналога логического союза "и", объединяя параметры в одну строку. Этот момент я также уточнял у службы поддержки Яндекса. Мой вопрос:

Здравствуйте! Подскажите, пожалуйста, по использованию &" в директиве clean-param. Оно трактуется как "и" или "или"? То есть, например, имеются следующие URL:

- /category/1/?page_count=12 (только параметр page_count)

- /category/1/?pgen=3 (только параметр pgen)

- /category/1/?page_count=12&pgen=3 (и page_count, и pgen).Если директива будет указана следующим образом:

Clean-param: page_count&pgen /category/

То она затронет все URL или только последний? Если последний, то корректнее будет следующий вариант?

Clean-param: page_count /category/

Clean-param: pgen /category/С уважением, Сергей.

Ответили достаточно быстро:

Воспринимается как "и". Вы вполне можете использовать директиву Clean-param: page_count&pgen, хотя и второй вариант ошибкой не будет.

В общем, советую использовать "&" только тогда, когда указанные через амперсанд параметры используются в URL всегда вместе. В остальных случаях лучше написать дополнительное правило.

2. Префикс. Путь до URL с параметром. Здесь указываем маску урлов, как при стандартном закрытии страниц в rotobs.txt. Можно использовать знак звездочки "*" в качестве замены любого количества символов. По умолчанию "*" неявно проставляется в конце префикса (в конце дополнительно звездочку ставить не нужно).

Кидайте в комментарии ваши примеры URL, которые необходимо "закрыть" с помощью Сlean-param. Я напишу, какую директиву добавить в robots.txt .

Некоторые особенности

- Учитывается регистр. UTM и utm — это 2 разных параметра. То же самое и в префиксах.

- Указывайте параметр полностью. Не "utm", а "utm_source". Вдруг у вас сайт на ЧПУ и есть материалы про такие популярные темы как: дутма (dutma), бутман (butman) или рекрутмент (rekrutment)

.

- Подобные документы с различными параметрами можно закрывать и стандартными методами (canonical, <meta name="robots" content="noindex. nofollow"> и т. д.), но их не всегда возможно реализовать (необходимо дорабатывать код сайта). Дополнительно rel="canonical" Яндекс не считает за строгое правило. Clean-param в некоторых случаях может быть надежнее и проще. Да и поисковому роботу не придется перебирать значения параметров. Как итог — ускорение и более полная индексация сайта.

Расскажите, а вы когда-нибудь использовали Clean-param в своей практике? Если да, то для каких случаев. Будет интересно ознакомиться с вашим опытом .

(14 голос., в среднем: 4,71 из 5)

(14 голос., в среднем: 4,71 из 5) Megaindex — сервис автоматического продвижения + партнерская программа и 300 рублей на счет.

Megaindex — сервис автоматического продвижения + партнерская программа и 300 рублей на счет.  Схемы взаимодействия с заказчиком на продвижение сайта

Схемы взаимодействия с заказчиком на продвижение сайта  Кейс по созданию и распределению семантического ядра для сайта

Кейс по созданию и распределению семантического ядра для сайта

А как убрать вообще все параметры из индексации, я делал disallow *?

В некоторых случаях (например, когда стоят ЧПУ) Disallow: /*? может быть проще. Но если на нормальных страницах стоят параметры с «?», то такой метод уже не подойдет .

.

Использовать, после того как в индекс попали utm-метки. Сами Платоны так посоветовали

Я от всех этих кодов довольно далёк, по этому всегда интересно почитать подобную информацию.

Если ссылки с метками идут прямо на домен (site.ru/?utm_pid) и на страницы продуктов (site.ru/product/?utm_pid), то Clean-param будет выглядеть как?

User-agent: Yandex

Disallow:

Clean-param: utm_pid /

?

Да:

Clean-param: utm_pid /

Интересно, если ссылки с метками могут идти на любую страницу сайта (есть партнерская программа и партнерские метки), то что лучше использовать:

Clean-param: utm_pid /

или сразу

Disallow: *?

?

Яндекс советует clean-param.

А недавно и Google советовал не закрывать URL с параметрами через robots.txt. Он для таких страниц советует использовать rel=»canonical».

Привет

Прочитал в Яндекс.Справке, что clean param используется только для адресов, содержимое которых не меняется.

А для get параметров сортировок и поиска по карточкам нужно прописывать? Например, поиск над каталогом проектов формирует следующие адреса /sadovye-proekty?search=4821§ion=3924&price=174800-465440&size=5-10&area=23-94&float=2

Привет. Скинь, пожалуйста, ссылку на справочную страницу

Во-первых — спасибо за статью! Наконец я нашел то, что искал в более доходчивой форме.

Во-вторых вопрос как раз по тому же поводу.

Мне нужно чтобы clean-param говорил роботу игнорировать всё, что не домен. По логике примеров мануала с Яндекса (и перепечатанных вариантов с других сайтов) — тоже просто оставил » / «.

То есть, для вида страниц: site.com/?code=adapdlktv4

Параметры получились следующие:

User-agent: Yandex

Clean-param: code /

Но инструмент Яндекса «Анализ robots.txt» меня за эти строки наругал.

Теперь решил сделать иначе, добавив к слэшу «звёздочку». Яндекс перестал ругаться. Вопрос только в том: верна ли моя логика и нужно ли еще поставить один «слэш» за «звёздочкой» (Яндекс принимает два варианта) ?

так:

—

User-Agent: *

Clean-param: code /*

—

или так:

—

User-Agent: *

Disallow:

Clean-param: code /*/

Добрый день, Артем! Спасибо за отзыв. Попробуйте вариант без слеша, Яндекс не должен ругаться

User-Agent: *

Clean-param: code

Добрый день, Сергей!

Благодарю за ответ. В итоге пришлось так и сделать. В анализаторе (как и писал ранее) — ошибок мои варианты не выдавали. Хотя странно, потому как через день/два приходит отчёт о том, что есть ошибка.

В итоге написал в ТП Яндекса, чтобы разъяснили конкретно по моему примеру. Мне ответили, что тогда вообще ничего не нужно дополнительного, только слово «code» (как в Вашем ответе мне).

P.S. И, отдельно нюансик по Тильде (может кому пригодится).

В Тильде нет прямого доступа к robots.txt , есть отдельно раздел «clean-param». Но там просто пустое окно. Если туда вносить полностью текст, с названием параметра «клин» (типа моего «Clean-param: code» ) — тогда Яндекс ругается и выдаёт ошибку. Случайно заметил, как отображается эта строка в robots.txt на стороне Яндекс.Вебмастер. Оказалось, что там тогда получается дубль: «Clean-param: Clean-param: code» . То есть, в Тильде уже изначально в коде, который мы не видим, стоит название параметра и ничего дополнительно добавлять не нужно. Вписал просто слово «code» — и вуаля! У анализатора robots.txt — претензий нет, у анализатора сайта — снялась критическая претензия по поводу get-параметров!

Наконец я это победил!

Добрый день, Артем! Спасибо за опыт

Я в роботсе использовал это, не помогло:

User-Agent: *

Disallow: /?q=

Disallow: /?sphrase_id=

Это не Clean-param

Добрый день, если нужно убрать страницы с метками или дубли, то перед директивой clean param нужно указать Disalow: ?

Пример

Disallow:

Clean-param: form /goods/

Clean-param: form /catalog/

Clean-param: utm_source&utm_medium&utm_campaign /catalog/

Clean-param: utm_source&utm_medium&utm_campaign /goods/

Clean-param: page /catalog/

Clean-param: page /goods/

Правильно ли я указал? Чтобы все дубли содержащие в с каталоге и товарах url такие слова: *page* *form* *utm_source* и тд не индексировались?

Проблема в том, что в поиск попадают такие страницы:

car-better.ru/catalog/C30?&only_body=1&page=5

car-better.ru/catalog/zestech?&only_body=1&page=3

car-better.ru/news?sid=1

Добрый день! В данном случае Вам необходимо вместо Clean-param использовать Disallow.

Для Clean-param не обязательно указывать Disallow перед директивой.

А если нужно исключить параметр со всего сайта?

Clean-param: test *

Или /* ?

Clean-param: test /

домен.ру/категория1/товар.html?show=reviews

Здравствуйте. Подскажите, пожалуйста, как правильно написать clean-param для такого вида ссылки? Яндекс ругается на show=reviews. И как такое же сделать для гугла? Хотя стоит тег canonical, но на всякий случай и для него хотелось бы тоже…

Добрый день, Юлия! Несколько моментов:

1. Clean param в основном используются для URL с сессиями, сторонними параметрами, которые не меняют содержимое страницы. В Вашем случае содержимое, скорее всего, будет меняться.

2. Точно ли нужно закрывать такие документы от индексации? Пришлите, пожалуйста, пример.

3. Как и где ругается Яндекс?

4. Если страницы все-таки нужно закрыть от индексации, то универсальный метод для Яндекса и Google — meta name=»robots» content=»noindex» или x-robots-tag

Добрый день. Если мне нужно на всех уровнях вложенности сайта закрыть get-параметр clear_cache, то я должен просто прописать: Clean-param: clear_cache / ??? А как быть в таком случае с поисковиком Google? Возможно более правильным будет данный способ Disallow: /*?clear_cache=Y. Спасибо.

Примеры страниц:

_https://site.by/info/brands/meibes/?clear_cache=Y

_https://site.by/catalog/teplonositel/26975/?clear_cache=Y

_https://site.by/catalog/truby_i_fitingi/uplotniteli/index.php?del_url=&clear_cache=Y

_https://site.by/catalog/truby_i_fitingi/uplotniteli/?SHOWALL_1=1&clear_cache=Y

Да, все верно.

Яндекс к Disallow в robots.txt относится хорошо. Google, как правило, не всегда хорошо. Методы для обоих поисковиков:

1. x-robots-tag

2. meta name=»robots»

Подскажите, как лучше директиву проставить для такого вида ссылок:

_https://site.ru/catalog/rabota-i-ucheba/

_https://site.rucatalog/rabota-i-ucheba/?PAGEN_1=2

_https://site.ru/catalog/rabota-i-ucheba/?PAGEN_1=3

_https://site.ru/catalog/interier/

_https://site.ru/catalog/interier/?PAGEN_1=2

_https://site.ru/catalog/interier/?PAGEN_1=3

Яндекс ругается на то, что дубли страниц, содержимое страницы меняется динамически пролистывании новой страницы.

Директиву clean-param придется прописывать под каждую категорию? Или есть какой-то универсальный способ?)

Заранее спасибо!

Здесь клин парам не очень подойдет. Лучше meta name=»robots» или x-robots-tag. Будет актуально и для Google также. Только в том случае, если нужно запрещать страницы пагинации к индексации.

Добрый день!

Можете поподробнее описать, что делать со страницами поиска, в которых различие только в Get параметре.

В остальном Яндекс считает страницы дублями и выдал в Вебмастере критичную ошибку.

Примеры страниц:

_https://energo1.com/catalog/?q=%D0%92%D0%94%D0%9F%D0%91-5

_https://energo1.com/catalog/?q=%D1%8D%D0%BA%D0%BE

_https://energo1.com/catalog/?q=%D0%B4%D0%B0%D0%B7%D0%BE

_https://energo1.com/catalog/?q=4%D0%9F%D0energo1.com%2Fcatalog%2Fe

_https://energo1.com/catalog/?q=%D1%8D%D1%82%D0%B2-20

Каким способом все-таки закрывать такие страницы: clean-param или disallow.

disallow прописали, не помогло:

Disallow: /*?q=

Disallow: /?q

Добрый день! Здесь не совсем меняется только GET-параметр (то есть cleam param не совсем подойдет). Это страницы результатов поиска с разным содержимым. Если специальным образом не управлять такими документами, то их необходимо закрыть от индексации.

1. Для Яндекса хватит добавление правила Disallow: /*?q= в robots.txt. Удаление из индекса происходит не сразу. Возможно, стоит подождать.

2. Универсальный вариант, включая для Google — добавление на страницы meta name=»robots» content=»noindex, nofollow» или аналогичные правила в X-Robots-Tag.

Доброго времени суток! Подскажите подойдет ли клин парам и как правильно прописать:

_https://site.ru/protivopozharnye_dveri_price?yhid=20766602190741452

_https://site.ru/protivopozharnye_dveri_price?yhid=6452829849929383935

_https://site.ru//protivopozharnye_dveri_price?baobab_event_id=kqhu01jkyw

Если нет, то как правильнее закрыть индексирование подобных страниц?

Добрый день, Татьяна! Да, для Яндекса подойдет clean param:

Clean-param: yhid /

Clean-param: baobab_event_id /

Спасибо огромное!

Добрый день. Подскажите пожалуйста, мне нужно на всех уровнях вложенности закрыть get-параметр baobab. Верно я понимаю, что мне нужно прописать следующую команду: Clean-param: baobab /

Заранее спасибо за ответ.

Примеры страниц:

_https://сайт/zapchasti-dlya-gazonokosilok.html/?baobab_event_id=kqgi2n5tj5

_https://сайт/zapchasti-dlya-benzopil.html/?baobab_event_id=kqeygr6sqi

_https://сайт/parts.html/?baobab_event_id=kqg8otrkx5

_https://сайт/zapchasti-dlya-motoblokov.html/?baobab_event_id=kqgkqv0hdz

Добрый день, Александр! Да, верно

Можно ли лишь часть малопосещаемых страниц закрыть, но не весь параметр page=

Clean-param: page=11

Clean-param: page=12

а все остальные разрешить? Если да, то как записать в одну строку?

Если нет, то что посоветуете?

—

Опишите Вашу задачу подробнее Директива Clean-param главным образом служит для несканирования/неиндексирования документов с параметрами в Яндексе.

Директива Clean-param главным образом служит для несканирования/неиндексирования документов с параметрами в Яндексе.

Если Вам необходимо закрыть различные страницы без параметров (например, страницы пагинации), то лучше использовать другие способы:

— meta name=»robots»;

— x-robots-tag.

У меня 27 страниц В-О (вопросов-ответов — в комментах), Яндекс каждую ‘?page=’рассматривает как самостоятельную в поиске (Гугл, говорят, как-то иначе, знаете как?). И часть лучше посещается, а некоторые крайне редко. Вот и хочу оставить только посещаемые страницы в индексе Яндекса.

В Вашем случае я бы использовал не Clean Param, а meta name=»robots» или x-robots-tag.

Здравствуйте!

Сегодня в webmaster пришло сообщение «Найдены страницы-дубли с GET-параметрами» — используйте Clean-param.

В целом все ясно, хотя давно использовали canonical, но возник вопрос: у нас есть get-запросы вида:

1. /stellazh_sb-220m.html?attribute_values%5B53%5D=28210

2. _https://adas-mebel.ru/polka-torcevaya-so-skosom-ats-30-dlya-kuhni-shantal-2.html?attribute_values%5B2220%5D=67937

Т.е. используется динамический параметр attribute_values[53] — где между скобок может быть цифра от 1 до 1000.

Как я понял из документации, в нашем случае использовать регулярное выражение не получится. Т.е. остается либо добавлять +1000 строк в robots.txt, либо использовать Disallow.

Вопрос собственно такой — что корректней и лучше в данном случае — Disallow или 1000 новых строк в robots.txt ?

Спасибо

Добрый день, Дмитрий! Canonical для поисковых систем рекомендация, а не строгое правило. Тег не гарантирует неиндексацию документов.

Вам можно использовать такую конструкцию в robots.txt

Clean-param: attribute_values /

Будут затронуты все URL сайта, включающие параметр attribute_values.

К сожалению, указанная вам конструкция:

Clean-param: attribute_values /

не дала необходимого результата

_http://joxi.ru/4AkKLlSowpLaAq

Прошу прощение, не корректно прочитал исходные URL. Когда много похожих параметров в GET, то их по маске закрыть не получится. Я уточнил этот момент в службе поддержки Яндекса:

Здесь тогда проще использовать Disallow, но я бы советовал использовать директиву только для юзер-агента Yandex.

Здравствуйте!

Яндекс прислал уведомление о дублях с GET параметрами. с рекомендацией использовать Clean-param

Но! как в эту директиву внести параметры допустим по маске? а то параметров в гет у нас море

Вот пример урл;

catalog/411/1202/1207/?param-622=6935

catalog/411/1202/1207/?param-627=7726

catalog/411/1202/1207/?param-822=8044

Как раз выше об этом написал в ответе Дмитрию + ответ от службы поддержки Яндекса. По маске, к сожалению, никак.

Добрый день! В комментариях вы пишите о том, что для страниц, на которых содержимое меняется, clean-param не подходит. А вот как узнать меняется оно или нет? В Вебмастере нашла более 30 различных get-параметров и как понять, что ставить в clean-param, а что закрывать мета-тегом robots, например site.ru/?_r=5976 или site.ru/product/nabor/?STAR=3 ?

Добрый день! Если при смене значения параметра (например, числа) содержимое страницы не меняется (визуально сравнить 2 страницы), то значит этот параметр можно добавить в clean param.

site.ru/?_r=5976 — параметр для главной страницы. Скорее всего, при его изменении не будет меняться содержимое — можно в clean param.

site.ru/product/nabor/?STAR=3 — здесь посмотрите, меняется ли содержимое документа при изменении цифры 3.

Спасибо! А если вот такой параметр site.ru/?login, у которого не указано значение?

Попробуйте так:

Clean-param: login /

Обязательно проверьте в инструменте «Анализ robots.txt» в Яндекс.Вебмастере.

Зачем дублировать лишние Clean-param, когда несколько параметров можно прописать одной строкой. Сам Яндекс так делает, если посмотреть его robots.

Вместо:

Clean-param: utm_campaign /

Clean-param: utm_source /

Clean-param: utm_medium /

Так:

Clean-param: utm_campaign&utm_source&utm_medium /

Это же работает идентично.

По моему вы что-то не так поняли.

Это некритичный момент: можно в несколько строк, можно в одну. Если параметров много, то лучше объединить в одну строку. Если мало, то совсем не критично. У самого Яндекса есть разбивка по строкам. Так легче администрировать директиву.

Добрый день! Подскажите, пожалуйста. Вот такого вида дубли:

_https://me1.ru/Modul-nyie-gostinyie/?manuf=1139

_https://me1.ru/Modul-nyie-gostinyie/?manuf=1153

_https://me1.ru/Stellaji-i-vitrinyi/?page=11

_https://me1.rue/Stellaji-i-vitrinyi/?page=6

Как правильнее закрыть от индексации? Так:

Clean-param: manuf /Modul-nyie-gostinyie/

Clean-param: page /Stellaji-i-vitrinyi/

или так:

Disallow: /page?

Disallow: /manuf?

Спасибо.

Добрый день, Вячеслав! Если речь только о Яндексе, то подойдет clean param. Единственное, я бы внимательнее изучил страницы с page=. Вероятно, это страницы пагинации. Их не всегда закрывают от индексации (по ситуации).

Если речь и о Яндексе, и о Google, то рекомендую x-robots-tag или meta name robots.

Сергей, добрый день!

Подскажите, пожалуйста, возможно ли использовать директиву на весь каталог в магазине или придется прописывать каждый подраздел отдельно? Пример:

1. сайт.ru/product-category/trubi-i-fitingi-pvc-u/fitingi-pvc-u/razemnye-mufty-pvh/perehodnye-razemnye-mufty-rro-fit-pvh/?query_type_material=or

2. сайт.ru/product-category/pe-fitingi/elgef-plus/troyniki-gf-elgef-plus/?query_type_material=or

Сама директива выглядит следующим образом:

User-agent: Yandex

Clean-param: query_type_material /product-category/*

Спасибо!

Добрый день, Алексей! Да, можно использовать директиву на весь каталог и не указывать каждый раздел или категорию отдельно.

Здравствуйте!

появились новые страницы в индексе:

site.ru/category?amp;utm_medium=ssylki&page=29

site.ru/category?amp;utm_medium=ssylki&page=30

site.ru/category?amp;utm_medium=ssylki&page=3

site.ru/otzyvy?amp;set_science=1

пробовал закрыть вот так:

Clean-param: amp;utm_medium

не получается

честно говоря первый раз вижу параметр с точкой с запятой ;

Disallow: /*?amp — это работает, можно закрыть,

но интересно ваше мнение, можно ли в данном случае настроить Clean-param

Добрый день! Да, действительно, с точкой запятой никогда не видел. Попробуйте такую конструкцию:

Clean-param: utm_medium /

Clean-param: set_science /

В Яндекс.Вебмастер есть инструмент проверки robots.txt. Там можно задать произвольные URL с такими параметрами и посмотреть, как они обрабатываются Яндексом.

Просьба отписаться здесь о результатах .

.

есть ответ техподдержки Яндекса на этот счет:

Нет, к сожалению, ограничить индексирование страниц с параметром «amp;utm_medium» с помощью директивы Clean-param не получится. В данной ситуации рекомендуем использовать именно директивы Disallow.

получается только так

Спасибо, что поделились ответом от поддержки!

Здравствуйте! А в итоге, как правильно построить конструкцию? У меня уже есть секция агента Яндекса, как мне далее добавить clean-param, с Disallow или без? Иными словами, как будет правильно? Так:

User-agent: Yandex

Disallow: /cache/

Disallow: /cli/

Disallow: /includes/

Disallow: Clean-param: _escaped_fragment_ /

или так:

User-agent: Yandex

Disallow: /cache/

Disallow: /cli/

Disallow: /includes/

Clean-param: _escaped_fragment_ /

Добрый день, Николай! Корректен второй вариант (без Disallow).

Вопрос посложней. Яндекс говорит, что на форуме (который работает на phpBB) дублируются страницы:

_https://site.ru/forum/viewtopic.php?f=52&t=1889&p=41616

_https://site.ru/forum/viewtopic.php?f=52&p=41616

то есть, необходимо скрыть страницы с GET-параметром t. И всё бы ничего, но параллельно Яндекс ругается уже на то, что в ссылках немного иной конструкции:

_https://site.ru/forum/viewtopic.php?f=67&t=1742&start=100

_https://site.ru/forum/viewtopic.php?t=1742&start=100

необходимо убрать страницы с GET-параметром f.

Но, поскольку и там, и там префиксом будет /forum/viewtopic.php, то я не смогу закрыть страницы с GET-параметром t, который во вторых ссылках уже играет большую роль. Аналогично, закрытие страниц с GET-параметром f станет критичным для первого вида ссылок. Подскажите пожалуйста, как быть в этой ситуации? Уже всю голову сломал.

В таком случае clean param не подходит. Дубли страниц можно закрыть с помощью meta name robots или x-robots tag.

Сергей, большое спасибо за ответы! Буду пробовать.

Если у меня по всему сайту такое? Это много тысяч адресов, мне их что ВСЕ прописывать? — ?amp нужно закрыть….

Покажите пример URL. Вверху писал про ?amp;utm_medium. Для него подходит Disallow, а не Clean-param.

А если у меня много разных страниц с разной степенью вложенности и в разных разделах, например:

/blog/krany-manipulyatory—vidy-i-osobennosti?utm_source=fact

/imgs/site/Markirovka gruzov.pdf?utm_source=fact

/services/dostavka-shalandoy—dostavka-dlinnomerom?utm_source=fact

то как мне тогда это прописать?

Clean-param: utm_source /

Здравствуйте, а для вот таких url:

/katalog/elektrodvigateli/elektrodvigatel_serii_ms/?calltouch_tm=yd_c:46197815_gb…

/catalog/preobrazovateli-chastoty-dvigatelya?calltouch_tm=yd_c:46196604_gb:397017…

/catalog/elektrodvigatel_serii_ms?calltouch_tm=yd_c%253A36161963_gb%253A341632…

/catalog/motor-reduktory?calltouch_tm=yd_c%3A35897247_gb%3A3425344119_ad%3A6034597528_ph%3A13916…

/catalog/motor-reduktor_serii_k-s?calltouch_tm=yd_c:46197815_gb:3970203021_ad:…

/katalog/elektrodvigateli/elektrodvigatel_serii_ms/?

/catalog/preobrazovateli-chastoty-dvigatelya?

/catalog/elektrodvigatel_serii_ms?

/catalog/motor-reduktory?

/catalog/motor-reduktor_serii_k-s?

/catalog/elektrodvigateli?cross_analytics_tm=s:yd_c:45440195_ad:7914581552_ph:18074603532

/katalog/ustroystva-plavnogo-puska/?cross_analytics_tm=s:yd_c:45440195_ad:7914581557_ph:18074603560

/catalog/elektrodvigateli?cross_analytics_tm=s:yd_c:45440195_ad:7914581552_ph:18074603520

/catalog/preobrazovateli-chastoty-dvigatelya?cross_analytics_tm=s:yd_c:45440195_ad:7914581561_ph:18074603752

/catalog/reduktory?cross_analytics_tm=s:yd_c:45440195_ad:7914581551_ph:18074603307

Clean-Param будет вот такой ?

Disallow:

Clean-param: calltouch_tm

Disallow:

Clean-param: cross_analytics_tm

Алексей, добрый день! Корректный вариант:

Clean-param: calltouch_tm /

Clean-param: cross_analytics_tm /

Или

Clean-param: calltouch_tm&cross_analytics_tm /

Также в списке несколько URL с «?» на конце. Их, скорее всего, также необходимо закрыть от индексации, но клин парам здесь не подойдет:

— 301-редирект;

— meta name robots

— x-robots-tag

— canonical (на крайний случай).

Расскажите пожалуйста подробнее о синтаксисе x-robots-tag

И может ли быть, что после внесения этой строчки

Clean-param: question&cm_id&asdas&cid&source&%3Bcid&quickmanagerclose&vote&komment&type&sref *.html

Сайт резко упал в поиске? Я сейчас поправил: вместо *.html поставил / Но могло ли это повлиять?

Подробнее о x-robots-tag:

https://yandex.ru/support/webmaster/controlling-robot/meta-robots.html

https://developers.google.com/search/docs/advanced/robots/robots_meta_tag?hl=ru

Если в clean-param были добавлены важные параметры (изменение которых влияет на контент страниц), то вероятно из поиска были исключены важные документы (проверьте момент с индексацией).

По поводу добавления параметра amp, у Вас не этот случай https://sosnovskij.ru/clean-param/#comment-506294 ?

Спасибо помогла эта комбинация:

Clean-param: calltouch_tm /

_https://nikamsk.ru/catalog/gostinitsy_sanatorii_doma_otdykha/hotel_uborochnyy_inventar/?display=table&sort=SHOWS&order=asc

_https://nikamsk.ru/catalog/dlya_office/office_santekhnicheskoe_oborudovanie/?display=table

_https://nikamsk.ru/catalog/predpriyatiya_khlebopekarnoy_promyshlennosti/?display=block&sort=NAME&order=asc

_https://nikamsk.ru/catalog/dlya_office/office_myte_ruk/?sort=PRICE&order=asc&display=table

_https://nikamsk.ru/catalog/salony_krasoty_parikmakherskie_massazhnye_salony/salon_uborochnyy_inventar/?display=table&sort=PRICE&order=desc

Под этот список подходит:

Clean-param: display /catalog

Добрый день! Подскажите пожалуйста поподробнее, как прописать Clean-param к следующим страницам?

Примеры страниц:

_https://kostanay.kmicom.kz/%7Bparam1]

_https://ustkamen.kmicom.kz/%7Bparam1]

_https://karaganda.kmicom.kz/%7Bparam1]

_https://karaganda.kmicom.kz/%7Bparam1]?baobab_event_id=kq0d820ybi

_https://ustkamen.kmicom.kz/%7Bparam1%5D

_https://kostanay.kmicom.kz/%7Bparam1%5D

Для 4-го URL:

Clean-param: baobab_event_id /

Для остальных ссылок я бы рекомендовал 301-редирект на главную.

Добрый день!

Подскажите пожалуйста как правильно прописать Clean-param: для следующий ситуации, в

_https://globaldop.ru/product-category/autoice/autoconditioners/avtokondicionery/page/2/?add_to_wishlist=4091&action=yith-woocompare-view-table&iframe=yes

в индесацию попадает много страниц с Get параметром ?add_to_wishlist

Как мне правильно его закрыть, заранее благодарю

Добрый день, Александр!

Clean-param: add_to_wishlist /

Здравствуйте, не очень знаком с кодами, прошу помощи. Пришло от яши: «Найдены страницы-дубли с GET-параметрами»

Пример: pfccskanews.com/?url=https%3A%2F%2Fpfccskanews.ru%2F2021%2F03%2F16%2Fkhl-cska-jokerit-tekstovaja-transljacija-23-01-2020%2F&format=xml

Страницы без get-параметров

pfccskanews.com/?url=https%3A%2F%2Fpfccskanews.ru%2F2021%2F03%2F16%2Fkhl-cska-jokerit-tekstovaja-transljacija-23-01-2020%2F

Что следует прописать в robots?

Сайт был перенесён на другой домен около 7 месяцев назад.

Добрый день, Вячеслав! Интересный, конечно, у Вас формат URL без параметров

Из get-параметров в первом URL только «?url», но он же используется в URL без get-параметров, поэтому клин парам здесь не подойдет. Лучше поставить 301-редирект.

Добрый вечер, Сергей,

не подскажете как прописать с помощью Clean-param для таких ссылок:

mysite/category/goot-px-20h-220v-70vt-keramicheskiy-nagrevatel-dlya-payalnika-px-201/?clid=2374179

mysite/category/industrialnyy-rastvoritel-shellsol-d60-10-l/?clid=2356959

mysite/category/stremyanka-alyuminievaya-tri-stupenki/?clid=974

mysite/category/el-bergen-lyuks-210-sm/?clid=2251107

mysite/category/dnevnye-khodovye-ogni-v-alyuminievom-korpuse-s-bokovym-krepleniem-10-diodov/?clid=2270459

заранее благодарен

Добрый день, Сергей!

Clean-param: clid /category

Добрый вечер, Сергей, не поможете еще раз.

Внес изменения в robot.txt :

User-Agent: *

Clean-param: clid /category

Disallow: */index.php

…

Все равно Яндекс ругается на GET параметр clid :

Некоторые страницы с GET-параметрами в URL дублируют содержимое других страниц (без GET-параметров). Например, _https://example.com/tovary?from=mainpage дублирует _https://example.com/tovary. Из-за их обхода информация о важных для вас страницах может медленнее передаваться в поисковую базу, что может влиять на состояние сайта в поиске.

Посмотрите примеры. Если в поиске есть дубли из-за GET-параметров, рекомендуем использовать директиву Clean-param в robots.txt, чтобы робот игнорировал незначащие GET-параметры и объединил все сигналы со страниц-копий на основной странице. Когда робот узнает о внесенных изменениях, страницы с незначащими GET-параметрами пропадут из поиска.

Проблема актуальна

Проблема известна с 20.08.2021

Проверено: 10.09.2021

Примеры страниц, которые содержат одинаковый контент и различаются только GET-параметрами в URL:

_https://ivatec.ru/category/goot-px-20h-220v-70vt-keramicheskiy-nagrevatel-dlya-payalnika-px-201/?clid=2374179

_https:/ivatec.ru/category/goot-px-20h-220v-70vt-keramicheskiy-nagrevatel-dlya-payalnika-px-201/?

Заранее благодарен.

Добрый день, Сергей. По clid, скорее всего, прошло еще мало времени. С «?» на конце поможет 301-редирект (clean param не поможет).

Сергей, добрый день.

Подскажи, пожалуйста, как правильно сделать?

Вариант первый:

Disallow: /*?display=list

Disallow: /*?display=price

Disallow: /*?display=table

Вариант второй:

Clean-param: display /product

Яндекс прислал уведомление «Найдены страницы-дубли с GET-параметрами»

_https://сайт/product/avtomatika-vorot/avtomatika-otkatnykh-vorot/avtomatika-otkatnykh-vorot-an-motors/?display=price

_https://сайт/product/avtomatika-vorot/avtomatika-otkatnykh-vorot/avtomatika-otkatnykh-vorot-an-motors/?

На сайте карточки товаров можно выбрать в трех вариантах как отображаться им. И, соответственно, в каждом разделе сайта там, где есть карточки подставляются в конец урла, эти три значения:

— ?display=list

— ?display=price

— ?display=table

Также касаемо «?» в конце урла — ты пишешь, что нужно через 301 редирект (а что там нужно прописать в нем?)

Я поставил Clean-param: display /product

Теперь мне вот так выдает:

_http://prntscr.com/1sa7nk8

Все верно?

Спасибо.

Добрый день, Андрей!

«а что там нужно прописать в нем?»

Компетентно, к сожалению, не подскажу: гуглить или задача разработчику/системному администратору.

«Все верно?»

Если проблемы только в Яндексе, то да. Если в Google тоже есть дубли с параметрами, то такие страницы лучше закрыть мета-тегом robots.

Сергей, решил еще один комментарий написать, так как нашел еще в вебмастере ссылки

_https://сайт.рф/?a=support

_https://сайт.рф/form/?name=question&id=21&data-trigger=%7B%22class%22

_https://сайт.рф/form/?name=order_product&id=18&data-trigger=%7B%22cla

_https://сайт.рф/landings/hormannakciya/?display=price

Спасибо.

Для первых 3 URL добавить:

Clean-param: a&name /

Для 4-го URL правило Clean-param: display /product можно переделать в Clean-param: display /

По второй части вопроса (я ее убрал из комментария):

— не открывается URL;

— так как URL не открывается и он очень большой, то не понятно, что показывается во всплывающем окне. Также не понятно, «URL после учета Clean-Param» отображается всегда или только, когда есть соответствующие правила в robots.txt.

Добрый день.

С некоторых пор в нашем интернет-магазине Яндекс стал находить страницы с get параметрами. Пытаюсь исправлять, выходит плохо. Как правильно указать директиву для сл. страницы:

_https://www.vfs-shop.ru/aeraciya-i-dozirovanie/napornaya-aeraciya/aeratory-napornye-s-kompressorom/aeratory-ar/?sort_by=position&sort_order=desc&layout=products_without_options

Добрый день, Игорь!

Clean-param: sort_by /

Добрый день.

Спасибо за ответ. Маленькое уточнение. Между двоеточием и get параметром пробел или нет?

Игорь, добрый день! Пробел

Добрый день! Не могу дать толк, что корректно прописать в Robots. Яндекс в критичную ошибку выдает:

Пример страницы: _https://barchef.ru/index.php?route=product/product&path=204_208_431_510&product_id=23072

Страница без Get-параметров: _https://barchef.ru/index.php?route=product%2Fproduct&product_id=23072

Страница товара: _https://barchef.ru/posuda-i-inventar/predmety-servirovki/blyuda-podnosy-servirovochnye-nabory-dlya-sadzha-fondyu/blyuda-podnosy-metallicheskie/podnos-dlya-podachi-390-260-mm-nerzh-aps-1

Помогите, пожалуйста.

Добрый день, Светлана! Сейчас с первых 2-х URL стоит редирект на страницу товара. Возможно, такие URL Яндекс нашел во внутренних ссылках. Если так, то желательно поставить корректные прямые линки на товары. Или Вы уже произвели какие-то изменения

Вебмастер выдает ошибку так же как и выдавал(( Что мы делаем не так?

Информация с Вебмастера:

GET-параметр: path

Примеры страниц: _https://barchef.ru/index.php?path=204_430_524

Страницы без get-параметров: _https://barchef.ru/index.php?

С «некорректного» URL из примера _https://barchef.ru/index.php?path=204_430_524 идет редирект на «корректный» URL _https://barchef.ru/posuda-i-inventar/barniy-inventar/sifony-kremery-ballonchiki . То есть Яндекс где-то находит некорректные URL (в коде, во внутренних ссылках) и помечает их как дубли с GET-параметрами. Возможно, каждый раз новые, потому что, по идеи, страницы с 301-редиректом на конечные качественные страницы он не должен помечать как дубли.

Вам необходимо найти, откуда Яндекс получает некорректные URL и исправить их (убрать или поставить на корректные).

Здесь clean-param не поможет.

Здравствуйте.

Подскажите пожалуйста, в яндексе отображаются результаты поиска по сайту — _https://сайт.ру/frantsuzskie-filmy/?tag=2019

Как правильно закрыть «/?», через Disallow?

Clean-param для этого не подходит наверное, т.к. символ «?» не поддерживается?

Кроме результатов поиска знак «?» не используется в url сайта.

Добрый день! Как раз clean param здесь подходит (параметры начинаются с «?», а сам знак вопроса не указывается).

Если в индексе только в Яндексе, то подойдет (примерно равнозначно) один из вариантов:

Disallow: /?

или

Clean-param: tag /

Добрый вечер, спасибо за ответ!)

Попробую «Disallow: /?».

«Clean-param: tag /» мне не подходит, т.к нужны отдельные теги в индексе

Добрый вечер! Помогите, Яндекс ругается. Примеры страниц, которые содержат одинаковый контент и различаются только GET-параметрами в URL. Примеры страниц:

— сайт/x/r/mendelevium?noamp=mobile

— сайт/m/l/phenatinum?noamp=mobile

— сайт/e/d/природа-света?noamp=mobile

— сайт/q/m/легкие-металлы?noamp=mobile

— сайт/e/d/дисперсия-света?noamp=mobile

Как правильно написать Clean-param? Заранее спасибо.

Добрый день, Сергей! Корректный вариант в Вашем случае:

Clean-param: noamp /

Здравствуйте. Имею множественные предупреждение о дублях страниц вида:

_https://sitename.net/en/Svetland_red.html и _https://sitename.net/en/Svetland_red.html?_escaped_fragment_=

_https://sitename.net/en/Televizor_123.html и _https://sitename.net/en/Televizor_123.html?_escaped_fragment_=

Видимо от того, что движок имеет ссылки вида a href=»#» rel=»nofollow ugc» и a href=»#video» rel=»nofollow ugc»

Что мне в этом случае следует прописать? Устала искать способ избавиться. Хоть плачь.

Добрый день!

Clean-param: _escaped_fragment_ /

Подскажите пожалуйста, как исправить ситуацию?

_https://power35.ru/forum/topic/6458-kalendar-soyuza-pauerlifterov-rossii-2016/?tab=comments

_https://power35.ru/forum/topic/2006-zachetnaya-knizhka-sportsmena-wpc-rossiya/?tab=comments

Clean-param: tab /forum/topic/

Здравствуйте, помогите, пожалуйста, исключить из индексации нижеприведенные ссылки (на самом деле их больше сотни, изменяется только последняя цифра). Заранее благодарен.

/homut_2.html?i=1

/vrezka_114.html?i=2

/truba.html?i=3

Добрый день, Роман!

Clean-param: i /

Добрый день!

Подскажите, пжл, можно get параметр lang=ru закрывать директивой Clean-param?

Я так понимаю, что lang=ru определяет языковую составляющую страницы. Можно ли его закрывать, если в вебмастере вылезла по ним критичная ошибка ?

Пример одной из таких страниц:

energo1.com/catalog/elektrodvigateli_postoyannogo_toka/elektrodvigateli_postoyannogo_toka_serii_2p/elektrodvigateli_serii_2pf/14445/?lang=ru

Добрый день, Татьяна! Если на сайте нет языковых версий на других языках, то можно использовать:

Clean-param: lang /

Если закрывать, то запись будет такая:

Clean-param: lang

Привет! у меня в Вебмастере выдает критическую ошибку из-за get-параметров, которые создались после подключения турбо-страниц (сейчас выключены). Пример:

big-stirka.ru/kak-otmyt-termos-ot-zavarki-kofe-zapaha-chistka-metallicheskih-i-steklyannyh-kolb-3027?amp

big-stirka.ru/kak-otmyt-termos-ot-zavarki-kofe-zapaha-chistka-metallicheskih-i-steklyannyh-kolb-3027

Я в robots.txt вставил следующее:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Clean-param: amp

Правильно?

Привет! Amp в данном случае не параметр. Лучше поставить 301-редирект или закрыть страницы в meta name robots.

Помогло вот такое решение Disallow: *?noamp=mobile*

User-agent: Yandex

Disallow: */amp*

Disallow: *?amp*

Решение Clean-param: noamp / не помогло яндекс все равно видит дубли страниц , обратился в группу поддержки посоветовали Disallow: *?noamp=mobile*, потом всплыли /amp и ?amp соответственно Disallow: */amp* Disallow: *?amp* и все замечаний нет.

Спасибо за опыт

Спасибо за ответ, но в Вебмастере в примере дублей написано, что страницы отличаются GET-параметрами. А нельзя в robots прописать просто Disallow: */amp ? Если нет, то как настроить 301 редирект со всех страниц с amp ?

Как мне отвечали в службе поддержки Яндекса, параметром в случае с Clean Param считается URL, в котором есть вопрос «?» и знак равно «=» после него — «?=». В приведенных URL с amp есть только вопрос

Если нужно закрыть только для Яндекса (в Google нет страниц с amp), то можно и в robots.txt — добавить строку:

Disallow: /*?amp

Здравствуйте, мне нужно закрыть эти страницы

_https://azalia-club.ru/вытынанки-снеговик/amp/?_gl=1*2w5qlt*_ga*YW1wLWd5OWhaZ3JtUm1hTVVsVTJP

_https://azalia-club.ru/вытынанки-надписи/amp/?_gl=1*15qmcyw*_ga*YW1wLU1BQ3YzWnh2M0hZWWpxbEZt

Добрый день, Анастасия!

Clean-param: _gl

Здравствуйте. Не пойму, а почему во всех случаях, когда директива применяется ко всему сайту, вы в конце ставите слэш? (в отзывах заметил). Правильно ведь будет и без него? Тобишь, допустим:

Clean-param: utm_source

Добрый день! Да, все верно, можно не указывать слеш. Сейчас посмотрел инструкцию на сайте Яндекса, цитата:

«Чтобы директива применялась к параметрам на страницах по любому адресу, не указывайте адрес».

Раньше такого не помню (а помню как раз слеши). Возможно, изменили.

В вебмастере показывает дубль /?ref=xranks как правильно заполнить Clean Param, спасибо!

Clean-param: ref

Спасибо, в вебмастере идут дубли заголовков, где в URL в конце просто добавлен «?».

Решаемо через Clean-param?

Нет. 301-редирект в помощь

Добрый день. Долго играла с директивой, потом указала в роботсе через амперсант целую пачку Clean-param: epik&from&utm_source&unapproved

Вроде полегчало.

А что означает параметр ?from=webmaster

Добрый день, Татьяна! ?from=webmaster — это метка, скорее всего, добавляется к URL при переходе из Яндекс.Вебмастера.

Мои объявления — 48 таких заголовков Дата обхода

/user/nn100 25.02.2022

/user/nn100?page=2 24.02.2022

/user/kvartirymoskva/?logout=1 23.02.2022

/user/c9610f00697ce23b15f1cd44f3ecff3f

Первый и четвертый URL — нет параметров.

Второй URL — пагинация. Может быть, не нужно закрывать.

Третий URL — Clean-param: logout

Здравствуйте. Дубли в вебмастере, не подскажите как убрать?

1. site.com/site/userfiles/import/

дубль

site.com/site/userfiles/import/?C=N;O=D

2. site.com/site/userfiles/catalog/

дубль

site.com/site/userfiles/catalog/?C=N;O=D

и так на многие папки Спасибо! Вроде бы прописано Disallow: /*?

Добрый день! Можно использовать один из 3-х вариантов:

1. Добавить в robots.txt:

Clean-param: C

2. Реализовать 301-редирект с дублей на аналогичные основные страницы.

3. На страницах дублей в рамках тега head добавить meta name=»robots» content=»noindex. nofollow»

Здравствуйте,

К некоторым страницам прилипла такая концовка: ?from=webmaster

Подскажите как избавиться, об этом вообще нигде информации нет, даже сам Яндекс не пишет именно про эту концовку. Про все остальные есть информация, а как от этого избавиться непонятно. И вообще с чего вдруг эта концовка появляться начала… Спасибо.

Добрый день, Алексей! 301-редирект на основной URL или Clean-param: from

Здравствуйте. От яндекса пришло предупреждение, чтобы использовал Clean-param в случае дублей страниц, оканчивающихся ?preview=true. rel canonical прописано, не могу разобраться, как правильно запретить такие стр. в Clean-param. Пробовал в robots.txt добавить Disallow: ?preview=true, робот игнорирует.

Здравствуйте! В robots.txt необходимо добавить строку:

Clean-param: preview

Спасибо, добавил. Но в вебмастере при проверке пишут, что стр. обходится роботом.

«http://novosti-house.ru/politica/kitai-otobral-y-rossii-lyny.html?preview=true

Китай отобрал у России Луну — News-box свежие новости

Страница обходится роботом, но отсутствует в поиске.»

Это нормально?

Да.

Добрый день.

Вот такая штука у меня. На одном из сайтов стоит яндекс поиск. При этом в вэбмастере мне постоянно приходят сообщения, что у меня куча одинаковых title и description. И все эти страницы с формирующего поиска типа:

/poisk.php?searchid=2319636&text=

/poisk.php

/poisk.php?searchid=2319636&text=Бублик+где+его+взять+

/poisk.php?searchid=2319636&text=Три+бублика

/poisk.php?searchid=2319636&text=Бублики

/poisk.php?searchid=2319636&text=Конфеты

/poisk.php?searchid=2319636&text=Баранки

/poisk.php?searchid=2319636&text=чсм

/poisk.php?searchid=2319636&text=чсм

Как это все правильно сделать чтобы эти страницы не попадали как дубли.

Такие страницы лучше закрыть от индексации строкой в рамках тега head.

site.ru/?utm_sour%D1%81e=yandex_search&cm_id=54509364_4285791610_10910424521_22896099667__none_search_type1_no_mobile_premium_10872

В Тильде прописал: utm_sourсe&cm_id

А Яндекс выдает вот что:

34 Clean-param: utm_sourсe&cm_id Некорректный формат директивы Clean-param

/?cm_id=58871496_4445139128_10208378595_25811265396__yandex.ru_context_type1_no_desktop_none_2

А вот cm_id работает, когда только его прописал

В яндексе когда проверяю разрешена URL после учета Clean-Param /

Здравствуйте!

Подскажите, пожалуйста, надо ли в Вебмастере отключать обход страниц по счётчику Метрики? Некоторые сеошники рекомендуют это сделать как раз для того, чтобы в поиск не попадали страницы с utm-метками.

Добрый день, Роман! Я тоже рекомендую убирать обход.

seo-eso.ru/obrabotchik-clean-param-onlayn/ написал скрипт, который автоматически генерирует правильные clean-param для robots.txt

Здравствуйте, вот такие get параметры:

*Удалено

Правильно ли будет вот так:

User-agent: *

User-agent: Yandex

Clean-param: seraph_accel_gp

Добрый день, Дмитрий! Правильно, только строку «User-agent: *» можно удалить.