Внутренние дубли страниц сайта: последствия, поиск, удаление

Привет, друзья! Сейчас оптимизация сайта под поисковые системы это по большому счету систематический труд по его развитию, нежели применение каких-то секретных действий и технологий. Одним из таких систематических мероприятий является удаление из выдачи поисковиков дублей контента. Вот об этом действии и пойдет речь в сегодняшнем материале.

В первую очередь, нужно ответить на вопрос, почему дубли страниц негативно сказываются на его продвижении. На это есть несколько причин:

- Размывается внутренний ссылочный вес. Это происходит в том случае, когда в структуре сайта некорректные линки ссылаются на дубли страниц вместо того, чтобы увеличивать "значимость" продвигаемых документов.

- Смена релевантных страниц. Например, вы продвигаете карточку товара, текст которой полностью дублируется в категории. Поисковая система раздел может посчитать более релевантным. Итого получится, что вместо того, чтобы пользователь сразу попадал на товар, он направляется в общую категорию, где продвигаемый продукт может просто потеряться среди других. Потенциальный клиент может превратиться в уходящего посетителя.

- Уникальный контент, который представлен только в одном месте, ценнее того, который дублируется во множестве веб-документов.

В основном дубли появляются из-за особенностей систем управления контентом (CMS), либо из-за действий вебмастера, который копирует тексты или создает практически идентичные документы. Они бывают полными или частичными (здесь я не беру в расчет момент, когда тексты копируются на другие сайты). Полные - это когда контент полностью идентичен под другим URL, частичные - когда частично.

На мой взгляд, если один и тот же кусок контента частично дублируется в нескольких документах на сайте в пределах 10-15%, то ничего страшного. Если же больше 50%, то с этим уже нужно что-то делать.

Содержание:

Соотношение "реальных" страниц с количеством проиндексированных

Иногда встречаю фразы типа:

Яндекс плохо индексирует блог. В индексе всего лишь 50 страниц. А вот Google хорошо. У него 1250 страниц.

На первый взгляд какая-то проблема с индексацией в отечественном поисковике, но после уточняющего вопроса о количестве опубликованных постов, все становится на свои места. Оказывается у автора в блоге всего лишь 30 записей. Это говорит о том, что с Яндексом все в порядке, а вот в Гугле большое количество дублей. В связи с этим нужно сначала соотнести количество "реальных" страниц на сайте, которые могут быть полезны пользователю и (или) поисковику, а также не запрещены к индексации, с количеством проиндексированных. Как это сделать?

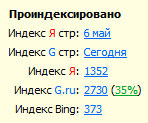

И снова пример на основе блога. Сейчас количество проиндексированных документов выглядит следующим образом.

Google занес в индекс в 2 раза больше страниц. Кто прав? Начинаю считать примерное количество нормальных страниц на сайте.

- 1011 постов;

- 20 категорий;

- главная;

- 8 пунктов меню;

- 120 страниц пагинации (навигация внизу на главной и в категориях)

Еще штук 30 различных файлов, которые я загружал (здесь же, например, флэш баннеры). Итого получаем, что нормальных страниц в блоге около 1200. Яндекс ближе всего оказался к истине. Эти дополнительные 150 документов я так и не смог найти (в этом поисковике можно просматривать только 1000 результатов выдачи).

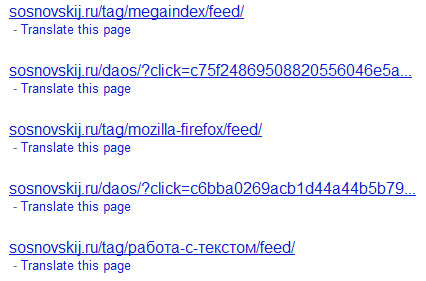

Google, несмотря на то, что показывает цифру в 2730, в SERP выдает только 700-800. Зато в опущенных результатах находятся подобные вещи.

Даоса уже давно на блоге нет, а документы с feed на конце запрещены в robots.txt. Предполагаю, что добрая половина от цифры 2730 это и есть фиды и ссылки daos.

Как искать дубли страниц?

От последствий и причин перехожу к методам поиска дублей на сайте.

1) Полный анализ проиндексированных документов. Способ сводится к тому, чтобы просмотреть все страницы, которые включены в индекс. Для этого нужно ввести запрос site:vash-domen.ru и просмотреть все результаты (для Яндекса не более 1000, у Google - непонятно).

Чаще всего нужно анализировать URL'ы и искать среди них нетипичные. Например, у вас стоит ЧПУ, а в выдаче встретился URL с каким-нибудь таким окончанием me&catid2012220&offsetsort=price. Скорее всего, подобный документ нужно запретить к индексации.

2) Проверка внутренних ссылок, создающих дублированные страницы. Мне встречались CMS, которые создавали дубли документов внутренними ссылками, то есть ссылались не на основной материал, а на дубликат. Например, представьте, если в WordPress в анонсе поста заголовок ссылался на страницу записи (http://myblog.ru/moya-zapis/), а ссылка "Читать далее" на какую-нибудь страницу типа http://myblog.ru/moya-zapis/content/. Подобные вещи нужно либо удалять, либо превращать в адекватные (можно в принципе и продублировать линк, если он стоит на картинке или добавить якорь #).

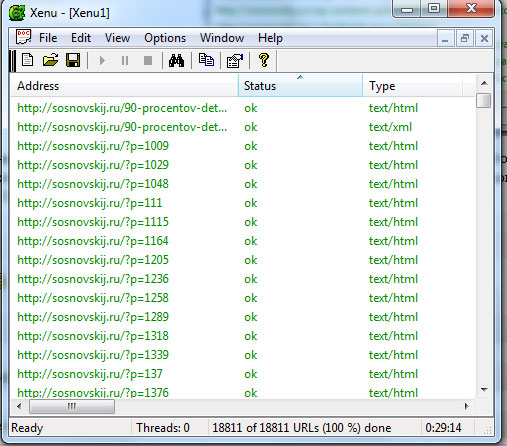

Подобные ссылки можно смотреть самому или воспользоваться специальным софтом. Программа Xenu умеет обходить все линки на сайте, ища битые (нерабочие). Она на английском, но пользоваться ею несложно.

Сначала нужно скачать Xenu (кнопка Download) и установить ее на компьютер. Далее запустить, нажать File -> Check URL. Затем введите в первое поле адрес своего ресурса http://vashdomen.ru/ и нажмите "ОК". Программа начнет ходить по ссылкам и фиксировать рабочие, нерабочие, внутренние, внешние, заголовки, description и так далее.

Xenu выдаст результаты в зависимости от объема ресурса. Мой блог программа анализировала 29 минут .

После завершения утилита предложит создать карту для сайта и сразу залить ее по ftp. Это можно не делать. Нужно сохранить результаты. File -> Export to TAB separated file. Это позволит сохранить все данные в текстовый файлик. Далее его содержимое можно скопировать в Excel, чтобы легче было производить анализ. Можно также отсортировать URL'ы по алфавиту.

Я например, увидел, что в rel='shortlink' есть урлы вида ?p=43242, но они все имеют 301-редирект на соответствующие материалы с ЧПУ.

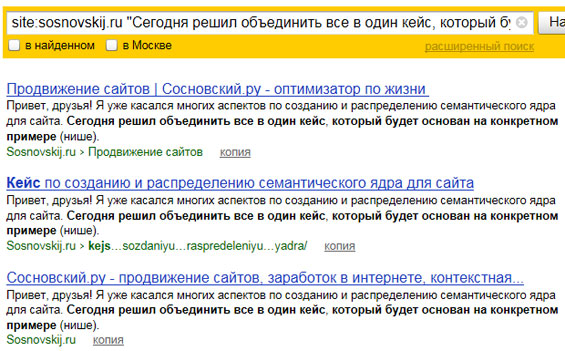

3) Поиск по кусочкам текста. Одна из самых стандартных процедур. Она заключается в том, что берется кусок текста из структурной единицы (например, предложение с 7-12 словами) и ищется в кавычках в Яндексе или Google в поиске по сайту.

Запрос имеет следующий вид site:vashdomen.ru "кусок-текста". Я вставил одно предложение из кейса по созданию и распределению семантического ядра. Яндекс нашел 3 документа, которые его содержат. Это собственно сама запись и 2 ее анонса: на главной и в категории. Дублирующие анонсы небольшие, поэтому бояться нечего. Если взять, например, какое-нибудь нижнее предложение из того же материала, то найдется только страница самого поста, так как искомый кусок текста в анонсы не попадает .

Что я подразумеваю под структурной единицей? Все просто - это главная, категории, меню, карточка товара (пост, статьи и так далее). Желательно подобным образом проверить не менее 10 документов из каждой структурной единицы.

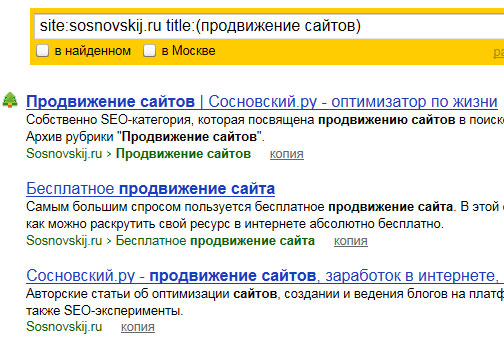

4) Использование языков запросов. Аналогично 3-му пункту. Только поиск производится в заголовках (тег title) и в URL документах ресурса. Как правило, у дублирующих друг друга страниц эти элементы очень схожи. Примеры поиска:

а) Для Яндекса - site:vashdomen.ru title:(продвижение сайтов)

Этот запрос будет искать вхождение "продвижение сайтов" в теге title. Альтернатива для Google - site:vashdomen.ru intitle:продвижение сайтов.

б) Для Яндекса и Гугла - site:sosnovskij.ru inurl:prodvizhenie

Этот запрос будет искать прямое вхождение "prodvizhenie" в URL документов.

Как убирать дубли?

Есть несколько способов удаления дублей сайта из поисковой выдачи. Для некоторых случаев может подойти какой-то один, для других - комплекс из всех пунктов.

1) Meta name="robots". Самый эффективный метод для документов, для которых не подходят пункты 2-4. Подробнее можно прочитать в этом эксперименте.

2) Ручное удаление. Если вручную была создана дублирующая статья (запись, карточка) или html-страничка, то ее также нужно вручную удалить.

3) 301-редирект. Стандартная процедура для склеивания полностью идентичных документов (например, доступность с www и без www).

4) Атрибут rel="canonical". Этот атрибут сейчас понимает и Google, и Яндекс. Он призван давать поисковому роботу информацию о предпочитаемой странице среди множества схожих по содержанию документов. Например, в интернет-магазине в категории чемоданов есть несколько сортировок: по цене, дате добавления, популярности и так далее. Поисковая система может проиндексировать данные сортировки. Так вот, чтобы среди подобных документов алгоритм ПС выбрал главную страницу категории в качестве канонической (грубо говоря, самой релевантной), нужно указать rel="canonical" для всех подобных, которые копируют ее.

Например, есть URL'ы:

- http://internet-magazin-chemodanov.ru/chernye-chemodany

- http://internet-magazin-chemodanov.ru/chernye-chemodany&sort=price

- http://internet-magazin-chemodanov.ru/chernye-chemodany&sort=date

- http://internet-magazin-chemodanov.ru/chernye-chemodany&sort=popular

На 3-х последних урлах в пределах тега head нужно вставить следующий код:

В таком случае поисковики предпочтут первую страницу в качестве самой релевантной. В современных движках (например, WordPress) данный атрибут уже включен в структуру создания документов.

5) robots.txt. Этот файл запретит поисковому роботу индексировать определенное содержание ресурса. В первую очередь, нужно поискать стандартный robots.txt для вашей системы управления сайтом ("robots.txt для ..." - вместо троеточия название вашей CMS). Как правило, он уже должен оградить ресурс от индексирования основных документов, которые дублируют содержание.

Для частных ситуаций нужно уметь пользоваться директивой disallow и спецсимволами "*" и "$" (не стоит забывать и про host). Подробно об этом можно почитать в помощи Яндекса. Если брать ситуацию с чемоданами, то robots.txt мог выглядеть так:

User-agent: *

Disallow: /*sort=

Только тут нужно быть уверенным, что кусок "sort=" не используется при построении URL'ов у нормальных страниц с полезным содержанием. Иначе и они будут запрещены к индексации.

Возникали ли у вас проблемы с поиском дублей и их удалением? Как справились с задачей? Поделитесь своим опытом. С нетерпением жду ваши комментарии .

Megaindex — сервис автоматического продвижения + партнерская программа и 300 рублей на счет.

Megaindex — сервис автоматического продвижения + партнерская программа и 300 рублей на счет.  Схемы взаимодействия с заказчиком на продвижение сайта

Схемы взаимодействия с заказчиком на продвижение сайта  Кейс по созданию и распределению семантического ядра для сайта

Кейс по созданию и распределению семантического ядра для сайта

Всё это, безусловно, очень хорошо, но придется очень много работать руками. На мой взгляд, проще всего запретить дубли с помощью файла robots.txt, я так и сделал.

Спасибо за статью)

Я сейчас продвигаю один туристический сайт, сделанный на самописной cms, дак там столько дублей наплодилось из-за движка) замучился все искать! тем более доступа к сайту не имею, в коде не покапаться особо, с айтишниками через тз только общаюсь)) Ну ничего, вроде получилось избавиться от дублей

Станислав, роботсом не всегда можно убрать все дубли. Искать их в любом случае вручную надо :).

Спасибо! Тоже борюсь с дублями.

Sosnovskij, Сергей, я имел ввиду, роботсом можно закрыть однотипные страницы, которые создает тема. Например, у меня появлялись дубли страниц вида site.ru/page?print=yes, и этот «?print=yes» создавался для каждой страницы. Я просто закрыл его в роботсе и все

Неоднократно замечаю, что robots.txt для Гугла не работает, как и атрибут meta name=»robots» content=»noindex». Пихает все в индекс и непонятно как с этим бороться.

Надо ли закрывать от индексации номера страниц в постраничной навигации wordpress?

Интересный софт — надо попробовать. А то уже вторую подобную статью читаю — надо что-то предпринимать.

Я роботс составил «как надо» и теперь из яндекса дубли сами собой выпадают — маленько ещё осталось. С гуглом не знаю что там.

Доброго дня. Что с Google делать совершенно непонятно.

В Яше сейчас — 960 страниц

В Google — 12500 страниц

Полный пандус!

Как бороться с Google? Непонятно.

Я уже устал удалять всякий мусор из индекса Google. Он что, вообще не дружит с командами robots.txt? Что делать то, уже ума не приложу(

Надо будет проверить

Очень полезная статья. Но у мне все же не до конца ясно. Нужно ли закрывать метки? Сейчас я их закрываю, так как это мне кажется один из факторов попадания под АГС. Ведь если их не закрывать, то можно получить больше страниц в индексе. А как делаете Вы?

aleks, есть такая особенность у гугла.

Дмитрий, я не закрываю, так как поисковому роботу без нее будет сложнее добраться до старых записей.

Сергей, все позакрывали?

Евгений, если немного страниц, то можно в Google Webmaster заказать удаление вручную. «Оптимизация -> Удалить URL-адреса».

Сергей, я закрываю. Точнее вообще их не вывожу.

Да, роботс сделал максимально насыщенным)

Могу скопировать его сюда, если не загромоздит ветку.

Сергей, а разобрались, что не то в индексе Гугла?

Sosnovskij, нет, к сожалению. Страниц в Яндексе 1000, а в Google 19000. Такое ощущение, что на роботс.тхт Google не смотрит вообще.

Сергей, из 6-ти пунктов, которые в посте, ничего помогло найти дубли?

Sosnovskij, а ты делал какие-либо наблюдения за эффектом от устранения дублей на позиции и трафик? Сам борюсь с дублями, но одновременно всегда идут и другие работы над сайтом, поэтому сложно понять от чего произошел эффект.

а для меня пока все это сложно и не очень понятно я только учусь

Как ни странно, но гугл и яндекс иногда игнорируют команды прописанные в robots. Конечно предпочитаю все закрывать изначально, но гугл все равно индексирует больше положенного.

Андрей, подобного эксперимента не ставил.

Полезная статья, надо будет и свой блог проверить…

Кстати, у тебя не так давно этих дублей дофига было на некоторое время — что это было!?

Денис, не замечал такого. Если и было, то значит глюк поисковика.

Кто-нибудь пробовал указывать директивы отдельно для каждого паука? Я на новом сайте попробовал — у меня почти одинаковое количество страниц в индексе я и г. На старых сайтах прописал такие же директивы но дубли из индекса гугла не вываливаются, есть идеи?

Вот пример файла роботс (сайт на джумла), но у меня сработало но только с новым сайтом, то есть дублей изначально не было в индексе

User-agent: Yandex

Disallow: стандартные категории закрытые джумлой

Disallow: /*.php*

Disallow: /*.swf*

Disallow: /*mod_jxtc_videoshow*

Host: site.com.ua

Sitemap: site.com.ua/sitemap.xml

User-agent: Googlebot

Disallow: стандартные категории закрытые джумлой

Disallow: /*.php*

Disallow: /*.swf*

Disallow: /*mod_jxtc_videoshow*

Забыл сказать что на сайте используется ЧПУ, по этому все страницы ПХП закрыты.

ИМХО смысл раскрыт от А, до Я, автор выжал всё что можно, за что ему респект!

А меня из-за случайных типа дублей Гугл пендальнул по одному запросу с 3 на 11.

Теперь вперед два шага в неделю делаю

э, я не совсем понял. Например, у меня есть одна статья, в которой затрагивается материал описанный в другой статье, разумеется, я не буду его дублировать и ставлю на него гиперссылку в этой статье. Надо ли закрывать подобные ссылки от индексации поисковиками, или можно оставить открытыми?

И еще вопрос, нормально ли то, что при том, что у меня на блоге сейчас 81 запись, а в индекс яндекса находится 95?

Владимир, «Надо ли закрывать подобные ссылки от индексации поисковиками, или можно оставить открытыми?» — не надо.

«И еще вопрос, нормально ли то, что при том, что у меня на блоге сейчас 81 запись, а в индекс яндекса находится 95?» — нормально.

Sosnovskij, не понял, не надо что, закрывать от индексации, или оставлять открытыми?

Владимир, внутренние ссылки, если вы их ставите, не надо закрывать от индексации.

Sosnovskij, все, понял, большое спасибо за ответ, мне было важно знать этот момент.

Станислав,

не знаю, кто как делает, но случайно посмотрев сайт androidobzor.com обалдел (не преувеличиваю). Никаких ЧПУ, а 100% в основном индексе!

Дополнение к посту (забыл): И robots.txt практически, как у всех.

Сергей, Евгений,

Тоже самое. Гугл плюёт на robots.txt

Приветствую, коллега!

У меня с индексом Гугла примерно такая же ситуация. Дело в том, что у меня сайт статей и есть очень большой по объему каталог, где все эти статьи так или иначе попадаются в различных сочетаниях. В основном это отбор статей по ключевым словам. Эти списки немного более разнообразные, чем просто изменение сортировки.

Хотелось бы выкинуть эти страницы из индекса. И сделать это довольно просто! Для Яндекса можно запихнуть их в robots.txt. Для Гугла этого мало! Он, как маньяк, коллекционирует всякое Г… на сайте и никак не может с этим расстаться. У меня он даже выцепляет урлы из сложных ява-скриптовых запросов.

Похоже, гуглу надо ставить в страницах мета тег robots. Но ситуация осложняется тем, что на страницах каталога у меня стоит адсенс. И мне очень хотелось бы убрать страницы из индекса, но оставить доступ для Mediapartners-Coogle. А вот как это сделать — я не знаю и это главный вопрос, о котором я хотел с Вами, коллега, посоветоваться.

Есть идея поставить 2 мета тега первый для googlebot … «noindex, follow»

и за ним сразу второй для mediapartners-google … «index, follow»

Я, возможно, так и попоробую сделать, но опыты с Гуглом занимают кучу времени, да и вообще могут плохо кончиться…

У Вас нет ли на эту тему инфо какой-нибудь?

Такой вот вопрос… очень интересует… Стоит ли закрывать страницы категорий и пагинации, дабы не было дублей коротких анонсов или достаточно будет использовать канонические ссылки на полную статью?

Вроде бы все понятно, но этот robots.txt, смотрю не всегда все схватывает. Вот сейчас появились в Яндексе куча не найденных ссылок, я так понимаю наплодились коментами удаленными, типа того:

/comment-subscriptions?srp=131&sra=s

/comment-subscriptions?srp=137&sra=s

/comment-subscriptions?srp=140&sra=s

Подскажите. как их закрыть с помощью robots.txt?

Если дубли, как на картинке, то они мешать не будут…. А если серьезно, то дублей не будет при правильной разработке движка сайта. И если знать что и куда, правда часто с этим у многих проблема…

Дмитрий, с подобной ситуацией не сталкивался. Попробуйте ваш вариант :).

Alex, канонические урлы не подойдут для страниц категорий и пагинации. Я их не закрываю.

Алексей, Disallow: /comment-subscriptions*

Сергей, добрый день.

Я воспользовался вашей статьей и загрузил гугл вебмастер, он показал,что дублей нет, проблема- 2 страницы с короткими метаописаниями(4 слова).

Однако мегаиндекс, услугами которого я начал пользоваться внезапно показал, что в тайтлах, кейвордах и дискрипшн имеются дубликаты.

Дело в том,что на сайте есть разделы, например, угги короткие и высокие и др.

Каждый из разделов имеет подразделения по цветам.

И каждая модель имеется у себя на странице и на главной странице.

1-Это может считаться дублем? Почему же мегаиндекс считает его дублем ,а гуг-нет? Из-за яндекса?

2-если взять одну и ту же модель (на главное стр. и у себя в подразделе),и написать немного различающиеся слова в тайтлах, дискрипшн и кейвордах, это будет считаться или надо будет и описание товаров менять?

Заранее спасибо,

Руслан

barracuda, мегаиндекс и гугл используют разные данные для анализа. У мегаиндекса своя база проиндексированных страниц, у гугла — другая.

1 — если title, description, keywords и контент на странице одинаков, то да.

2 — 1 модель представлена на 2-х страницах? Если да, то лучше одну страницу удалить и везде ставить ссылку на оставшуюся. Если модели немного различны (например, цвет), то указывайте это различие в title, description

Сергей, ситуация такова- скажем черные короткие угги находятся в 2-х категориях:

1-короткие угги.

2-главная страница(витрина).

Поскольку на главную страницу я загружаю товары с других подразделов(например, «короткие угги»), то он полностью копирует оригинал.

Если немного изменить тайтлы, скажем в одном написать угги короткие черные,а в другом- черные короткие угги, ПС примут изменение или опять будет считаться дублем? И на описании каждого товара-если убрать несколько предложений(например, про подошву, материал и др.) на одном, а на другом, это дубль или надо полностью менять текст, на 100 % уникальность?

2-да я так и делаю-различие, я имею в виду, несколько дней в мегиндексе стояли отметки- «ОТЛИЧНО», и вдруг все стало «хорошо». а у конкурентов стоит «отлично».

Я просто боюсь делать что то резкое с сайтом-то есть дубли-это плохо, но если я вдруг сотру дубли с главной страницы (представляете, 26 страниц!), или из внутренних страниц(тоже 26, но с разных мест), а на них стал щас еще закупать ссылки, как воспримут гугл и яндекс?

barracuda, в общем, главная проблема это то, что 1 и тот же товар находится на разных страницах. 1 товар = 1 страница. Если такое будет, то дублей не будет. Тогда ничего псевдоуникализировать не придется

Вы знаете, а мне кажется, что все страниыы с товарами нужно выкинуть нафиг из индекса. Так же как и каталог товаров (его в первую очередь). И гугл и Яндекс вслед за ним уже год талдычат, что на товар посетители должны переходить по ссылкам из нормальных длинных и содержательных информационных материалов.

Типа получили информацию, заинтересовались продукцией — и перешли.

А так, все ваши угги поисковики считают генерированным контентом и это не добавляет трастовости стайту, а наоборот убавляет.

Лично мне пришлось убрать из поисковика все страницы с содержанием и другими, очень милыми моему сердцу вещами. Но я получил плюс порядка 20% посетителей в день.

Три месяца, как маньяк удалял 1900 страниц мусора, через панель вебмастера Гугла. Потом, установил плагин «геl canonical». Только это дало действенный результат.

Дмитрий, если описание товаров и категорий составить самим, а не скопировать откуда-нибудь, то поисковые системы не будут считать страницы с генерированным контентом.

Я согласен. И есть положительные примеры!

Но по требованию Гугла (ничего от себя я не добавляю) Это описание должно быть длинным и информативным. Об уникальности — вообще молчу.

Слаб`о по статье на каждую угги написать? А они только цветом отличаются!!!

В случае с обувью я бы взял бы модельный ряд. Например Угги «Трам-пам-пам» и написал бы об этом модельном ряде хороший текст, который понравится и Гуглу и читателям. А в статье разместил бы ссылки на раздел каталога с этими уггами. А самого каталога в индексе нет. Строго ноиндекс.

А вот еще лучшее решение. Предположим я делаю статью про угги. Она индексируется. А каталог с этими уггами прямо внутри статьи и сделан на аяксе! Вот это я считаю вообще оптимальным решением. В смысле удобства пользователя и остуствия мусора в индексе.

Вообще, скажу я вам, борьба с мусором в Гугле меня конкретно просто достала. Гугл реальный маньяк. Он собирает мусор по всему инету и бережно его хранит, индексирует и фильтрует. Я всерьез думаю сделать все свои оглавления (а у меня каталог авторских статей) на аяксе.

Вадим, а как установить и использовать этот плагин? про каноникал где то читал,по моему на форуме сеопульта.

Этот плагин для джумлы. Искал и брал информацию на форуме джумлы. Никаких проблем в установке нет. Настроек тоже минимум.

А как же htaccess — наиболее четкий способ, чтобы определенный тип страниц выдавал желаемый код 410, например:

RewriteCond %{QUERY_STRING} expression

RewriteRule ^.*$ — [G]

где вместо expression — то, что нужно зафильтровать.

reklamarabotaet, получается, что страница вообще не будет доступна?

спасибо за статью. пошел искать дубли

Добрый день, Сергей. У меня возник следующий вопрос:

Гугл выдает мне определенное кол-во проиндексированных страниц. Среди этих страниц есть достаточно схожие

1. site.com.ua/tag/reklama/

2. site.com.ua/reklama/

Для меня имеет значение 2-я. Нужно ли мне удалить первую страницу?

Возможно я задал глупый вопрос, но прошу простить меня.

p.s. Превосходный блог. Спасибо.

Станслав, если они идентичны, то закройте 1-ю от индексации, удалите или поставьте 301 редирект на вторую.

Я понял. Благодарю, Сергей.

Sosnovskij, ну так это же и цель.

Страница будет отдавать код 410 — Gone, страница раньше существовала, а сейчас админ ее удалил. И больше ее тут не будет.

Я таким способом фильтровал пустые страницы с одной картинкой. Дублирующие уже имеющиеся картинки внутри других страниц. Баг CMS, одним словом.

reklamarabotaet, а как быть со страницей, которая нужна пользователю, но не нужна поисковой системе? htaccess запретит просмотр обоим.

Вот такая ситуация

Сайт на ВордПресс

В роботсе: Disallow: */feed

В хедере нет ниодного вхождения feed

А в индексе Гугла куча страниц с */feed

Владимир, google бывает непредсказуем и индексирует даже то, что ему запрещено

А что насчет страниц тегов которые создает DLE? Их лучше тоже поубирать с выдачи? У меня видео сайт и на странице видео есть список тегов, с ссылками на эти самые страницы тегов. Вот такие: тег … Это для удобства сделано, как по мне повышает ПФ. Запретить в роботсе индексацию этих страниц? Если запретить то я так понимаю вес туда больше перетикать не будет?

Влад, если на теги не идет поисковый трафик, то их смело можно закрывать от индексации.

А такие страницы вообще считаются дублями? Сайту всего 5 дней, он ещё не успел проиндексироватся толком…

Влад, они не считаются полными дублями

спасибо за ответ, тогда не буду закрывать от индексации

Сергей, нашел у себя в опущенных результатах (гугл) документы с feed, хотя в robots.txt они запрещены — собственно то что вы описывали в статье. Стоит ли их удалять, если да то как?

Максим, они у меня тоже есть. Если они запрещены в вашем robots.txt, то делать ничего не надо. Если нет, то надо закрыть

Disallow: /wp-feed

Disallow: */feed

Сайт на cms OpenCart, которые также славится созданием многочисленных дублей. Однако прежде чем наполнять сайт, сразу включил ЧПУ и в роботс.тхт запретил множество форм, которые генерирует движок.

Беда, однако, в другом. Через некоторое время пришлось полностью изменить структуру сайта, и теперь в Google вижу такую картину:

/chasy/avia-109401.html

/man/avia-109401.html

Ну, и так почти для каждой модели часов Яндекс, кстати, потихоньку вроде затирает старую структуру (она в поисковой выдаче почти не мелькает), да и на роботс внимание обращает.

Яндекс, кстати, потихоньку вроде затирает старую структуру (она в поисковой выдаче почти не мелькает), да и на роботс внимание обращает.

А как с гуглом быть?

Александр, поможет 301-редирект.

Т.е. нужно будет руками в файле «.htaccess» настраивать редирект для каждой страницы? А если их более 200?

Александр, либо вручную, либо обратитесь к специалисту по OpenCart, либо к программисту. Возможно, они смогут придумать формулу по замене страниц в .htaccess.

А из-за дублей страниц, может АГС быть?

Андрей, нужно понимать, что АГС — это комплексный фильтр. Если, например, у википедии, появится множество дублей, то вряд ли ее Яндекс отправить под этот фильтр.

Неделю назад, наоборот, вернул индексацию тегов для Гугла, количество переходов выросло почти в 2 раза. И точка входа именно теги.

smarttv, а как Вы вернули индексацию тэгов?

У меня уже голова болит. Не рад, что завел сайт (((

У меня такая ситуация: Анонс новости (один абзац) попадает в 2-3 (иногда 4) категории. Это дубль инфы. Но иначе ведь не могу. куда имеено вставлять этот ваш каноникал? В анонс и с указанием полной статьи, или только в полную статью? Заранее спасибо! Сосновский, ты молодца (читал твои статьи в сео энциклопедии)

Sorus_Nomad, лучше публиковать материал в 1 категорию. Но если так получается, то rel=»canonical» тут не поможешь. Ничего не нужно делать.

P.S. Спасибо за отзыв :).

А как находить дубли и одинаковые урл? Чтобы не ручками а автоматом?

Vladimir, в посте есть полуавтоматические решения. Полной автоматизации здесь вряд ли добиться.

спасибо за статью! Как обычно, никогда не стоит забывать о дублях и борьбе с ними.

На самом деле очень практичные советы даны в статье.

Спасибо за статью, Сергей. Между прочим Yandex Parser уже парсит и в Гугл линки.

Лучший способ, по моему, избавиться от дублей — 301 редирект.

У меня дубли в основном из-за древовидных комментариев. Сейчас они все в «соплях». Сажите, стоит ли их удалять вообще? Их оочень много!!!

Кристина, лучше их удалить из индекса.

Сергей, вопрос возник, который не совсем подвязан к дублям страниц, но имеет отношение к глаголу «удалять»

Один строительный сайт ранее продвигался силами одной студии, затем произошел скандал и заказчик продвигает сайт у нас (совершенно новый ресурс, с новым доменом — старой остался по договору у старой студии).

И этот ресурс постоянно мешает в продвижении, так как Яндекс считает его более трастовым.

Вопрос: как можно повлиять на ранжировании того сайта? Удалить его? Полюбовно не получилось

Александр Webpp, если старый сайт привязан к компании, то попробовать написать в поддержку поисковых систем, объяснив ситуацию. Якобы второй ресурс той же компании, но не находится во владении. Не обязательно, но возможно что-то изменится (хотя владельцы старого сайта могут просто изменить названия).

Внешне как-то повлиять на вылет из индекса- очень сложно.

Здравствуйте. Ситуация следующая. Есть сайт site.ru. Гугл его проиндексировал, однако в выдаче выдаёт его дубли примерного вида: v007916.600.ru/, где v007916 — логин для входа в админку, а 600.ru — сайт, предоставивший хостинг и админку.

Что делать?

Спасибо

Мария, писать хостеру, чтобы закрывал от индексации подобные поддомены.

Здравствуйте!

Подскажите пожалуйста, как сделать редирект со страниц вида site.ru/?hsajd на 404 ошибку или хотя бы запретить их к индексированию?

Станислав, нужно обратиться к программисту вашего движка.

Не факт, что это поможет. Подобного рода страницы открываются на любых сайтах. Проверял несколько наугад, в том числе Яндекс и Ваш. Открывается главная, но адрес иной. Со знаком вопроса и прочими символами.

Программистам движка этим вопросом мозг выносят уже с 2011 года

Станислав, он сможет настроить, чтобы подобные страницы, например, отдавали 404 ошибку. А вообще эта особенность на многих сайтах. Я не видел примеров, когда она отрицательно сказывалась на проекте.

Станислав, «Программистам движка этим вопросом мозг выносят уже с 2011 года» — разве они не могут это сделать или не понимают зачем?

Sosnovskij, они считают, что это не критично. Говорят: «вот когда вы выпадете из ТОПов и сможете доказать, что именно это стало причиной возникновения дублей, тогда будем решать вопрос».

Я на своем молодом проекте в Bing нашел уже пару страниц, к примеру .ru и .ru/?p=102 и всё в индексе. Топ бинга меня не сильно парит, но как бы еще куда это не проникло. Где-то он эту страницу нашел ведь

У меня радость, я их победила!!! Осталось ручками удалить пару сотен страниц. Пришлось отключить древовидные комментарии навсегда. Теперь встает вопрос, как сделать их обратно, чтобы дубли не полезли? С помощью какого плагина или кода?? Помогите, пожалуйста!

Кристина, какого рода дубли создавались из-за древовидных комментариев?

Sosnovskij, создавались Replytocom, я полностью от них отказалась, поставила скрипт и запретила в вебмастере гугл. Они потихоньку вылетели сами, осталось чуть-чуть удалить.

Хочется вернуть кнопку ответить без последствий.

Кристина, у меня стоит кнопка ответить и не создает дубли

Что-то я поискала и не нашла на блоге статью о комментировании. У вас плагин какой-то стоит или руками сделано?

У моей знакомой блоггерши плагин стоит, так та же ерунда, дубли плодит. Не хочется второй раз мучиться с ними.

Кристина, руками

Спасибо!Не знал про программку Xenu.Действительно ли она создаст толковую карту сайту?Попробую

Дмитрий, попробуйте и узнаете

Вызрел опрос для ТС. Скажите, доктор, как правильно светить страницы раздела? Уточняю: есть раздел сайта, например, «Новости» и в нем статьи (берем идеальные контентные условия: 100% уникальность и т.п.) в к-ве 100000 шт по 10 на страницу, карты сайта — нет (будем считать так, так как в карте сайта все равно URL-ов с пагинацией не будет). Как правильно оформить данный раздел, чтобы его страницы, указанные в GET как, например, /news?p=34, не посчитали дублями одного и того же раздела?

Спасибо

Webaliser, не совсем понятен вопрос. Можно с примерами?

Сергей, не поняла до конца, а как вы решили проблему с наличием в гугле страниц с окончанием feed? У меня такая же проблема, хотя в robots.txt запрещена индексация фидов.

Анастасия Владыкина, покажите выдачу гугла с данными страницами .

.

Вот, пожалуйста, screen.fst.su/НастяShot2013-09-02221502.png

Sosnovskij, уточню, а то действительно дебрями пошел. Есть сайт, на сайте есть раздел «новости», в нем 1000000 новостей. Выводятся новости в разделе по 10 штук на страницу. Выглядят урлы страниц раздела новости так:

/news

/news?p=2

/news?p=3

/news?p=4

… и т.д.

Как обеспечить нормальную индексацию статей раздела, не используя карту сайта, при этом, чтобы не плодились дубли типа /news и /news?p=2 (у меня как раз так и получилось). В этом случае нужно использовать canonical?

Анастасия Владыкина, за такие страницы не стоит волноваться. Как видно из описания страниц в поисковой выдаче, google понимает, что они закрыты в robots.txt, но почему-то все равно показывает их в серпе. Это его особенность :).

Webaliser, все равно не совсем понятно :).

«чтобы не плодились дубли типа /news и /news?p=2»

То есть страницы раздела вы считаете дублями самих новостей?

Как же так объяснить, не давая ссылки …

…

Вот страницы:

https://sosnovskij.ru/

https://sosnovskij.ru/page/2/

https://sosnovskij.ru/page/3/

https://sosnovskij.ru/page/4/

https://sosnovskij.ru/page/5/

Это адреса одного раздела «Новости» (предположим, что это не блог, а сайт с таким разделом), показывающие новости внутри с 1 по 10, с 11 по 20 и т.д. Это ссылки одного и того же раздела сайта, только меняются сами новости в списке выдачи, как у блога. Весь около списочный текст с ссылками одинаков. Поисковик же считает, что эти все (ссылки выше) страницы — разные, а не одни и те же, и считает их дублями, так как меняется в них только средний контент.

Если и сейчас не понятно, можно я как-то тебе на почту напишу этот вопрос, только напиши мне письмо пустое и я отвечу… Спасибо. Я в продвижении дуб-дерево, а создать в сайте могу все!

Webaliser, почему вы решили, что поисковик считает их дублями? Основной контент этих страниц как раз меняется

Здравствуйте. Подскажите пож. Есть интернет-магазин. Есть каталог с одеждой. В каталоге много позиций, поэтому разбито всё на страницы (page1? page2…). Перед самими позициями одежды — идёт тематическая статья. И эта статья естественно высвечивается и на 1 странице позиций, и на второй и т.д. В результате, в Гугл появляются дубли — текст один, а страницы разные. Как то можно это исправить? Если запретить в роботсе индексацию всех страниц со словами «page» — наверное тоже не хорошо, тогда нарушится индексация самих позиций на этой странице.

Мария, необходимо запретить отображение тематической статьи на остальных страницах. Делается это на уровне CMS.

Sosnovskij, Засада в том, что около списочный текст тоже не мал, поэтому и считает, вокруг списка есть всякие выборки последнего из разных разделов. Думаю, это был как раз случай Марии. Спасибо. Вы помогли

Очень полезная статья!! С помощью вышеперечисленных рекомендаций получилось выявить большое количество дублей!

А вот что делать с такими дублями? — Каждая категория имеет постраничную навигацию и возможность отображать по 5,10,25,50 товаров, в итоге получается:

…/p/1/5.html

…/p/1/10.html

…/p/1/25.html

…/p/1/50.html

…/p/2/5.html

…/p/2/10.html

…/p/2/25.html

…/p/2/50.html

и так далее, в зависимости от количества товаров…

Что посоветуете сделать в этом случае — прописать для них каноническую страницу?

Богдан, да, rel=»canonical» будет в данном случае хорошим вариантом

Sosnovskij, А я вот еще думаю — может лучше убрать возможность изменять количество товаров на странице (5,10,25,50), сделать, к примеру, по умолчанию 25. А для страниц использовать link rel=”prev” href=”” и link rel=”next” href=”” ? Или его только Гугл поймет?

Богдан, в этот момент

» link rel=”prev” href=”” и link rel=”next”»

не в курсе.

Можно убрать возможность изменять количество показываемых товаров на странице, но если поисковые системы знают о них (документах с разным количеством товаров), то есть вероятность, что они их будут держать все равно в индексе. Поэтому канонические URL все равно нужно ставить

Спасибо за помощь!!!

Sosnovskij, Хотел бы у вас уточнить одну вещь. На корпоративном сайте, созданная запись — товар. Имеет непосредственно на странице несколько разных картинок. Так вот вот так

А яндекс вот так.

Андрей, а в чем вопрос?

Я борюсь с древовидными комментариями, ужас сколько они дублей создают.

Запретил в Инструментах для вебмастеров => Параметры URL , добавил replytocom и закрыл эти страницы от индексирования.

Естественно убрал галочку в админке с древовидных комментариев, а ведь так удобно, казалось бы было…

Спасибо за статью очень даже полезную.

Сейчас глянул в яндекс 86 страниц в поиске, а загружено роботом 234.

В google раза в три больше страниц. Спасибо сейчас буду разбираться что к чему.

Здравствуйте. Я новичок в сео. Подскажите, как быть с пагинацией страниц сайта объявлений. Назначать каноникал?

Юлия, для страниц пагинации можно прописать meta robots = noindex, follow. Роботы поисковых систем будут ходить по ссылкам, но не будут индексировать контент.

Владимир,

Тоже самое полно страниц в Гугле с feed, хотя в роботс они запрещены.

Стоит ли об этом волноваться?

Добрый день!

Сейчас борюсь с дублями и

возник вопрос

как правильно устанавливать параметр в гугл вебмастере (сканирование — Параметры URL) — я читала, что так можно убрать дубли с гугл.

Допустим, нашла на сайте следующие дубли

site.ru/usr/home/wwwsiteru/www/blog/kak-ustanovit-pgu/

— для этих дублей устанавливаем параметр с учетом регистра в гугл

usr

site.ru/home/users1/o/oooavto/domains/site.ru/news/maz-500/

а для этих дублей

home

site.ru/catalog/maz-543202/2/?letter=%D0%BA

параметр

? – знак вопроса

также мне пока что совсем не понятно, какой подобрать параметр

вот для такой страницы

site.ru/catalog/maz-533605/ – основная

site.ru/catalog/maz-533605/5/ – дубль

Если несложно, скажите, верны ли мои рассуждения.

спасибо за ответ )))

Алексей, можно сделать редирект страниц с feed на аналогичные страницы без feed.

Вера, дубли лучше убирать посредством работы внутри сайта (редиректы, указание в robots.txt, в META NAME=»ROBOTS»). В таком случае внутри google webmaster ничего не придется делать

Отличная статья.Спасибо большое.Иду удалять дубли.