Какие ссылки покупать в 2020 году или выпуск «Вопрос-ответ» №39

Сегодня разберу вопросы по Турбо.Страницам Яндекса, особенностям наложения фильтров в Google, E-A-T-факторам, ранжированию нецелевых страниц и т.п. 10 вопросов и 10 моих ответов. Обязательно найдете что-то интересное =).

Содержание:

- 1. Стоит ли добавлять страницы пагинации форумных тем в sitemap?

- 2. Зависят ли поисковые подсказки от региона

- 3. Могут ли Турбо.Страницы навредить сайту?

- 4. Стоит ли доверять скриншотам из Google Search Console

- 5. Постоянные ошибки на Турбо.Страницах. Что делать?

- 6. В основной выдаче Яндекса отображаются нецелевые страницы

- 7. Есть ли в Google хостовые/кластерные фильтры за текстовый переспам?

- 8. Какие ссылки покупать в 2020 году?

- 9. Как прокачать E-A-T факторы в Google?

- 10. Случайно изменил теги Title на всем сайте. Что делать?

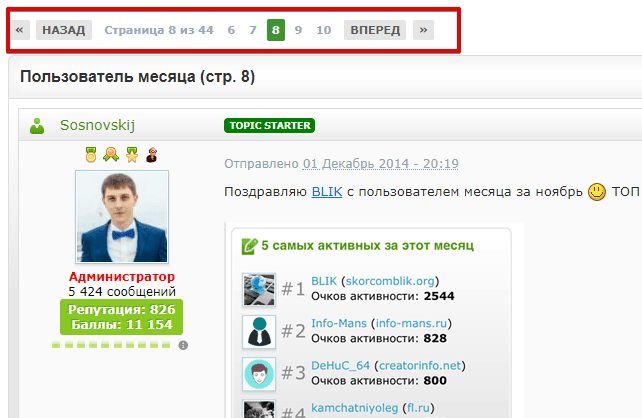

1. Стоит ли добавлять страницы пагинации форумных тем в sitemap?

На форуме есть страница темы, например, "https://forum.ru/topic123/page-2", должна ли она быть в сайтмапе? Я считаю, что должна.

Однако, возьмём огромный топик, например, на 1000 страниц. Очевидно, что контент на каждой из них меняться никогда не будет. В лучшем случае будет иногда обновляться первый пост и добавляться новые сообщения. А старые страницы всегда будут иметь контент с той датой, которая была при создании.

Если на форуме много многостраничных тем, то потенциально это огромное число документов в sitemap. Например, у меня на форуме 140 тысяч тем, а вместе с пагинацией 230 тысяч. Не несёт ли это негативный эффект?

Страница пагинации в форумной теме, по сути, является полноценным отдельным документом. Я считаю, что их также необходимо добавлять в sitemap.

Популярная проблема больших сайтов — "Что держать в карте: все URL или какую-то определенную часть?". Существует несколько вариантов:

- Все URL (включая пагинацию тем) постоянно держать в sitemap. В данном случае появляется проблема с краулинговым бюджетом. Вероятно, поисковый робот будет тратить его на URL, которые уже находятся в индексе (отчасти может помочь настройка http-заголовков if-modified-since и last-modified).

- Добавлять пагинацию тем в sitemap, но спустя определенный промежуток времени (например, 365 дней), удалять. За 1 год документ должен проиндексироваться

.

- Держать в карте только непроиндексированные документы. Сначала проверяем каждый URL из полной карты на индекс в Яндекс/Google. Страницы, которые есть в обеих поисковых системах удаляем из sitemap. Проделываем такое 1 раз в день/неделю/месяц/квартал (в зависимости от масштабов проекта, скорости создания нового контента и т.п.). Так как метод довольно затратный по ресурсам, то проиндексированные документы после первой проверки в последующие можно уже не включать (но не забудьте добавлять в карту новый созданный контент).

Одна из основных задач карты сайты — добавление в индекс новых страниц. Если поисковый робот проиндексировал URL, то будущем к нему он уже может обратиться без помощи sitemap.

2. Зависят ли поисковые подсказки от региона

Привет! Сейчас первый раз создаю семантическое ядро (недавно запустил небольшой интернет-магазин). Планирую к данным Wordstat добавить и поисковые подсказки. Только вот возник вопрос, а зависят ли поисковые подсказки от региона: В Яндексе и Google?

Да, подсказки зависят от региона и в Яндексе, и в Google. Учитывайте это при сборке семантики.

3. Могут ли Турбо.Страницы навредить сайту?

Сергей, добрый вечер! Мы создали Турбо.Страницы (пока только для Яндекса). Хочу узнать, у них те же URL, что и у основных или собственные? Не пропадут ли из поиска основные документы, если будут отображаться турбо в поиске?

Не навредят ли Турбо.Страницы основным, если они в выдаче будут показываться, поскольку на основные идут ссылки и статьи?

Спасибо!

Турбо-страницы создаются только для Яндекса (в Google имеется аналог — AMP). URL у них собственные, но они не индексируются в привычном понимании (не создают дублей). В Яндексе основные страницы заменяются на турбо-версии. При отключении турбо в выдаче снова будут основные. Именно они и участвуют в ранжировании. Наличии у документа турбо — один из факторов. Когда в выдаче будет бОльшая часть турбо, то этот фактор сильно уменьшится.

По конверсиям и поведенческим метрикам необходимо наблюдать, какие из версий будут эффективнее (турбо или обычные). В коммерческих тематиках конверсии на турбо хуже, чем на обычных, в информационных — может быть наоборот.

В долгосрочной перспективе мобильные пользователи будут ставить не прямые ссылки, а ссылки на турбо-версии. В социальных сетях уже встречаются линки именно на турбо (по сути, ссылаются на Яндекс). То есть часть ссылочной массы будет уходить на "зеркало Рунета".

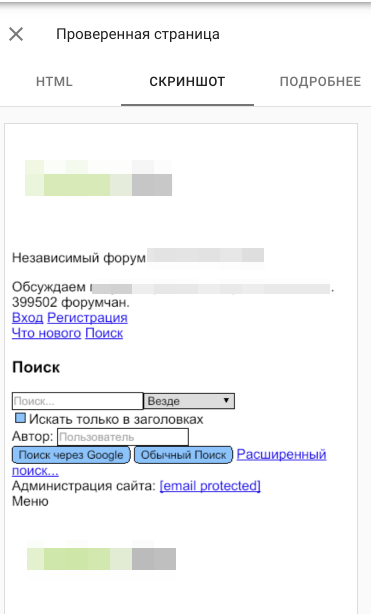

4. Стоит ли доверять скриншотам из Google Search Console

Насколько можно верить скриншотам страниц гугла, которые он показывает в консоли? В моём случае, у некоторых страниц они нормальные, также как я вижу с мобильного телефона. А у некоторых (которые строятся по тем же шаблонам и никак не отличаются технически) показывается так, как будто рухнули CSS.

Какой процент "забагованных" документов я не знаю, но если предположить, что google так видит и это носит массовый эффект, то это большая проблема. Может он так видит и считает, что контент плохой?

Нашёл сервис, который позволяет взглянуть как робот гугла и он показывает также забаговано. Я смотрел в информации от гугла, что он там не смог прогрузить. И никакой разницы: На нормальных и забагованных страницах списки одинаковые, всякие скрипты. Но отключение скриптов не привело к багам.

Что необходимо сделать?

- Посмотреть, как отображаются забагованные документы в кеше Google. Если там нормально и дата кеша свежая, то, скорее всего, проблемы нет.

- Если кеш тоже "без стилей", то необходимо часть забагованных страниц отправить на переобход через Google Search Console.

- Принудительно (через Allow) в robots.txt разрешить сканирование изображений (.png, .PNG, .jpg, .JPG, .jpeg, .JPEG, .gif, .GIF и т.п.), CSS стилей (.css, .CSS), скриптов.

- Проверить user-agent'ы на форуме. Правильные ли версии отдаются разным роботам.

- Спросить у разработчика почему в Google Search Console могут появляться подобные скриншоты (он лучше знает CMS).

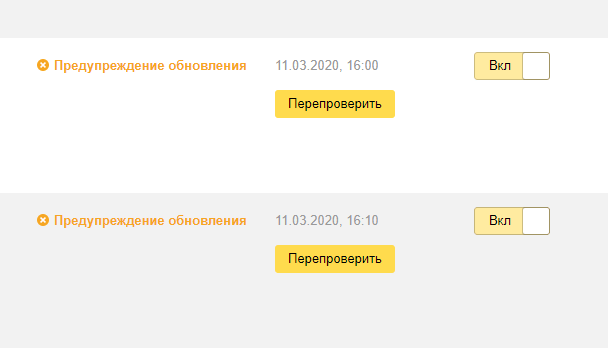

5. Постоянные ошибки на Турбо.Страницах. Что делать?

Яндекс.Вебмастер постоянно шлет уведомления, что с моими турбо-версиями что-то не так. Я исправил ошибки, нажал перепроверить, но в Вебмастере по-прежнему отображаются ошибки. Можете что-нибудь посоветовать в моем случае?

- Обновить плагин, который создает турбо.страницы. Возможно, что-то изменилось в спецификации и фид от старой версии плагина не соответствует новым требованиям.

- Исправить ошибки, если они в контенте постов.

- Удалить старые фиды из Яндекс.Вебмастера.

- Добавить новые фиды.

Часто проблема в том, что нажатие на "Перепроверить" не снимает ошибок. А удаление старых источников и добавление новых — снимает проблемы.

6. В основной выдаче Яндекса отображаются нецелевые страницы

Здравствуйте, Сергей! У меня есть проблема на сайте, которая выражается в поиске Яндекса нецелевых страниц. То есть вместо коммерческих страниц по многим ключам он показывает информационные статьи. Буду вам признателен, если вы дадите своё мнение.

С Уважением.

Сначала необходимо проанализировать что выдается в ТОП 10 (оценить коммерциализацию). Бывает так, что вебмастер хочет видеть по запросу свою коммерческую страницу, а весь ТОП занят информационными статьями. Если так, то поисковик думает по-другому и по данному ключу необходимо продвигать именно информационный материал. Вероятно, в будущем поисковая система поменяет свое мнение.

Если в выдаче по большей части коммерческие документы, то нужно заменить целевую страницу (подробности по ссылке).

7. Есть ли в Google хостовые/кластерные фильтры за текстовый переспам?

Привет. Как думаешь, есть ли в Google хостовые или кластерные фильтры за текстовый переспам? К примеру, если мы на 20% страницах переспамим, могут ли упасть позиции остальных 80%? И аналогичный вопрос, если переспамим на 80% урлов, могут ли просесть остальные 20%?

Полагаю, что могут быть. Например, если переспам на одной странице, то фильтр документный. Если затрагивается большая или бОльшая часть кластера (например, 80% информационного раздела магазина), то под фильтр загоняется весь кластер (раздел).

Аналогично фильтр становится хостовым, когда большая или бОльшая часть целого сайта переспамлена.

Возможно, на документы, которые попадают под раздачу, накладывается не классическая санкция (удаление из выдачи, минус 50-100 позиций и т.п.), а какой-то понижающий коэффициент (грубо говоря, снижение, но не обнуление рейтинга).

8. Какие ссылки покупать в 2020 году?

Привет! Весь 2019 год по совету знакомого я покупал вечные ссылки через gogetlinks и miralinks. Отбирал неспамные и не слишком дорогие. Часть доноров по тематике, остальные с общей тематикой (например, новостные порталы).

Барабанная дробь... На поисковом трафике это никак не отразилось. А потрачено не один десяток тысяч рублей. Хочу поменять ссылочную стратегию. Посоветуй, пожалуйста, где лучше покупать ссылки в 2020 году?

Самая главная проблема в том, что все идут в популярные биржи и покупают там "неспамные и не слишком дорогие ссылки". В итоге у многих сайтов пересекается ссылочный кластер, который в принципе может не учитываться поисковыми системами (поисковый трафик не вырос).

В последние годы (2020 не исключение) эффективна та ссылочная масса, которую тяжело повторить:

- OutReach, включая социальные сети, youtube;

- гостевые посты;

- неспамный крауд-маркетинг на неспамных площадках;

- ссылки с сайтов производителей;

- Википедия.

Я бы назвал это даже не покупкой, а приобретением (добычей) ссылочной массы Для разбавления профиля можно использовать онлайн-справочники компаний, сайты по поиску работы.

Акцент делать на постоянном росте линков, качестве площадок, уникальности и полезности материала, в котором опубликована ссылка, ее кликабельности (реферальный трафик).

9. Как прокачать E-A-T факторы в Google?

Привет, Сергей. Хотел спросить, не посоветуешь ли что-нибудь по проблеме E-A-T от гугла. Позиции ухудшились, но из проблем я вижу только то, что у меня не хватает "авторитетности" информации.

Одно из решений это под статьями указывать имя автора, которое должно вести на отдельную его страничку. На ней подробная информация о нем.

Вот меня эта подробная информация и напрягает. Можно ли, например, хотя бы фамилию не указывать? Не нужна мне огромная популярность. Есть какие мысли? Спасибо.

Для того, чтобы хорошо поднять E-A-T факторы недостаточно просто указать автора и добавить страничку о нем (даже с фамилией). Сам по себе автор должен быть "прокаченным":

- информация и документы, подтверждающие компетентность в тематике (биография, история, дипломы, сертификаты и т.п.);

- ссылки на аккаунты в социальных сетях, адекватная активность там;

- ссылки на публикации в крупных изданиях.

То есть сама по себе фамилия, грубо говоря, большой роли не сыграет. Если компетенций и их доказательств не хватает, то можно на эксклюзивных правах найти и нанять стороннего эксперта.

10. Случайно изменил теги Title на всем сайте. Что делать?

Прошу помощи. У меня проблема с настройками All in One SEO Pack. Фрилансер, работающий на моем сайте, отключал плагин и забыл его заново включить. Все теги Title стали неоптимизированными (в H1 я стараюсь прописывать цепляющий заголовок больше для людей). Заметили не сразу, все страницы уже успели переиндексироваться.

Что делать? Быстро обратно поменять или уже будет только хуже? Подскажите, пожалуйста.

Неприятный момент. Теги Title лучше резко так не менять. Я бы вернул все теги в первоначальный вид и по возможности отправил страницы на переиндексацию. Но некоторые изменения в поисковом трафике все же могут быть. Есть некоторая вероятность, что он несколько просядет и не вернется обратно на свои места.

На сегодня все. Задавайте свои вопросы, делитесь мнениями и отзывами в комментариях ![]() .

.

(10 голос., в среднем: 4,20 из 5)

(10 голос., в среднем: 4,20 из 5) Как зарабатывать 1000 рублей в сутки или ответы на вопросы – часть №5

Как зарабатывать 1000 рублей в сутки или ответы на вопросы – часть №5  Сколько ссылок нужно для попадания в ТОП 10 или ответы на вопросы №7

Сколько ссылок нужно для попадания в ТОП 10 или ответы на вопросы №7  Какие приобретать ссылки в современных реалиях?

Какие приобретать ссылки в современных реалиях?

Искал ответы на некоторые из вопросов тоже, спасибо. В целом все сложнее становится продвигаться

Немного непонятно, точнее совсем непонятно, про ссылки с сайтов производителей — как их добывать? Первый раз слышу. Это видимо что-то из продвижения на западе?

Актуально для коммерческих сайтов. Ссылки с производителей, чей ассортимент реализуется на продвигаемом сайте.

Ну вот наконец и привык к новому дизайну

У меня Турбо в большинстве случаев никак не отражался на трафике, а вот поведенческие становились хуже. Но это только на мобилке тестил. С десктопом, наверняка, все еще хуже.

Да, нужно тестировать. Не всегда Турбо в плюс.

Привет Сергей!

По sitemap для форумных страниц пагинации могу предложить своё видение =)

Я бы держал в sitemap страницы пагинации до тех пор, пока они НЕ последние в топике (естественно с соответствующими if-modified-since и last-modified)

Задача sitemap не ограничивается «зайти в индекс», иметь в индексе документ в актуальном(!!!) виде — это тоже важно.

То есть из sitemap страницу можно удалять только после того как её содержимое уже не будет меняться. Делать привязку к какому-нибудь временному периоду — не очень верно , на мой взгляд =)

Привет, Миш! Хорошая версия, но моя строилась из момента, что когда поисковик знает об URL, то он уже на него может ходить и без помощи каких-то других помощников (карты сайтов, ссылок и т.п.)

Сереж, нууууу… Меня учили что sitemap нужен не для того чтоб поисковик проиндексировал, а для того чтоб он узнавал об изменениях на сайте =)

И когда сайт (форум) ОЧЕНЬ большой, то наличие sitemap с указанием актуальности информации улучшает переобход не только конкретной страницы, но и сайта в целом, нэ? =)

А зачем ему обращаться к sitemap, когда у него в базе уже есть URL? Например, в первый раз через сайтмап он нашел новую страницу. В следующий раз ему проще напрямую к ней обратиться.

Например, в первый раз через сайтмап он нашел новую страницу. В следующий раз ему проще напрямую к ней обратиться.

Всегда узнаю из ваших статей что-то новое. Сегодня узнал про ещё один минус турбо страниц. А раньше ведь даже не задумывался о том, что вес передается Яндексу, а не сайту. Еще очень понятно ответили про экспертность, отметив, что главное пруфы, а не то, что написано об авторе. То есть, если я пишу биографии, то мне бы не помешало пройти курсы журналистики, а скрин диплома указать на странице автора. Эффект точно будет, если я всё правильно понял.

Эффект в данном случае немного расплывчатое понятие, которое может растянуться на некоторое время. То есть, как вариант будет сложно оценить влияние именно он улучшения экспертности.

Нормальный такой фрилансер, работал и забыл включить плагин. А деньги за работу он не забыл взять?

Разные ситуации бывают. Человеческий фактор

Ссылки хоть и не так уже актуальны, как раньше, но наращивать их всё равно необходимо.

В целом Вы скорее рекомендуете турбостраницы для некоммерческого сайта или нет?

В целом я рекомендую протестировать Смотреть не только динамику по трафику, но и по заработку. В итоге сделать вывод — выгодны турбо или нет.

Смотреть не только динамику по трафику, но и по заработку. В итоге сделать вывод — выгодны турбо или нет.

Спасибо за полезную статью, ссылки важны для продвижение блога. Я не часто покупаю ссылки, а если покупаю то только из авторитетных сайтов.

Опа на скриншоте засветился спасибо за ответы, особенно момент про ссылки

спасибо за ответы, особенно момент про ссылки