Как я удалил 55% сайта и что из этого вышло

Провел небольшой эксперимент. Сайт на 1000+ страниц. Я удалил 600+ страниц (около 55% от его объема). Ниже расскажу, зачем я это сделал, как сделал и к чему это привело.

Содержание:

С чего началось или немного про Zombie-страницы

Наверняка, вы уже слышали про Zombie Pages или Зомби-Страницы. Этот термин пришел к нам недавно из западного SEO. В него я вкладываю не только мусорные страницы, которые не должны быть в индексе (по типу архивов, календаря и т. п.), но и документы, которые лежат "мертвым грузом" (русскоязычная интерпретация понятия термина ). То есть находятся в индексе, но их никто не посещает (либо посещают, но очень редко).

Еще с былых времен sape в вебмастерской среде была простая формула: больше страниц = больше дохода. Потом в обиход вошло понятие "масштаб проекта" — чем больше документов по тематике запроса, тем релевантнее должен быть сайт. Логика в этом, безусловно, была.

Правила игры постоянно меняются. Интернет разрастается быстрыми темпами и поисковым системам нужно огромное количество серверов, чтобы держать все это в индексе. Стратегия однозапросных страниц (1 страниц = 1 запрос) канула в Лету. Теперь лучше 1 качественный материал, чем 10 посредственных.

Западные коллеги проверяли гипотезу, удаляя из индекса зомби-страницы. В большинстве случаях это приводило к росту органической посещаемости из Google. Я решил проверить, как дела обстоят в Рунете. Кому не интересны детали, можете пролистать вниз до результатов эксперимента.

Как найти "зомби" на сайте?

Здесь я не буду рассказывать, как искать дублированный контент (если интересно, можете почитать пост в блоге по дублям) или классические мусорные страницы (служебные файлы, архивы и т.д.). Суть моего эксперимента именно в удалении зомби-страниц. Найти их не совсем сложно (на примере Яндекс.Метрики и Microsoft Excel).

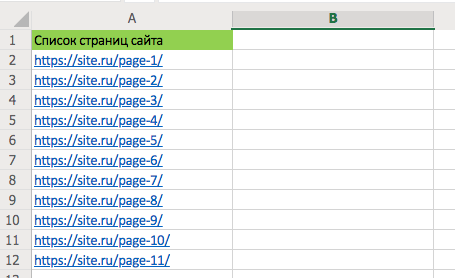

Шаг 1. Определяем список страниц сайта.

Предположу, что у каждого проекта есть sitemap.xml с полным перечнем полезных страниц (те, которые должны быть в индексе).

1. Заходим на https://site.ru/sitemap.xml.

2. Выделяем и копируем URL's.

В зависимости от формата вывода копироваться будут лишние элементы. Нам нужны только урлы без дополнительной информации. Удаление "мусора" будет зависеть от конкретной ситуации. На скриншоте пример вывода sitemap.xml с помощью плагина All in One SEO Pack. Для того чтобы удалить ненужную информацию, я копирую выделенное, затем вставляю его в обычный текстовый документ, далее выделяю все содержимое и вставляю уже в Excel. Так очиститься форматирование (можно также очистить формат непосредственно в Excel).

3. Создаем файл Excel, вставляем в него полученные данные из 2-го пункта, удаляем ненужные столбцы — оставляем только урлы.

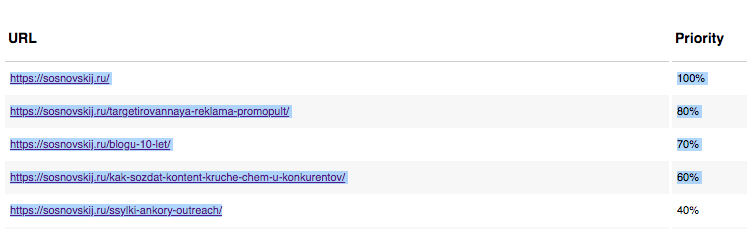

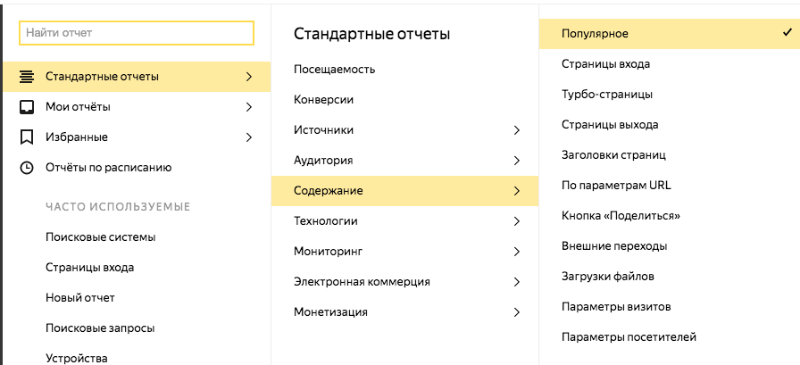

Шаг 2. Определяем список страниц сайта, отсортированных по просмотрам/посетителям.

1. Заходим в Отчеты -> Стандартные отчеты -> Содержание -> Популярное.

2. Выбираем нужный период.

Для несезонного сайта я рекомендую выбирать последние 2 месяца.

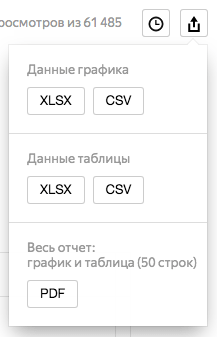

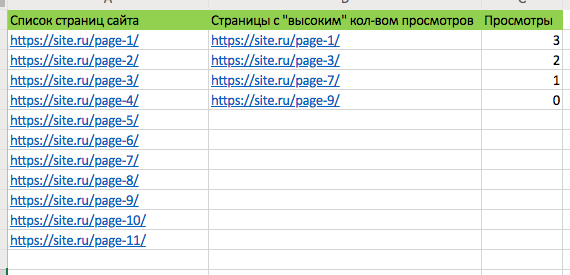

3. Скачиваем список URL's с количеством просмотров/посещений ("Данные таблицы").

4. Открываем скачанный файл, прокручиваем вправо до конца. Там будут столбцы со списком URL и количеством просмотров/посещений. Вот они как раз и нужны.

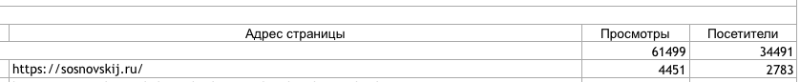

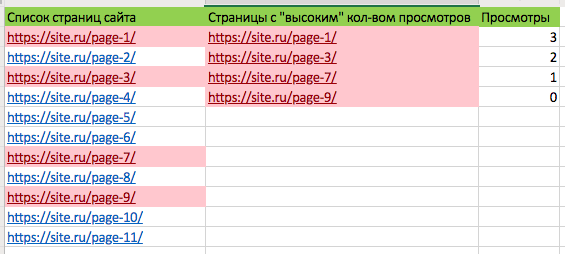

Выделяем и копируем УРЛы, которые больше определенной цифры. Я ставлю ориентир 3-4 просмотра за 2 последних месяца. Можно делать поправку на тематику.

5. Добавляем полученный список в наш Excel-файл.

Шаг 3. Определяем zombie-страницы.

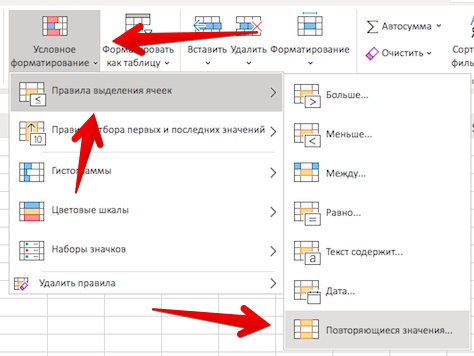

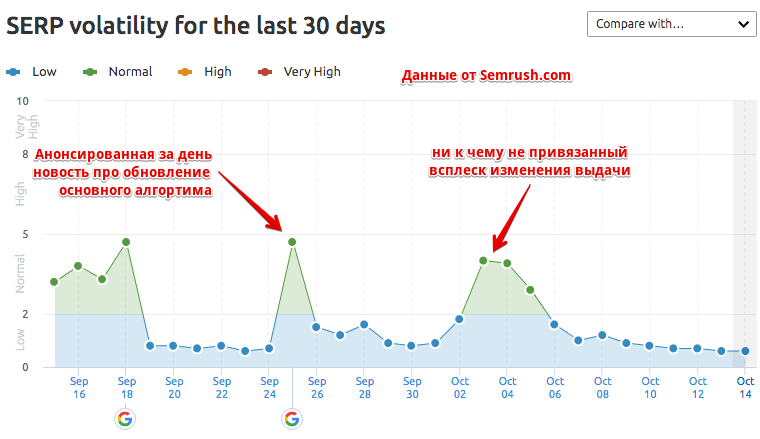

1. Выделяем урлы в 2-х столбцах. Далее "Условное форматирование" -> "Правила выделения ячеек" -> "Повторяющиеся значения". Потом "Ок".

Получаем URL's, которые есть и в первом и во втором столбцах.

2. Сортируем первый столбец по цвету и удаляем все URL с красным фоном.

3. Ура ! Конечный список страниц и будет считаться зомби (документы с посещаемостью от 3-4 просмотров и ниже). Их-то и можно удалять — в любом случае прямая посещаемость от их удаления серьезно не пострадает.

Как правильно удалять?

Удалять нужно тоже с умом. Я буду рассматривать вариант для WordPress. Полагаю, что в других CMS будет примерно также. Какие есть варианты:

- Просто удаление. Страницы будут отдавать 404-ошибку. Не лучший способ, когда больше половины сайта будет под 404.

- 301-редирект. Уже лучше, но не идеально. URL, с которых будет стоять редирект в любом случае будут фигурировать на сайте, например, в плагине похожих статей.

- <meta name="robots" content="noindex, nofollow"/>. Аналогично 2-му пункту.

Я сделал комбо из 2-х вариантах. Сначала удалил (точнее добавил в черновик) и поставил 301-редирект на главную страницу. 301-редирект в .htaccess, самый простой:

Redirect 301 /page-1/ https://site.ru/

Придется каждый URL добавлять вручную. Есть способы немного ускорить процесс, но они уже за рамками этого поста. Скорее всего, зомби-страниц будет много, и вы не сможете их удалить за короткий период. Поэтому советую удалять и настраивать редиректы блоками, чтобы поисковые системы не успели зайти на удаленные документы с 404-ошибками.

В идеале после удаления страниц, удалить и внутренние ссылки на них (при наличии). Если проект небольшой, то это не займет много времени. Если большой, то не трудно или недорого создать/заказать скрипт или плагин, который удалит внутренние ссылки на URL определенного списка.

Ход и результаты эксперимента

Что имеем:

- Сайт на 1000+ страниц.

- Более-менее стабильная поисковая посещаемость на протяжении последних 6-7 месяцев без резких взлетов и падений.

- До и во время эксперимента дополнительно с проектом ничего не проводилось.

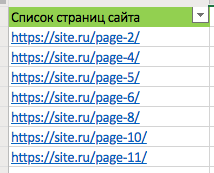

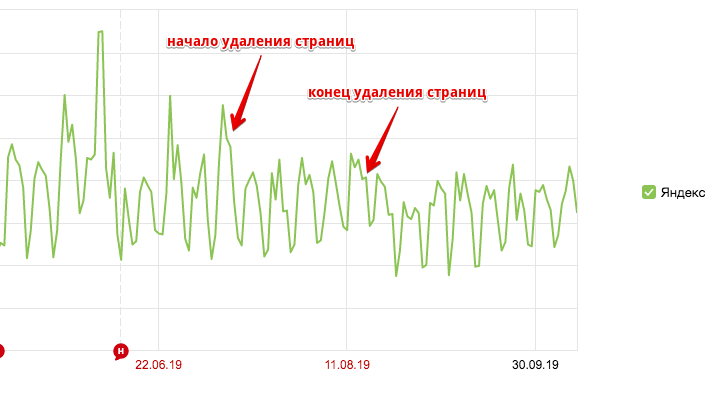

С 10 июля по 16 августа примерно через равные промежутки времени (11 отрезков) и равное количество страниц за раз было удалено около 55% контента сайта (+ добавлен 301-редирект). Посещаемость с Google:

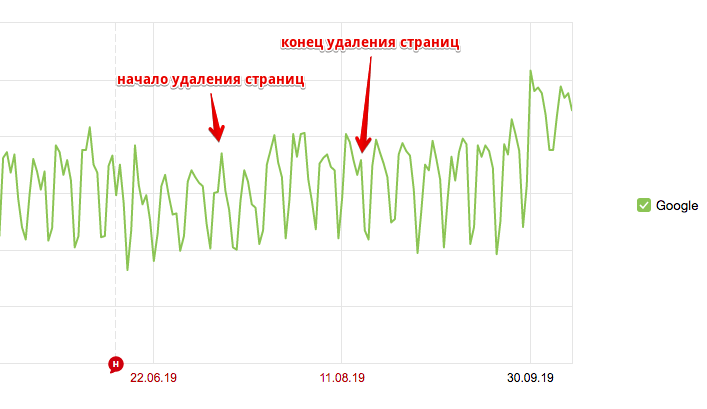

В начале октября трафик с гугла поднялся примерно на 50%. Можно было предположить, что это именно результат от удаления зомби-страниц. Сделали ресурс более качественным — получили больше трафика. Но 24 сентября было анонсировано обновление основного алгоритма — Google September 2019 Core Update. Первая "шапка" была получена сразу после него (25 числа). Пик — 30 сентября (возможно, отголоски апдейта). Вот данные по силе обновлений выдачи:

Для себя буду считать, что новый алгоритм положительно воспринял изменения на сайте и улучшил ранжирование .

А что с Яндексом?

Яндексу, скорее, такой эксперимент не понравился. Примерно через 10 дней после окончательного удаления зомби-документов посещаемость с него упала примерно на те же 50%. Сейчас она практически восстановилась.

Буду считать, что эксперимент удался — общая поисковая посещаемость подросла. Но необходимо делать поправки на:

- Один сайт — не показатель. Проведение эксперимента занимает довольно большое количество времени. Реализовать его на 1000, 100 или хотя бы на 10 проектах будет не просто.

- Резкий рост посещаемости с Google не совпал, но был рядом с September 2019 Core Update. Возможно, это влияние обновления алгоритма, а не удаления зомби-страниц.

А вы проводили похожие эксперименты? Если да, то что получилось в итоге? Ваши мысли и отзывы с нетерпением жду в комментариях !

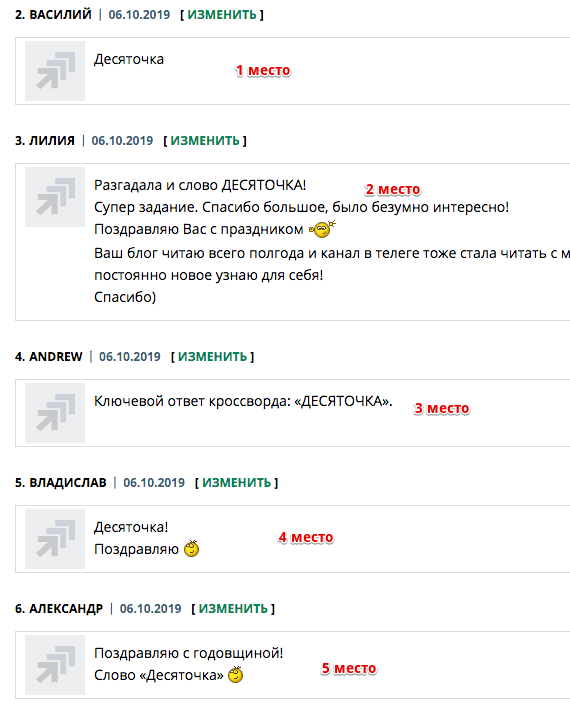

Результаты конкурса на 10-летие блога

Большое спасибо за поздравления с днем рождения блога! Очень приятно, что среди читателей есть "старички" и те, кто подключился недавно. Спасибо тем, кто принял участие в разгадывании кроссворда. Правильный ответ - "десяточка" .

Поздравляю пятерку призеров:

- Василий;

- Лилия;

- Andrew;

- Владислав;

- Александр.

А вот те, кто стал призером в конкурсе комментаторов:

- Руслан;

- Людмила;

- Александр;

- Zorbasmedia.

Жду ваши WMZ на почту с тех же e-mail, которые были указаны в опубликованных комментариях.

(11 голос., в среднем: 4,64 из 5)

(11 голос., в среднем: 4,64 из 5) Как влияет смена дизайна на поведение пользователей

Как влияет смена дизайна на поведение пользователей  Можно ли доверять SimilarWeb? Анализ 2350 сайтов Рунета

Можно ли доверять SimilarWeb? Анализ 2350 сайтов Рунета  Как проверить, нужны ли тексты в категориях интернет-магазинов

Как проверить, нужны ли тексты в категориях интернет-магазинов

В начале года проводил подобный эксперимент. Удалил порядка 60%. Сайт минимально, но подрос по обеим поисковым системам где-то на 30%. Кроме редиректов по некоторым статьям делал объединения, т.е из нескольких статей одну.

Удалял статьи, но редирект делал на другие продвигаемые у которых есть трафик. Второй вариант, если статьи все же приносят трафик, но мало, то обновлял контент, учитывая что статьи уже в индексе, то результат проще и быстрее получить.

Спасибо за статью. Но почему нельзя редиректить на 404 если статья отсутсвует на сайте?

Когда это единичные случаи, то нормально, но когда в 404 падает больше половины сайта, то для ПС может показаться странным. По крайней мере, я бы не рекомендовал в данном случае (как в приведенном примере) оставлять 404.

Поделюсь опытом. Лето 2021, удалил 40% сайта, оставил 404. Никакого эффекта спустя 3 месяца, ни в одну из сторон.

Как-то чистил один проект, просто удалил статьи без трафика (в основном это были как раз тех из времен — больше страниц=выше доход по 2000 знаков).

Редирект ставил только с тех страниц, на которые были ссылки в сети. Масштаб был поменьше, процентов 10-15 страниц.

Ни к каким видимым изменениям ни в Я ни в Г не привело.

Из плюсов — чуть места на хостинге освободилось и карта сайта для людей стала более адекватной.

Спасибо за статью, надо будет тоже попробовать потестить)

Деньги за второе место получила.

Всё честно и правдиво! Благодарю)

Приз за конкурс получил. Спасибо!

Интересный эксперимент. Очень практическая и полезная информация.

Пы.Сы. Приз за конкурс получил. Спасибо!

Я на одном сайте тоже был удалил 20% статей, так у меня трафик серьёзно просел. По поводу конкурса сейчас напишу на почту.

Свой приз получил, спасибо!

И я свой приз за конкурс забрал, сенк ю

Приз за участие в конкурсе получил. Спасибо!

Статья интересная, однако, как мне кажется, нужна достаточно большая выборка сайтов как в ру, так и в бурже, на которых были аналогичные манипуляции с зомби-страницами, чтобы понять действенный способ или же это банальное совпадение.

А нет смысла доработать эти статьи до текущих требований ПС?

И попутно вопрос: как массово проверить страницы сайта на количество трафика из ПС и при этом провести корреляцию по потенциальному объёму трафика по семантике каждой статьи?

1. В моем случае смысла дорабатывать не было. В других случаях необходимо принимать решение по ситуации (какие-то материалы дорабатывать смысла нет, какие-то можно доработать).

2. Я такого инструмента не знаю.

Доброго времени суток

Если я правильно вас понял, то предлагаю сделать анализ следующим образом:

1) Экспортируем данные из Ahrefs (Semrush или Serpstat) на видимость сайта по ключам.

У Ahrefs есть свой параметр частотности SearchVolume. Можно опираться на него, либо дополнительно спарсить частотность по Google и Yandex. Для этого можно использовать сторонние сервисы.

2) Для каждой страницы группируем ключи и суммируем частотность на видимость в top3, top10, top20 и до нужной вам глубины. Эта операция группировки реализовывается в пару строк кода на любом языке программирования.

3) Если у вас есть доступ к аналитике, то экспортируем данные оттуда и объединяем с уже имеющимися.

И так, у вас должна получится наглядная картина видимости по каждой странице сайта и потенциальная частотность по нужной вам глубине выдачи.

Допустим мы видим, что страница n видна в top20 выдачи с общие частотностью ключей 10000 в месяц — то я бы попробовал улучшить эту страницу и добить ее до топа, чтобы получить больше трафика.

Если вам это показалось сложно, то могу сделать наглядный отчет для вашего сайта.

Да, хороший способ. Не совсем простой, но эффективный. По типу поиска самых перспективных страниц для продвижения.

Повторюсь, в моем случае дорабатывать смысла не было.

Я раньше тоже был приверженцем 301 редиректа на что-то новое у удаленных страниц. Но потом как показала моя практика — 404 все-таки намного лучше. В особенности если удаляются мусорные страницы, не имеющие веса и траста.

Почему такое сложилось впечатление? Быстрее из индекса выпадают?

При 404 значительно быстрее выпадает старое из индекса, при редиректе последнее время гугл старую страницу с редиректом не выкидывает из индекса, а держит ее там некоторое время с новым заглавием и описанием страницы, на которую редирект, т.е какой-то дубль в индексе получается.

Да, также было замечено, что страницы с 301-редиректом не сильно быстро пропадают из индекса.

Прошло еще полтора месяца.

Как сейчас обстоят дела с сайтом?

Или что-то делалось дополнительное, что может повлиять на чистоту эксперимента?

Особо ничего больше не делалось. Яндекс скаканул на днях (еще не разбирался почему). Может быть и ему нравятся более «чистые» сайты (он же всегда долго думает ). Вот актуальный график take.ms/SG81v .

). Вот актуальный график take.ms/SG81v .

Глупо удалять столько контента … Хотя бы перенесли на поддомен чтоли. На основной почти все с гугля, а на поддомен и тот что с яндекса.

В данном случае «удалялся» устаревший неактуальный контент. На поддомене он также ничего бы хорошего не принес

А если вначале закрыть такие страницы от индексации, а потом уже постепенно удалять? Будет лучше, чем 301 редирект?

Удаление не лучший вариант, потому что, если на страницы вели ссылки, то в полной мере они не будут работать на страницы с 404-ошибкой. На мой взгляд. лучше сразу ставить редирект, чтобы не делать двойной работы. Но это если давать универсальный совет. Бывают индивидуальные случаи, когда будет уместно закрытие от индексации без редиректа (например, документ нужен пользователю, но бесполезен для поиска).

Здравствуйте! Вопрос, возможно, не совсем по теме, но ломаю голову уже довольно давно над ним. В общем, на сайте есть статьи, с которых идет практически основной трафик, но поведенческие у них плохие. Тематике сайта они не совсем подходят. Написаны были исключительно для «общего» развития читателей и не предполагалось, что они станут приносить трафик в большом количестве. Короче говоря, я испортил аудиторию сайта.

Как итог, сайт из-за плохих поведенческих факторов упал и не может подняться уже довольно длительное время.

Вопрос: можно ли убрать из индекса данные страницы (естественно, потеряв в трафике)? Может ли оказать положительный эффект такая «чистка»?

Заранее спасибо!

Какие поведенческие показатели у этих страниц (отказы, время)?

Если взять среднее значение, то примерно 1:10 — 1:30, а показатели отказов 10-15%, глубина просмотра 1,10-1,20. Вроде бы получается неплохо, но по тематике всего сайта они не совсем подходят

Сергей, спасибо за интересный эксперимент.

Но он больше для Гугла, да, Яндекс на такое не реагирует или реагирует слабо.

Делал подобное тоже с 1 сайтом, правда, 1 сайт не показатель, конечно.

Спасибо за подробную инструкцию. А если просто сделать редирект 404 ошибки на главную страницу сайта?

Не совсем понял. Просьба подробнее

Если вместо «Redirect 301 /page-1/ httрs://site.ru/» сделать редирект 404 ошибки на главную страницу, чтобы не прописывать каждый удаленный урл? Тогда с удаленной страницы будет редирект на 404, а оттуда также на главную.

На мой взгляд, не лучший вариант:

1. «Мой» способ:

URL -> Главная

2. «Ваш» способ:

URL -> 404 -> Главная

То есть потенциальный вес будет передаваться не с удаленной страницы, а со страницы 404 ошибки.

Также пропадает функция 404-страницы для незомби целей.

Добрый день! Как на данный момент спустя несколько лет Ваше видение эксперимента и его результатов?

И осталось не совсем понятно: зачем сначала помещать статьи в черновики, а не сразу удалять? Ведь все равно будет отдаваться 404 ошибка…

Добрый день! Мероприятие по удалению зомби-страниц не обязательное, но если на сайте много (более 30-50%) неактуальных/неважных страниц, которые не приносят входящий трафик (плюс нет входящих ссылок), то есть смысл их удалить.

Можно сразу удалять, не помещая в черновики. Но, на всякий случай, оставить в корзине (если CMS — WordPress).