Влияние отклонения ссылок в Google Disavow Links и обновление алгоритма Пингвин

Привет, друзья! В этом посте я опубликую результаты эксперимента, который затянулся практически на год. Все прекрасно знают про Google Penguin и про инструмент Disavow Links, который позволяет отказаться от некоторых или всех входящих ссылок (гугл говорит, что в таком случае он не будет учитывать их).

В начале октября 2013 года было очередное обновление Пингвина. Позже 13 декабря я решил провести эксперимент, добавив в Disavow Links все входящие ссылки известные на тот момент гуглу. Затем я стал ждать очередного обновления алгоритма. Не думал, что ожидание продлится практически год. О результатах эксперимента ниже.

Вообще, задачей эксперимента было определить, влияет ли отмена ссылок в Disavow Links на позиции и, соответственно, посещаемость. Или же это только лишь вспомогательная функция для принятия решения алгоритмами поисковой системы.

Я планировал опубликовать результаты через месяца 3-4 после начала исследования, но google решил не спешить с обновлением Пингвина. В связи с этим актуальность данных находится под сомнением. Но не зря же я ждал практически год? Поэтому публикую .

Итак, для 3-х сайтов (включая этот блог) в Google Disavow Links были отклонены все входящие ссылки сразу на уровне доменов. Ссылочная масса у ресурсов достаточно весомая, чтобы играть роль при ранжировании.

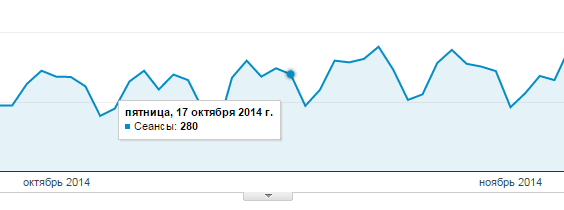

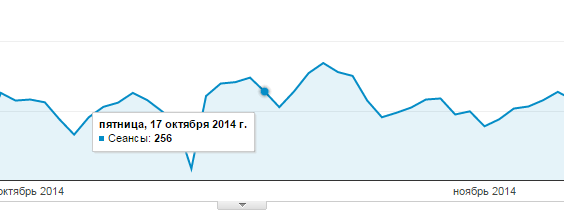

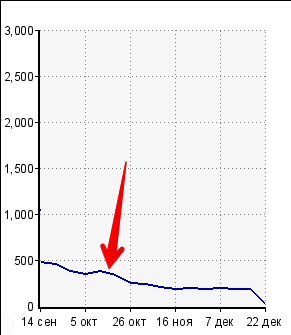

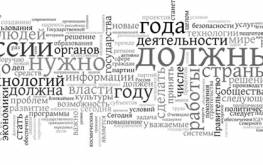

17 октября было очередное обновление алгоритма Google Penguin. Показываю статистику посещаемости с гугла для этих 3-х сайтов.

№1.

№2.

№3.

Точки и стрелочка — это дата обновления алгоритма. Как видите, ничего кардинального не произошло. Какие выводы я сделал в рамках эффективности Google Disavow Links:

- Только на этот инструмент уповать нельзя.

- Возможно, он полезен для сайтов попавших конкретно под Пингвин гугла.

- Возможно, он полезен для ресурсов, у которых в Google Webmaster есть меры, принятые вручную относительно входящей ссылочной массы.

- Я не первый у кого не было существенных изменений после использования этого инструмента.

- Маловероятно, но как вариант. Отклонение плохих ссылок наравне с хорошими привело к сохранению баланса посещаемости.

Какие у вас мысли на этот счет? Кто отказывался от ссылок в Disavow Links? Какие получились результаты? Удалось ли увеличить количество посетителей с гугла?

В конце поста снова хочу пригласить вас принять участие в конкурсе "Новогодние интернет-картинки 2015". Отличные шансы попасть в число призеров (хотя никто без приза не останется). До конца конкурса осталось чуть больше недели. Жду и ваши картинки .

(12 голос., в среднем: 3,75 из 5)

(12 голос., в среднем: 3,75 из 5) С 1000 посетителей в сутки до 2000 за 3 месяца (часть 2): отчет №1

С 1000 посетителей в сутки до 2000 за 3 месяца (часть 2): отчет №1  Бесплатные методы составления семантического ядра для сайта

Бесплатные методы составления семантического ядра для сайта

Скорей всего так и есть, инструмент полезен лишь для тех кто попал непосредственно под пингвин…

Вижу моя картиночка попала в пост, спасибо…

Тоже уже больше года назад убрал огромное количество ссылок через Disavow Links. После чего, вроде как, ручные меры даже сняли.

Только трафик с Гугла, как составлял 10% от трафика с ПС, так и составляет. Т.е. какой-то фильтр так и висит.

По мне так это только для выхода из-под фильтра. да ручных санкций

Попадал под фильтр, пришло письмо о SEO ссылках, отправил сайт на пересмотр, с сообщением о том что ссылки не закупались и снять не могу. Через месяц фильтр сняли.

Я отклонял ссылки и траф жестко просел сразу через месяц где-то! Вернул обратно! Но я делал жесткую чистку через checktrust!

AnalizSaita.com, а на самом деле закупали или нет?

Я отклонил большое количество ссылок полгода назад, но эффекта нет, даже не понял до конца, отклонились предложенные мной гуглу ссылки или нет, сначала ждал, проверял, а потом просто надоело это занятие))

дык еще в 12 году писали бурги о том, что DL не работает супротив пингвина, народ много опытов ставил. тулзятина годится собственно тока для ручного фильтра за искусственные ссылки, а из пингвина надо вытаскивать изменением процентовки анкорной составляющей, т.е если есть доступ к ссылкам, то сменой анкоров на безанкор, если нет, то размытием ссылочного портфолио, причем как доменной, так и постраничной картины.

после того как безанкор переваливает за 70-80% фильтр снимается — в этом плане помогают безанкорные прогоны, для увеличения безанкоров с доменов и пара-тройка безанкорных сквозняков для постраничного размытия

С первыми двумя графиками все понятно. А вот на третьем идет постепенное снижение трафика, с чем Вы это связываете?

Lev_PRushhij, на последнем графике трафик падал и до обновления пингвина. Апдейт тенденцию не нарушил.

Тоже отключал и тоже никакого эффекта. Видимо правда инструмент, для того чтобы вывести сайт из под фильтра…

А че трафик-то, за позициями наблюдал кто-нибудь?

Альберт, позиции не снимал.

Я тоже занимался отключением ссылок, но только с ГС сайтов. Убрал порядка несколько тысяч и в тот момент у меня действительно был рост позиций почти по каждой из страниц. Возможно это было простым совпадением..

То, что вы просто тупо отправите файл с ссылками на отклонение — до жо*ы. надо писать в тех. поддержку. Но, если на первых порах, после появления данного инструмента с сайта снимали фильтр, то сейчас это не прокатывает. Как правило, присылают ответы с намеком, что братец надо бы было потрудиться и ручками убрать ссылки, вводящие в заблуждение поисковую систему. Обычно под фильтр можно загреметь за продвижение размноженными статьями. По моему опыту скажу, что фильтруют сайт после достижения некоего предела критического числа таких ссылок.

Сначала покупают ссылки, потом пс говорит, что такие уже не работают, а такие вредят. Потом мастера удаляют ссылки и покупают новые под новые требования, потом опять запреты. Давно читаю подобные посты и такое чувство что это вечная борьба. Или мне только так кажется и в этом есть толк?

Судя по опубликованным картинкам, я знаю кто будет победителем

Алиса, есть в ваших словах логика. Но многие вебмастера и оптимизаторы хотят быстрее или эффективнее осуществлять продвижение, поэтому внимание уделяют не только качеству проекта, но еще и искусственному созданию ссылочной массы.

Sosnovskij, про скорость таких решений полностью согласна. Наверно у меня давно небыло срочных проектов. Создаю проект, наполняю контентом по ключам и жду пока отстоится в пс 6-12 месяцев:) А в это время развиваю новый проект. Тем самым затрат меньше и нет страха, а вдруг завтра будут новые ограничения или страшный фильтр и тем самым все деньги и время в трубу. Конечно это не идеальный вариант, так как про первые строчки жирных запросов можно забыть, но в топ 10 часто выходит по низкочастотным.

Sosnovskij, Спасибо вам за ваш блог очень интересно читать.

За какое количество ссылок можно попасть под фильтр? До 1000 не стоит волноваться?)

Я тоже занимался отключением ссылок. Убрал несколько тысяч и в тот момент у меня был рост позиций почти по каждой из страниц.

Максим, нельзя точно сказать. Многое зависит от существующей ссылочной массы, ее состава, самого ресурса и так далее.

Два дня назад проверял сайт, оказалось, что больше половины ссылок входящих не трастовые, добавил их в этот инструмент в гугле, буду ждать, что произойдет…

Здравствуйте!

Работал над отклонением ссылок для большого проекта, нужно было проверить около 5000 доменов. Для ускорения работы решил автоматизировать процесс проверки. В результате получился такой disavow.tools/ru/ аддон для Мозиллы, который значительно ускоряет процесс проверки.

После загрузки общего списка с ссылками, происходит автоматическая проверка на наличие ссылок. И отсеивается часть ссылок, которые нет смысла проверять, т.к. ссылок уже нет.

При ручной проверке качества аддон найдет на странице вашу ссылку, выделит ее цветом и прокрутит страницу так, чтобы ссылка была в поле зрения. Т.е. вы видите и ссылку и ее окружение.

Для оценки одного сайта/страницы нужен лишь один клик или нажатие горячей клавиши. После чего автоматически загрузится следующая по списку страница.

Скорость проверки возросла раза в 4 в сравнении с проверкой вручную.