Зависимость дополнительных результатов поиска по сайту в Яндексе и места в ТОП 10

Привет, друзья! Вот и пришло время результатов моего долгожданного анализа поисковой выдачи Яндекса. Почему долгожданного? Потому что, во-первых, обещал его опубликовать достаточно давно. Во-вторых, было проделано много работы. Спешу поделиться полученными результатами.

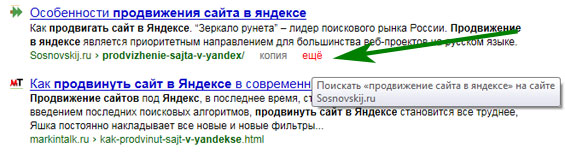

Заголовок немного получился заумным, но именно так и назывался анализ, которым я заинтересовался несколько недель назад. Его целью было определение зависимости между позицией в ТОП 10 и количеством дополнительных результатов поиска по сайту. Все мы прекрасно знаем, что в поисковой выдаче Яндекса есть такая кнопочка "Еще".

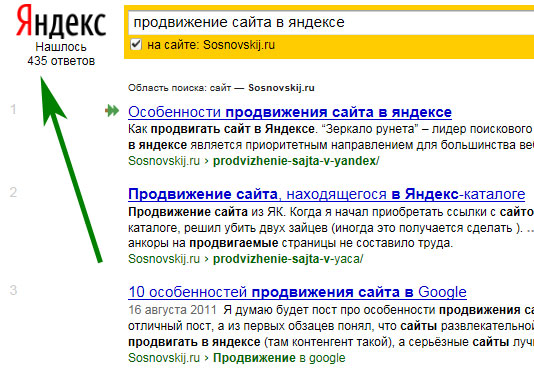

Она показывает результаты поиска по данному запросу только в пределах выбранного ресурса. В приведенном выше примере страница по ссылке будет выглядеть так.

Видно, что с моего блога по данному ключевому слову еще есть 435 ответов на запрос пользователя. Так вот, мне стало интересно, есть ли зависимость между данным числом на место в ТОП 10?

Логика и суть анализа

В чем здесь логика? В том, что по идее было бы эффективнее выше показывать в поисковой выдаче проекты, которые смогут дать пользователю больше ответов на его запросы. Конечно, это не может быть ключевым фактором в ранжировании. Зато для понимания принципов работы поисковой системы Яндекс, выявления закономерностей поведения алгоритмов, считаю, что знать будет не лишним .

Начало анализа

Чтобы провести данный анализ, в первую очередь, нужны были ключевые слова. Для более точных результатов я решил подготовить их вручную. Мною было выделено 4 группы по 500 запросов в каждой (в итоге получилось 2000):

- Геозависимые высокочастотники;

- Геозависимые низкочастотники;

- ГеоНезависимые высокочастотники;

- ГеоНезависимые низкочастотники.

Почему именно так? Хотелось проанализировать поведение поисковой выдачи в 4 разных средах:

- Коммерческие с высокой конкуренцией;

- Коммерческие с низкой конкуренцией;

- Некоммерческие с высокой конкуренцией;

- Некоммерческие с низкой конкуренцией.

То есть было принято допущение: высокочастотный=высококонкурентный, низкочастотный=низкоконкурентный. В качестве анализируемого региона был выбран "Москва". Среднечастотные запросы не брал, чтобы оставить большой коридор между анализируемыми группами.

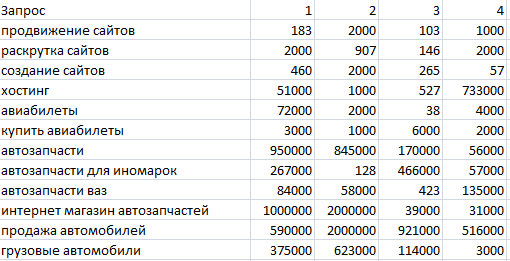

На список запросов и ушла львиная доля времени . Для выявления количества результатов поиска по сайту для выбранных ключевиков, исходя из места в ТОП 10, я заказал парсер на бирже фриланса. Если делать все это вручную, то заняло бы не меньше нескольких недель. В результате получалась такая картинка (видно только ТОП 4).

То есть сначала идет запрос, а дальше количество результатов по ссылке "еще" для 1-го места в десятке, для 2-го, для 3-го и так далее. Ключевые слова выбирались не из одной тематики. Охвачено было примерно 90-100 сфер: от хостинга до вязания. На одну сферу бралось не более 10 ключевиков. Если в запросе было имя собственное, указание региона, а также явное указание на какой-то ресурс (например, "вконтакте" или "одноклассники"), то он не брался в расчет.

После получения всех данных по 4-м группам запросов встал вопрос - "Как анализировать полученные данные?". Сначала я хотел просто сложить сумму количества результатов для первого места в выдаче, потом для второго и так далее. В этом случае, были бы большие погрешности. Сравните, например, "продвижение сайтов" и "интернет магазин автозапчастей". Для первого не больше 2000 результатов, а для второго - не менее 31000. То есть второй тянул бы одеяло на себя .

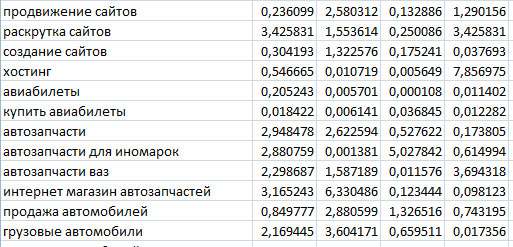

Потом была идея взять 1-е место за единицу, а остальные сравнивать именно с первой позицией. Данный вариант также не давал объективную оценку. Третьим же и, как я считаю, наиболее удачным вариантом оказалось отношение количества результатов поиска по ссылке "еще" к среднеарифметическому из ТОП 10 по анализируемому запросу. Другими словами, сначала высчитывалось среднее арифметическое по строке, а потом оно становилось знаменателем для каждого значения из столбца. В результате было получено следующее.

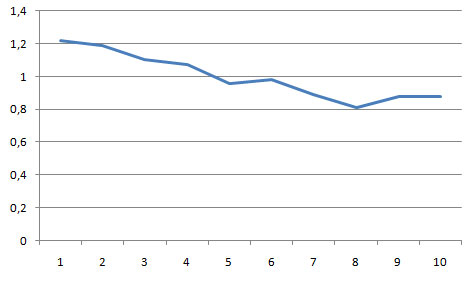

Далее было высчитано среднее арифметическое для каждого столбца и уже получены графики зависимости.

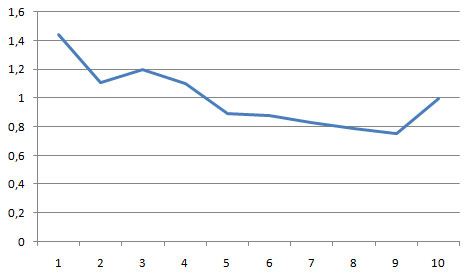

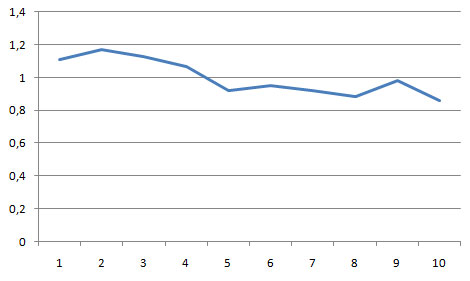

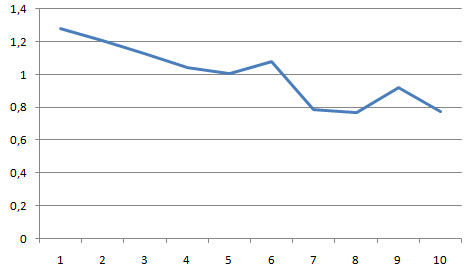

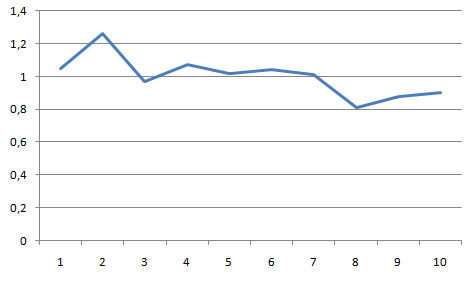

По оси X место в ТОП 10. По оси Y - среднеарифметическое от отношений количества результатов поиска по ссылке “еще” в Яндексе к среднеарифметическому из ТОП 10 по анализируемому запросу.

Результаты анализа

Для коммерческой высококонкурентной среды

Для коммерческой низкоконкурентной среды

Для некоммерческой высококонкурентной среды

Для некоммерческой низкоконкурентной среды

Сводный график

Выводы

В среднем по массиву анализируемых запросов наблюдается снижение количества результатов поиска в пределах сайта по ключевому слову. Особенно это заметно на сводном графике. Что это может означать? То, что сайты, которые дают больше ответов на запросы пользователя в среднем оказываются выше в поисковой выдаче.

Это также может объяснять факт того, что довольно трудно продвинуть нетематическое ключевое слов. Например, "уход за хомячками" на ресурсе про рыбалку. Также это может объяснять, широкое присутствие тематических сайтов в десятке Яндекса.

Погрешности

Я выбирал запросы для анализа только по тем параметрам, которые были указаны в начале поста. Все остальные факторы имели значение случайности. Но все равно на 4-х графиках отмечается одинаковая тенденция.

Возможно, если какой-то другой человек сделает свою выборку по запросам, то могут получиться другие графики. Для кого-то моя выборка в 2000 запросов может показаться нерепрезентативной. Да, например, список в 1 миллион анализируемых ключевых слов мог бы показать более объективные результаты. Но затраты ресурсов (в первую очередь, временных), на мой взгляд, не оправдали бы важность полученных выводов.

По ходу подготовки к этому анализу в голову пришла еще одна интересная идея для исследования. Также нужно проанализировать на эту же тему и google. Но все это будет в новом году, а пока я жду от вас комментарии и отзывы . Если появились какие-то вопросы, то задавайте их ниже.

Мифы о wordstat или как наиболее точно рассчитать трафик по ключевым запросам?

Мифы о wordstat или как наиболее точно рассчитать трафик по ключевым запросам?  Целевой и мусорный (пустой) трафик

Целевой и мусорный (пустой) трафик

Конечно интересно, но как-то не очень ясно что нужно делать в следствие этих выводов. То есть нужно по определенному ключевому слову написать больше разных статей?.. А как тогда правильно распределить тайтлы и дескрипшены, то есть ключи в них..

Алексей, не нужно под один и тот же запрос создавать отдельные страницы. Главное, чтобы по запросу сайт выдавал как можно больше ответов. Это не означает, что все документы на проекте должны быть заточены под один ключевик.

Пробовал так делать.

Не работает.

Это как бы рекомендация хорошая. но в топ сайт она не выведет

Количество страниц в поиске – это абсолютно не показатель. Для этого даже эксперимент не стоило проводить.

Проверить можно было просто проанализировав выдачу. Сам продвигаю сервис онлайн-консультирования для сайта. В том числе по запросу [консультант]. Стало интересно проверить эту зависимость у сайтов в ТОП-20. Так вот, по этому запросу (регион СПб) у трёх сайтов, находящимся в 20-ке количество страниц от 26 до 98 (мой в их числе), а у остальных от нескольких тысяч, до нескольких миллионов.

Собственно говоря, эксперимент на этом можно закончить

Алексей Владимирович, вы вообще читали пост? Идет речь не о количестве проиндексированных страниц — это, во-первых. Во-вторых, 1 запрос — совсем не показатель.

Алексей Владимирович, и еще, это не эксперимент, а анализ :).

Александр, конечно, не выведет. Если эта зависимость и влияет на ранжирование, то является далеко не определяющим фактором.

Sosnovskij, Вообще читал, поэтому и комментарий оставил. Возможно, 1 запрос не показатель, так проверить можно по любому количеству. Знай себе — бери запрос и анализируй выдачу. Для этого анализа не стоило нанимать фрилансеров, имхо.

В каком месте я написал о «количестве проиндексированных страниц»? Если вас смутила фраза «Количество страниц в поиске «, то употребляя её я и имел ввиду кол-во страниц по данному запросу.

Не зря качественные нишевые проекты ранжируются на порядок лучше, чем сайты более широких тематик.

Стоит отметить, что и в данном случаи возможен переспам. А также не стоит забывать о качестве контента.

Алексей, на практике, если вы продвигаете запрос «жидкая теплоизоляция», то на вашем ресурсе должны быть страницы такие как «жидкая теплоизоляция крыши», «жидкая теплаизоляция трубопроводов» и т.д.

По сути это продвижение низкочастотки, которая своим весом помогает поднять основные запросы. Поэтому рассматривать отдельно количество документов не правильно — все взаимосвязанно.

Алексей Владимирович, я вас уверяю, что самому проверить 2000 запросов у вас не получится. Фрилансеров я не нанимал, а обратился к 1-му человеку для разработки парсера, который существенно сэкономил время.

Интересное исследование, но, на мой взгляд, не совсем корректное. Я бы рассматривал не количество ответов на запрос, а долю страниц сайта, отвечающих на запрос (другими словами, тематичность). На твоём блоге проиндексировано около 1000 странц, из них 435 отвечают на вышеуказанный запрос, т.е. около половины страниц. Если сравнивать с сайтом, на котором проиндексировано 10000 страниц, но на запрос отвечают так же 435, то логично предположить, что он будет ниже в выдаче. И вот это было бы интересно проверить на той же самой выборке.

Отличная статья. Обязательно поэксперементирую. Раньше не задумывался.

bCrazy, вот это как раз я и собираюсь проверить в следующий раз .

.

>>Видно, что с моего блога по данному ключевому слову еще есть 435 ответов на запрос пользователя.

Очень часто бывает, что ключевое слово может находиться в шаблоне (футер, меню) и тогда по кнопке будут показаны все проиндексированные страницы сайта. А они не обязательно являются доп. ответами на запрос пользователя.

На мой взгляд, для более точного эксперимента, нужно было использовать запрос site:domen.ru title:(ключевое слово), где domen.ru это сайты из топ10 по выбранному запросу. Таким запросом вы с большей вероятностью найдете реальные доп. ответы по запросу, ведь если запрос есть в тайтле страницы, значит страница должна быть ему релевантна.

pilika, поэтому и брались не 10 запросов, а 500 .

.

Рекомендация очень хорошая, но она не дает такого весомого результата

Это и так ясно, не стоило делать эксперимент. Пост не твоего уровня.

Александр, это почему же и так ясно? С чего бы? На интуитивном уровне :)? Есть похожие анализы в рунете? Может, я просто пропустил.

Сергей, молодец! Довольно интересно. Лично для меня этот пост кое-что объясняет. В принципе, я уже давно заметил, что ВЧ ВК и в Яндексе и в Гугле хорошо двигаются, если на сайте много материала по теме. (конечно, качественного материала)

Как по мне, то этим можно «страдать» уже только когда все по проекту (сайту/блогу) сделано.

Sorus_Nomad, по этому в принципе не нужно страдать . Это можно просто иметь в виду.

. Это можно просто иметь в виду.

Прекрасный пост. Если сначала заниматься оформлением блога, а потом только написанием качественного контента, я думаю это не правильно. Нужно продвигать блог во всех направлениях.

«Для кого-то моя выборка в 2000 запросов может показаться нерепрезентативной.»

Да хоть 5 или 10 миллионов запросов! Рожденному ползать…

всю работу вы сделали для себяи она вполне устраивает. Другому все разжуй и в рот положи, а ни капли толку. Для себя лично я некоторые моменты взял на заметку, а к некоторым придется вернуться вновь…

Мне, чтобы понять придется раз 20 прочитать, ну что ж у вас на блоге полезные посты…

Интересное иследование!Впринципе логика есть!

хороший анализ, я бы даже сказала эксперимент

Хорошая работа

TF-IDF в действии

Хорошее исследование. Хотя выводы изначально были предсказуемы, теперь есть отличное доказательство.

Из своего опыта давно уже заметил, что с публикацией страниц с заданными ключевыми словами, начинает подниматься в выдаче основная продвигаемая страница. Если добавить к этому ещё внутреннюю перелинковку, то некоторые СЧ запросы можно вывести в ТОП-10 без покупки ссылок.

Серьезный материал. Потверждение той истины, что материала по одной теме должно быть несколько.

Конечно интересно, но как-то не очень ясно что нужно делать в следствие этих выводов. То есть нужно по определенному ключевому слову написать больше разных статей?.. А как тогда правильно распределить тайтлы и дескрипшены, то есть ключи в них..

полный бред, любая проверка сразу даст кучу сайтов где ЕЩЕ в тысячи страниц ниже чем ЕЩЕ в 10 страниц прокачанная ссылками.

Сергей, поражаешь проницательностью. Помнится, года полтора назад, заметив как ПС любят тематичные сайты, я задала этот вопрос здесь, чтоб подтвердить свои догадки. Ты ответил: нет, тематика не влияет… Спорить не стала, но если б ты тогда добавил несколько страниц с «BestMasterиZация» в титл (например, новость какую-то), уверена, было бы первое место.

bCrazy, а в чем разница — 435 тематичных страниц с миллионника или с тысячника? Это влияет на информативность? Сайт хорошо раскрывает тему, а сколько страниц помимо этого вряд ли существенно. Процентным соотношением мерять нельзя, тема от этого не становится менее информативной.

Спасибо Сергей, за статью. Интересный материал

site1992, этот пост скорее для понимания, чем для каких-то определенных действий.

natkalin, не напомните комментарий?

вася, вы называете бредом пост, но я ничего не понял из вашего комментария :).

Алексей Владимирович,

это просто ужас. КАК можно продвигать сайт по слову «консультант»? Это же не транзакционный запрос, это АД! Все равно, что продвигать интернет-магазин по слову «купить».

Блин, катал катал коммент, а при добавлении меня спросили бот ли я без возможности ответить. Короче vm.msun.ru/Autor/Gusakov/Gloss/Hg.htm и Excel в помощь. В принципе среднеарифметическое сюда приплести возможно и стоит, не знаю, попробуй и другие способы.

в «Некоммерческие низкой конкуренцией.» предлог «с» пропущен

Валли, спасибо, поправил. Метод посмотрю.

Sosnovskij, поддержу bCrazy:

Интересно было бы ещё уточнить и влияние веса самих страниц — то есть мало того, насколько часто эти запросы на каждой странице встречаются, учесть бы ещё, сколько раз встречается на каждой из страниц и сам запрос, и однокоренные слова к словам из запроса.

Truman, это уже совсем другая сфера, не входящая в рамки данного анализа .

.

Sosnovskij, я это прекрасно понимаю — сложность, навскидку, на порядок выше.

Спасибо за то, что есть! Скорее всего, в большинстве случаев, общее большое количество релевантных статей напрямую связано с высокой релевантностью каждой из статей, так как это указывает на сферу интересов участников дискуссий. Но отклонения от тенденции (пики на вторых-третьих местах) можно было бы (теоретически ) как раз списать на невысокую релевантность статей.

) как раз списать на невысокую релевантность статей.

Большое спасибо за информацию. Раньше я как-то не задумывался проводить анализ таким образом, но попробую по некоторым поисковым запросам. Возьму вашу работу за пример)

Спасибо за статью

Обзор интересный. Работа проведена качественно — спасибо автору. Но вот только выводы, ИМХО, не совсем верны!

Если рассмотреть первую приведенную таблицу по строкам, можно обнаружить интересный факт — закономерности-то нет.

Только по одному запросу «ещё» сайтов строго ранжировано. По двум — максимум у 1-го сайта, по двум — у четвертого, по двум — у третьего, по пяти — у второго.

При этом разница между «ещё» соседних в выдаче сайтов может различаться более чем на порядок.

При таких условиях усреднять противопоказан! Иначе получаем пресловутую «среднюю температуру по больнице»!

София, массив данных не складывался из 10 запросов. Вы предлагаете просто сложить общее количество дополнительных ответов с сайтов для 1 места, для 2 места и так далее без усреднения?

Sosnovskij, ни в коем случае, хотя это принципиально ничего не изменит (на графиках уменьшится масштаб по оси ординат).

Насчет нецелесообразности усреднения, это я вовсе не к тому, что Вы некорректно провели расчеты! Просто в приведенных данных больше видны различия, нежели какая-либо общая тенденция. (Понимаю, что это не все результаты — но что показали, на то и смотрю )

)

Да и по графикам можно заметить большие отклонения от «линии тренда», связанные, скорее всего, с присущей объему «ещё» вариативностью. А потому, опять-таки на мой взгляд, это самое «еще» – не влияющий фактор, а «побочный продукт» какого-либо другого фактора

София,

«хотя это принципиально ничего не изменит (на графиках уменьшится масштаб по оси ординат).»

Попробуйте поработать с таким объемом данных и вы увидите принципиальную разницу без усреднения. Цитата из поста «Сравните, например, “продвижение сайтов” и “интернет магазин автозапчастей”. Для первого не больше 2000 результатов, а для второго – не менее 31000. То есть второй тянул бы одеяло на себя.»

«Просто в приведенных данных больше видны различия, нежели какая-либо общая тенденция.»

Скриншот куска таблицы — это пример. Необходимы смотреть на графики.

«с присущей объему «ещё» вариативностью»

О какой вариативности идет речь?

Sosnovskij! И я о том же

И по строкам таблицы, и по столбцам разброс значений очень велик. Усредняя, мы получаем не характерную тенденцию, а «дырку от бублика»!

У средних значений есть интересное свойство – они нивелируют индивидуальные различия. Поэтому усреднять имеет смысл тогда, когда мы имеем дело с показателями, не сильно отличающимися друг от друга. (Говоря о вариативности, как раз и подразумеваю статистический смысл этого термина – отличие значений в выборке от среднего.)

На графики тоже смотрела. Вам кажется, что тенденция есть, мне кажется, что её нет Чтобы понять объективное (насколько применимо это слово к статистике) положение дел, надо попробовать выявить тренд с помощью подходящего статистического критерия.

Чтобы понять объективное (насколько применимо это слово к статистике) положение дел, надо попробовать выявить тренд с помощью подходящего статистического критерия.

Не знаю, что Вам советовал Валли (не открывается ссылка), но есть достаточно простой в применении и неприхотливый (не чувствительный к распределению данных) критерий Аббе.

Стоит для начала, может быть, воспользоваться этим критерием, а затем уже (если результат будет положительным) построить помимо экспериментальных графиков собственно «линию тренда».

Работу по сбору данных Вы провели колоссальную. Действительно, слов не хватает, чтобы выразить свой восторг

Осталась, на самом деле, гораздо менее трудоемкая часть – правильная статистическая обработка этой информации. Она, конечно же, может ничего нового и не показать, но позволит немного отойти от субъективизма в оценке…

София, учитываются индивидуальные различия каждого места для конкретного запроса отношением количества ответов к среднему значению по ТОПу.

Sosnovskij, во фрагменте таблицы — да. А как же с «глобальным» усреднением для каждой из 4-х рассмотренных категорий ( для графиков)?

София, если взять последнюю картинку в посте с цифрами и по столбцам высчитывать не среднее арифметическое, а просто сумму, то графики получаются практически идентичными.

Sosnovskij, совершенно верно! Я и не предлагала вычислять суммы. Напротив, писала: «ни в коем случае, хотя это принципиально ничего не изменит (на графиках уменьшится масштаб по оси ординат).» При существенном различии величин их не надо ни усреднять, ни, тем более, суммировать!

И потом, Сергей, почему Вы решили, что выбор при обработке данных ведется лишь между средним арифметическим и суммой :twisted:. Есть более сложные статистические инструменты, но, сейчас без них – никуда. А раз Вы интересуетесь анализом зависимостей, может быть, стоило бы их освоить.

Но это я в качестве небольшого дополнения. Основное – это аплодисменты! Повторюсь, материал Вы собрали очень интересный, и статья получилась весьма информативной.

София, я не статист. Оперировал тем, чем мог :). На мой взгляд, данные расчеты могут показать приблизительную картину, которая может отражать реальную действительность, происходящую в поисковой выдаче. Возможно, более сложные расчеты и будут объективнее, но вряд ли они, например, развернут графики в обратную сторону или превратят их в горизонтальные линии.