Как отбирать ссылки для отказа в Google Disavow Links

Привет, друзья! Сегодня я расскажу о том, как отбирать и отказываться от ссылок в инструменте Google Disavow Links. Эта информация будет полезна тем, у кого снизился трафик с гугла. Ниже размышления и нюансы отказа от линков в данном инструменте.

Последнее время мировой лидер поиска серьезно начал борьбу со ссылочным спамом. Главным карателем за искусственные или покупные ссылки стал алгоритм Penguin (Пингвин), который наделал немало шума и получил от владельцев сайтов много гнева в свой адрес.

Disavow Links был введен Google примерно 1 год назад. Благодаря нему можно указывать страницы и целые домены, с которых, по мнению вебмастера, стоят искусственные ссылки на его проект. С одной стороны, инструмент полезен. С другой стороны, он является показателем того, что алгоритм Пингвин не идеален и может затрагивать и хорошие качественные сайты. В том случае, если такое произошло, то его владелец может постараться отказаться от ссылок, которые не нравятся гуглу. С третьей стороны, возникает противоречие: отказываться от ссылок нужно владельцу проекта, а линки не нравятся поисковой системе. Таким образом, приходится "угадывать", какие страницы или домены придется добавлять в инструмент.

В первую очередь, пост будет касаться 3-х типов людей:

1. Тех, кто непосредственно пострадал от алгоритма Пингвин.

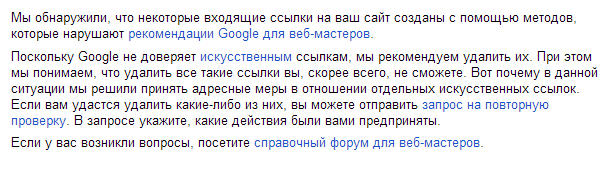

2. Тех, кто получил, так называемые, "письма счастья" в Google Webmaster.

3. Тех, кто все перепробовал и думает, что все несчастья его ресурса в гугле связаны с влиянием искусственных ссылок.

Вообще, Google рекомендует именно удалять искусственные линки. Это не всегда возможно. Есть несколько причин:

- Нет возможности удаления. Нет влияния на вебмастера, либо он не выходит на связь, а также проделки конкурентов.

- Процедура долгая и нудная.

- Существует еще и Яндекс, который непонятно как отреагирует на удаление линков.

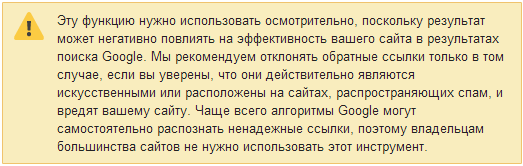

В связи с этим более удобно использовать Google Disavow Links. Но было бы все просто, если бы не несколько нюансов:

- Инструмент носит рекомендательный характер. То есть это рекомендации для гугла, чтобы тот не учитывал те или иные "обратки". На практике после добавления списка страниц и доменов может ничего не произойти.

- Если ваш ресурс застал Пингвин, то, воспользовавшись этим инструментом, его эффективность лучше замерять после очередного апдейта данного алгоритма.

- Если пришло "письмо счастья", то результат замерять после 1-2 месяцев.

- Если ваш трафик с Google не падал, то Disavow Links пользоваться не стоит.

- Инструмент может повлиять не только положительно, но и отрицательно. Им нужно пользоваться осторожно. Если после его использования посетителей с гугла стало еще меньше, то стоит очистить список с "отказными" страницами и доменами, либо пересмотреть его.

С теорией закончили. Теперь переходим к практике .

Выгрузка ссылок для анализа

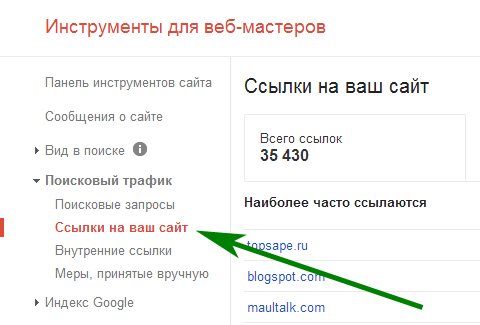

Дело мы имеем с гуглом, поэтому нужно работать со ссылочной массой, о которой знает этот поисковик. Ее можно найти в Google Webmaster. Если ваш проект еще не добавлен туда, то советую это сделать (данные по обратным линкам будут доступны через несколько дней). Разберу на примере sosnovskij.ru.

Необходимо зайти в профиль вашего проекта, а затем на вкладку "Ссылки на ваш сайт" в разделе "Поисковый трафик".

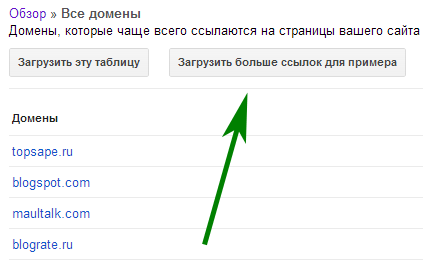

В блоке "Наиболее часто ссылаются" нажимаем "Дополнительно". Появляется список сайтов, ссылающихся на ваш проект. Он ограничен 1000 доменами. Кликаем на "Загрузить больше ссылок для примера". Можно сохранить список на компьютер в CSV.

Было выгружено 11302 страниц. Можно предположить, что в среднем с каждой страницы стоит 3 обратные ссылки, либо гугл показывает не все ссылающиеся страницы (это исходя из того, что общее количество линков 35430).

Так как Google индексирует все, что можно и нельзя, поэтому такое большое ссылающихся доменов и страниц. В списке он также отображает ссылки через редирект.

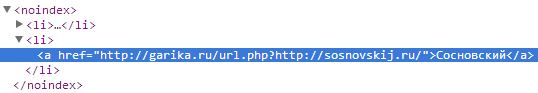

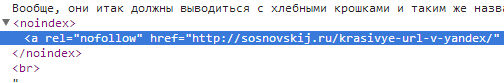

И линки, которые содержат rel="nofollow".

Можно сделать предположение, что подобные "обратки" тоже участвуют в ранжировании, но с заниженным влиянием. Поэтому, если линк стоит через редирект или имеет атрибут rel="nofollow", то это не значит, что его не надо учитывать при отборе.

Если трафик с гугла составляет менее 5-10% от общей посещаемости ресурса, то можно предположить, что самым легким способом стал бы полный отказ от выгруженных данных. Например, если вы уверены, что на ваш проект ссылаются только низкокачественные сайты с прямыми вхождениями продвигаемых поисковых запросов, то следуйте этой небольшой инструкции:

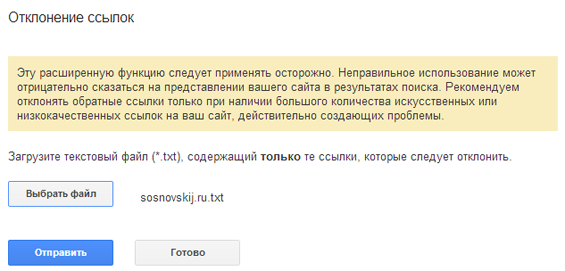

1. Копируйте страницы из CSV-файла в файл с расширением .txt. Каждый URL должен быть с новой строчки.

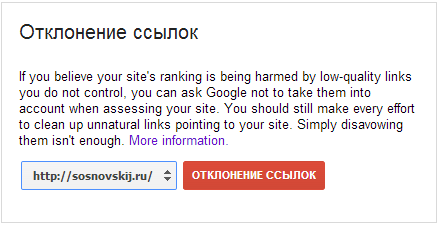

2. Заходите на страницу самого инструмента Google Disavow Links.

3. Выбираете сайт и нажимаете "Отклонение ссылок".

4. Затем загружаете полученный txt-файл (он не должен превышать 2Мб), нажимаете "Отправить" и "Готово".

Все! Сама процедура не слишком долгая . Если причиной спада посещаемости был алгоритм Пингвин (автоматическая санкция), то стоит делать выводы после его очередного апдейта. Если пришло письмо счастья (ручная санкция), то нужно отправить запрос на пересмотр сайта. Причем, ссылки с Google Webmaster не будут удаляться.

Что делать, если вы уверены, что помимо плохих сайтов на ваш проект естественным образом ссылаются качественные ресурсы. Они могут положительно влиять на ресурс. От них избавляться нежелательно. В таком случае нужно отказываться только от плохих линков, прежде сделав их отбор.

Отбор некачественных доноров

Итак, необходимо из всего списка ссылающихся страниц выбрать те, которые нужно будет отправить на отказ. Существует несколько способов для отбора некачественных страниц или целых доменов, которые ссылаются на ваш проект.

1) Ручной метод. Если на сайт ссылается небольшое количество страниц, то можно пойти этим способом. Необходимо открыть каждый выгруженный из Google Webmaster URL и проанализировать документ на предмет качества. Если не только страница, но и весь ресурс является низкокачественным, то можно отказаться от ссылок сразу со всего домена. Для этого нужно вместо URL указать такую строчку:

domain:domen.ru

Это поможет сократить время работы над ссылочной массой. Оценивать площадки можно по следующим параметрам:

- Индексация. Ресурс плохо индексируется в гугле/яндексе (фильтр АГС, бан).

- Низкая посещаемость (ниже 50 посетителей в сутки).

- Качество ссылочной массы: ТИЦ, Pagerank страницы/главной, анализ ссылок по solomono.ru.

- Расположение ссылки. Она должна быть расположена только в основном контенте. Исключение - сквозняки на высококачественных проектах.

- Тематика страницы (желательно и всей площадки) схожа с тематикой вашего ресурса.

- Качество самого контента.

- Анкоры. Тексты линков в виде URL или псевдо естественные вида "тут", "здесь" и так далее в большинстве случаев можно оставлять на сайтах среднего качества и выше среднего. На них же можно оставлять и анкоры в виде продвигаемых запросов прямого и разбавленного характера, если выполняются условия: разнообразие анкор-листа, качества проекта, контента, естественности употребления ссылки, разнообразие документов, на которые идут линки.

- Сквозняки. Их оставлять только на тематических проектах среднего качества (анкоры в виде названия сайта или URL), либо на высококачественных ресурсах (желательно в виде названия сайта или URL).

Собственно эти критерии отбора в любом случае пригодятся и при анализе другими методами. Пример плохих ссылок:

Пример хорошей:

2) Link Explorer от Moz.

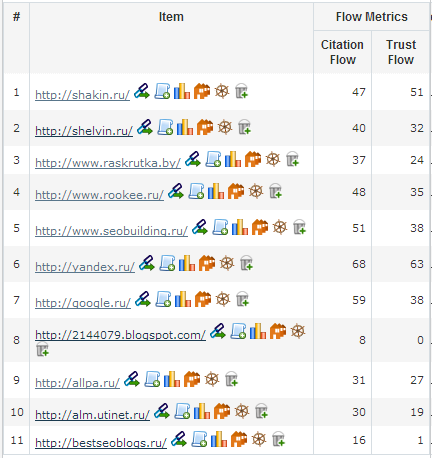

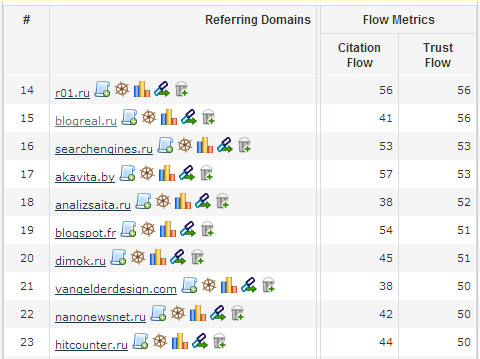

3) MajesticSeo. Еще один интересный сервис, который сможет помочь при отборе. Для работы хватит регистрации и базового аккаунта. Здесь лучше анализировать именно домены, а не отдельные страницы (до 20 штук за 1 раз).

Главные метрики - это Citation Flow (подобие Pagerank) и Trust Flow (уровень доверия). По последнему столбцу и стоит делать выводы о качестве площадки. Ресурсы, имеющие Trust Flow меньше 20 можно сразу добавлять в txt-файл. Остальные изучать вручную. Если сделать несложную и быструю верификацию своих сайтов из Google Webmaster, то можно будет бесплатно смотреть эти метрики по всему ссылочному профилю (доступна сортировка и скачивание на компьютер в виде таблицы).

Опять же единственный минус: база MajesticSeo не совпадает с базой из Google Webmaster.

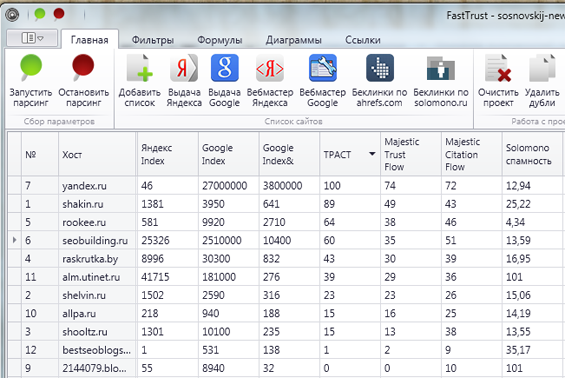

4) Fasttrust. Это программа от небезызвестного Александра Алаева, которая является мощным инструментом для отказа от ссылок в Google Disavow Links. Она позволит сократить время на отбор и делает этот процесс более удобным.

Главной задачей fasttrust является определение траста для сайтов. Как раз эта функция и необходима для поставленной задачи. Программа умеет автоматизировать сбор по множеству параметров из предыдущих методов:

- Индексация в Яндексе и Google;

- Спамность по solomono;

- Посещаемость по liveinternet;

- ТИЦ, pagerank;

- Domain Authority и MozRank;

- Citation Flow и Trust Flow;

- многие другие показатели, которые могут помочь при принятии решения.

Также программа определяет внутренний показатель "Траст", который является альтернативой Domain Authority и Trust Flow.

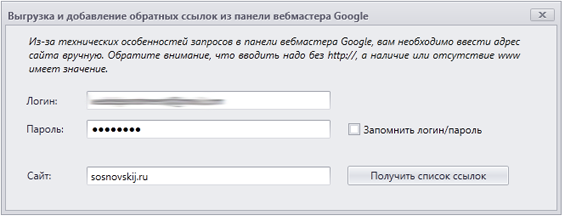

Fasttrust позволяет сразу выгрузить ссылочный профиль из Google Webmaster.

Какие урлы можно смело добавлять в Disavow Links:

- Имеют в индексе гугла менее 10 страниц;

- Имеют спамность по solomono больше 35.

- Траст<10 или Domain Authority<35 или Trust Flow<20.

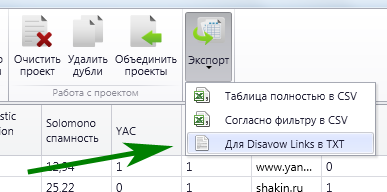

Остальные — при более детальном изучении. В fasttrust есть кнопка, которая позволяет сразу создать файл для Disavow Links, что очень удобно. Дополнительно имеется экспорт в Excel, если вы привыкли работать с данными именно в этой программе.

В общем, программа для данной задачи очень полезная, но она не бесплатная . Стоимость 1 лицензии на 2 компьютера - 3000 рублей. Если вы вплотную занимаетесь оптимизацией и продвижение сайтов, то fasttrust сможет быть полезным не только в направлении отказа от ссылок для Google, но и при создании ссылочной массы в целом. Так что окупит себя в будущем сэкономленным бюджетом на ссылки и временем.

Последнее время тема трафика с поисковой системы Google набирает популярность и споры вокруг себя. Инструмент Disavow Links не исключение. Он не может быть гарантом возвращения посещаемости, но и игнорировать данную возможность также не стоит. Имеется ли у вас опыт в данном направлении?

Сейчас я провожу эксперимент на нескольких ресурсах по увеличению посещаемости с гугла благодаря Disavow Links. Если будут интересные результаты, то, несомненно, поделюсь с ними в блоге. Если у вас возникли какие-нибудь вопросы по данному посту, то смело задавайте их в комментариях .

По факту у Гугла все хитрее.

В примеры плохих ссылок они запросто приводят доноры, которые проходят все автоматические проверки: много страниц в индексе, есть ТИЦ и даже ПР, есть посещаемость, все есть.

Только ссылка и правда покупная.

Владимир Лапшин, и анкорная?

Роман, само собой

Здравствуйте, Сергей. Пишу здесь, т.к. почта не указана у вас в контактах. Помню, у вас на сайте была статья о том, как вытащить статьи из индекса «сопли» гугла в основной. Не могу найти через поиск, т.к. он почему-то не работает — просто появляется строка ожидания, и ожидание длится не первые пол часа.

Почините поиск, пожалуйста

Знать бы, какие именно ссылки наносят вред… Так можно удалить много полезного.

Согласен с Владимиром. Гугл действительно приводит примеры ссылок, у которых и траст выше 30 и спам до 5 (по фасттрасту). Нужно уделить особенное внимание анкорным ссылкам.

Владимир Лапшин, конечно, хитрее Анкорные ссылки оставлять только на качественных проектах.

Анкорные ссылки оставлять только на качественных проектах.

Korchik, такие ссылки нужно анализировать также вручную. Автоматические методы помогут отсортировать заведомо плохую обратную ссылочную массу.

Светлана, он почему-то иногда глючит. Сейчас, например, работает :). Пост https://sosnovskij.ru/experiment-po-vyvodu-stranic-iz-google-supplemental-index/ . Если в следующий раз будут проблемы, то можно сделать запрос в Яндексе «site:sosnovskij.ru ваш запрос». Запрос нужно вводить без кавычек.

А если ссылка донора, а там вирус. И самое странное , что анкор у нее перейти на сайт.

Ольга, от ресурсов с вирусами также стоит отказываться.

Сергей, а что нужно делать, чтобы на своем сайте повысить все эти индексы, чтобы мой сайт другие вебмастера не заносили в Google Disavow Links

Abalu, не продавать ссылки.

Это единственный рабочий способ.

Еще раз повторю, Google приводит примеры плохих ссылок, где все параметры в норме, и даже ссылка вписана в текст очень органично и вроде как к месту.

И такие сайты идут в Disavow Links.

Ибо деваться некуда.

Abalu, лучший вариант посоветовал, Владимир Лапшин :). А какая выгода от того, что другие вебмастера не заносят линки в Google Disavow Links?

да, сейчас топорные методы больше не рулят. нужно с осторожностью подходить, как к выбору доноров, так и к составлению анкор-листа. меня, к счастью, пока не зацепило.

Познавательная статья. Узнал для себя пару моментов которые можно применить.

Да очень хорошая статья , многие инструменты и не знал . Может расскажите как правильно проверять ссылки ( забанял Яндекс или нет ) я думаю к этой теме можно добавить продолжение .

Михаил, забанил ли Яндекс ссылку? Если ссылка есть в сохраненной копии страницы в Яндексе, то он ее учитывает. Если нет, то не учитывает.

Я как-то пытался отказаться от ссылок, отправил их Гуглу, но что-то он похоже их не удалил. А вообще я вручную просмотрел сайты, у которых есть ссылки на мой блог и просто на взгляд определил, какие из них левые. Как правило некачественные ссылки появляются после прогона по каталогам статей. Там вообще оказалось, что половина сайтов сейчас заражено вирусом. Вот после таких прогонов мог блог и попал под санкции Гугла, хотя в вебмастере никаких писем не приходило, а трафика с Гугла нет.

Статья супер! Автору респект!

Только одно но- ссылка на «4000/5» Автор данного курса ошибся с нулями! У него блогу почти 5 лет и посешяемость почти 400 человек!

Ярослав, речь в марафоне не про его блог, а про другой сайт

Сергей, по вашим исследованиям — насколько точные оценки дает Fast Trust?

стоит ли доверять этой программе при анализе доноров?

не слишком ли велика погрешность?

интересен ваш опыт.

заранее спасибо.

Павел Горбунов, стоит доверять. Погрешности, конечно же, есть, но в целом они обычно небольшие.

Спасибо.

Очень сложно оценить работу программы на большой выборке доноров из Сапы в десятки и даже сотни тысяч доноров.

Какие параметры для определения некачественных доноров используете вы?

Павел Горбунов, главные параметры — количество проиндексированных страниц, Траст, Domain Authority, Спам (аккуратно), Trust Flow.

Хорошая статья, спасибо. особенно поравилась подборка по программам. Недавно взял проект, а там именно такой вот расклад — низскотрастовые ссылки с прямыми вхождениями. Пару месяцев покрутил, поразблял — результата нет, буду чистить. Другого выхода не вижу. Надеюсь хуже не станет. Хотя возникает вопрос, а не спалю ли я контору, отказываясь от ссылок? — не поставил ли Гугл сайт на заметку?

Долго читал и разбирался, но все же просветление пришло, спасибо автору за статью