Эксперимент по выводу страниц из Google Supplemental Index (соплей)

Всем привет! Около 3-х месяцев назад я писал о проблемах с индексацией в поисковой системе google: о так называемых соплях или supplemental индексе. Сами сотрудники поисковой системы отрицают наличия "соплей" в выдачи. Но то, что в ней имеются проиндексированные страницы сайтов, которые ведут себя по-разному - это факт.

Может быть, Supplemental индекса уже и нет, но он может просто по-другому называться. Некоторые доказательства этого факта можно прочитать как раз в прошлой статье (там еще есть дискуссии в комментариях). Там я рассказывал, что вообще такое дополнительный индекс в google.

С того поста я взялся за один небольшой эксперимент, благодаря которому можно было бы понять как выводить страницы из "соплей" в основной индекс.

Содержание:

Что было сделано в ходе эксперимента?

Я взял для эксперимента 10 страниц, которые на тот момент находились в "скрытом" индексе Google, то есть они не находились по запросу site:https://sosnovskij.ru/& и некоторые из них вели себя странно (выдавались не на первых позициях при вводе в поисковое окно некоторых кусков текста). Вот они:

- Мои источники доходов.

- Gogetlinks.

- Как увеличить защиту блога.

- Как увеличить число подписчиков на блоге.

- Акция по увеличению доходов от google adsense.

- 8 причин почему стоит комментировать блоги.

- Эксперимент по эффективному расположению ключевого слова в заголовке страницы. Имеется в виду тег title.

- Как определить самые горячие места на сайте. Существует аналог, которые не грузит систему - webvisor.

- Почему я провожу эксперименты.

- Как я стал тысячником - наполнение и активность.

Как видно, страницы в основном из главной ленты постов.

В интернете немало написано статей по выводу страниц из "соплей" гугла, как в рунете, так и в буржунете. Для себя же я определил 3 фактора, которые должны давать эффект (это в случае, если в самой странице нет проблем и контент на ней уникальный, существенный и интересный).

- Уровень доверия (траста) к сайту от google. Чем он выше, тем поисковая система считает каждую страницу ресурса более полезной для пользователя и, конечно, же она не должна быть под какими-то "санкциями".

- Внешняя важность страницы. Логично предположить, что если другие сайты ссылаются на страницу, то она должна быть в "основной" выдачи.

- Внутренняя важность страницы. Если на документ часто ссылаются с внутренних страниц, то значит, его вес в глазах google увеличивается.

Что же получается? Первые 2 пункта - это платные варианты, а последний - бесплатный. Он то как раз и оказался для меня наиболее интересным. Так вот я просто 5-10 раз ссылался с новых страниц блога на эти посты.

Что в итоге получилось?

А в результате получилось следующая картина. Номера соответствуют номерам постов, которые приведены выше.

То есть вывести получилось 80% страниц. Считаю это хорошим результатом .

Вывод эксперимента

Качественная внутренняя перелинковка на сайте позволяет ему иметь в "основном" индексе google больше страниц. Здесь я имею в виду ссылки не только из навигации и перелинковывающих плагинов, но и также линки непосредственно из статей.

Еще немного информации

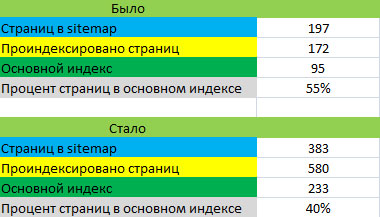

Я сравнил общие цифры по индексации моего блога поисковой системой google. Вот что получилось.

Интересен тот факт, что несколько месяцев назад количество проиндексированных страниц гуглом было даже меньше количества страниц в sitemap. Сейчас же это число намного выше (в sitemap сейчас 383 страницы, а проиндексировано 580). В этот период я как раз закупался статьями со старых, трастовых ресурсов из яндекс-каталога. Вот ко мне он (траст) как раз и "перетек" .

Основной вывод

Вот уже несколько месяцев я достаточно пристально изучаю индексацию сайтов поисковой системе google в рунете на блоге и своих сайтах. Главное, что я понял - не стоит акцентировать много внимания на соплях, различных индексах и так далее. Достаточно создавать интересный контент, качество его перелинковывать и создавать качественную ссылочную базу. Все это со временем принесет свои плоды. В гугле цифры так быстро меняются (сейчас он показывает 200 проиндексированных страниц, завтра 350, послезавтра 150), что тратить на это время не стоит.

А если же вам нужно вывести какую-то конкретную и важную страницу (-ы) из "соплей", то про методы я написал . Если у вас остались какие-то вопросы, то задавайте их в комментариях. Также будут рад любой дискуссии по теме.

P.S. В новогоднем конкурсе уже 36 работ. Напоминаю, что прислать свои картинки можно до 21 декабря включительно. Осталось всего лишь несколько дней .

(6 голос., в среднем: 4,33 из 5)

(6 голос., в среднем: 4,33 из 5) Создаем современную идеально оптимизированную страницу

Создаем современную идеально оптимизированную страницу  Как легко и бесплатно увеличить посещаемость сайта — инструкция по шагам

Как легко и бесплатно увеличить посещаемость сайта — инструкция по шагам  Яндекс Отменил ТИЦ! Какой размер ИКСа будет у Вашего сайта?

Яндекс Отменил ТИЦ! Какой размер ИКСа будет у Вашего сайта?

Согласен с вашим выводом , у меня на блоге конкурсная страницы(Бестмастеризация) тоже попала под сопли, и очень даже хорошо участвовала в выдаче, заняв 58 место в итоге, без особого внешнего продвижения.

, у меня на блоге конкурсная страницы(Бестмастеризация) тоже попала под сопли, и очень даже хорошо участвовала в выдаче, заняв 58 место в итоге, без особого внешнего продвижения.

Кстати к примеру у Шакина, половина страниц под фильтром. Но трафик с Google очень хороший идёт, посмотрите его статистику.

То есть достаточно правильной внутренней перелинковки? Интересно, а ссылки на посты из социальных закладок помогут выйти из соплей?

Strikestar, важно и качество сайта в целом + его траст. Насчет социальных закладок не могу сказать точно — не пробовал.

Поделюсь одним случаем, совпадение это или нет, сказать не могу, но больше склонна думать, что Не совпадение. Страница блога не появлялась в выдаче даже по точному соответствию длинной фразы в кавычках. Пока изучала выдачу, нашла вора, контент — синонимайз. Разобралась с вором жестко, исчез из выдачи полностью, через пару недель статья на 19 месте по СЧ запросу, на статью ни одной внешней ссылки, кроме пары ретвитов с твитера. После этого случая и общий процент страниц в основном индексе увеличился на несколько пунктов. Трафик увеличился, но не на много. Вот так вот

С проблемами индексации в гугле не сталкивался за весь свой опыт, вот с яшей да, бывает…

Ну как и ожидалось: главное внутренняя перелинковка и качество материала.

Проверила 2 своих сайта. На первом нет (хорошей) внутренней перелинковки, в основном индексе — 9% страниц, на втором — с каждой страницы в тексте ссылки на 3-4 другие страницы сайта, в индексе — более 40%. Тематика сайтов схожая, текст везде уникальный, 1,5-3000 знаков. Но подозреваю, вопрос не только в перелинковке.

Не уверен, что оператор site:_https://sosnovskij.ru/& означает сопли. Возможно эта шумиха про сопли раздута из ничего. Поясню… Сейчас специально проверил по этому оператору все страницы одного из моих сайтов. Получилось 720 страниц из 16000 реально существующих. Зашел в ливинтернет, посмотрел точки входа по страницам, по которым в сутки заходит до 30 человек из Google. Из 3-х тестовых страниц НИ ОДНА не находится в списке результатов по данному оператору. Миф для меня разрушен. Возможно когда-то было такое дело, но своим глазам я все же больше верю…

Борис, возможно, но что же тогда этот оператор обозначает? Может и не сопли в нашем понимании, а что-то другое. Таинственность всегда пугает, так что уж пусть это будут наши, «родные сопли»

только еще покажи где у гугля написано, что site:_https://sosnovskij.ru/& — показывает страницы, которые «не в соплях».

иначе весь эксперимент — уг.

а то придумал кто-то непонятный запрос и сказал? что это проверка на сопли, и все как попугаи стали повторять…

sasha, перечитайте пару первых абзацев. Я не утверждаю, что сейчас существуют «сопли» в их виде, в котором они были раньше. Но то, что имеются страницы, которые даже по урлу находятся на 5-10 строчках — это факт.

А это и был смысл эксперимента.

А еще перечитайте пару последних абзацев — там я пишу о том, что лучше вообще не задумываться об этом и не тратить время.

Здравствуйте Сергей, ещё раз хочу попросить вашей помощи с настройкой wordpress, можете объяснить как сделать так чтобы url отображал название поста, как у вас на блоге, какие для этого действия надо выполнить, только, чтобы не было примесей в виде дня или месяца публикаций поста, как сделать ЧПУ точно так как у вас? заранее спасибо.

sasha, Я конечно не Сергей, но возьму на себя смелость ответить на ваш вопрос. Заходите в админку вордпресса -> выбираете в меню параметры «постоянные ссылки и там настраиваете ЧПУ и в корневой директорий вашего блога находите (или создаете) файл .htaccess и добавляете туда эти строки:

Заходите в админку вордпресса -> выбираете в меню параметры «постоянные ссылки и там настраиваете ЧПУ и в корневой директорий вашего блога находите (или создаете) файл .htaccess и добавляете туда эти строки:

RewriteEngine On

RewriteBase /

RewriteCond %{REQUEST_FILENAME} !-f

RewriteCond %{REQUEST_FILENAME} !-d

RewriteRule . /index.php [L]

У Сергея кстати есть отличная статья на эту тему -> https://sosnovskij.ru/chpu

А у меня с Google пока проблемы. Плохо индексирует в отличие от Yandex.

И в основном индексе — то 60%, то 0%.

Правда еще контента маловато.

Про перелинковку знаю и практикую.

mindwork, да все верно .

.

Спасибо, полезная заметка!

У меня сейчас проблема. Главная страница сайта по туризму попала в сопли. При том, что на ней уникальный контент — проверял на вхождение. ВЧ запросы были на 5-8 местах, то есть ссылок было куплено много и трастовых. Висела в гугле полгода и все нормально было. А сейчас выпала и все тут. Купил ссылки с морд старых трастовых сайтов с пиар 8 и пиар 7. проовисело больше недели и никаких изменений. Что посоветуете??

Влад, подождать, либо поддержать дольше ссылки с морд трастовых сайтов. Неделя — это достаточно малый срок. А она случайно не переспамлена. Проблем с самой страницей нет?

Sosnovskij, нет не переспамлен. Как думаете, через сколько появится обратно в основном индексе?

Влад, я не могу сказать — это же поисковая система. Они бывают непредсказуемы .

Влад, «морд старых трастовых сайтов с пиар 8 и пиар 7» — а это реальный PR, не склеенный/накрученный? Выглядит немного подозрительно, на моей памяти редкий ресурс имеет PR 6, а выше что-то не припомню. Ну а вроде на морде яндекса, рамблера продажный ссылок нету.

Я свой новый сайт смотрел в запросах, при отключении перелинковки и уберания ссылок на внутренние страницы запрос намного хуже-я вообще в самом низу нахожусь)

У меня есть один сайтик (itstudents.ru). Щас проверил его на «сопли» из 600+ страниц в основном индексе 15+

Теперь понятно почему с Гугла посетителей нету почти

Может посоветуете что-нить?

Акимов Дмитрий, а что советовать? Все в посте изложено .

.

Благодарю за статью. Особенно порадовал вывод — писать, линковать и не париться. Просто и ясно

Отличная заметка. У меня, вроде, сопливых страниц нет.

БРЕД полный. По моим сведениям, запрос site:_https://sosnovskij.ru/&, как и site:_https://sosnovskij.ru/*, показывает ОСНОВНОЙ индекс Google. можете сами проверить по запросам на эти страницы. Подробности здесь: com-seo.ru/proverit-site-sopli-google-stranica-soplyah-gugla.html

Andriy, вы статью то хоть читали? Я про тоже самое и говорю.

Спасибо за статью, попробуем данные методы, чтобы избавится от «насморка».

Обнаружила страницы одного блога в «соплях». Спасибо за практический и главное эффективный совет.

Я вообще впервые о таком слышу)) Не давно меня яша начал индексировать, гугл заходил чаще, но что-то он както странно всё делает.

Странность в том что после эго захода на блог, индексация не проходит (через поисковик новый материал не ищется). Заходит он несколько раз. Я не могу понять принцип работы Гугловского бота!

Зачем заходить на блог и ничего не делать? Или он просто смотрит есть ли изменения или нет. НО вить есть же! Почему же не индексирует? Уже 5 дней прошло как было выложено несколько статей, ни одна не проиндексирована….

Может начинать быть в колокола?

wert, 5 дней — не повод бить в колокола.

Спасибо за «site:_https://sosnovskij.ru/&» я к тому что не знал как проверить сайт на сопли. у меня вообще с гугла трафа нету с яшки 100 чел есть. оказывается у меня все страницы за исключением главной и ещё 3 статей в соплях… сайту 4 месяца и он типо варезник. вот тут то что делать? перелинковывать пробовал толку нет прошёл месяц так и осталось. новые страницы все попадают в дополнительную выдачу.

Gerok, принципы от типа сайтов не меняются.

А у меня сайту больше года, в индексе гугла более 3К страниц, ссылок по панели около 300000, а трафика не больше 100 человек, при том, что в Яндексе индексация послабее, а трафика 2К. Сайт самописный и дубли страниц исключены.

Спасибо за проведенный эксперимент — все очень наглядно и просто описано. А главное результат поразительный! Буду пробовать.

У меня сейчас более 50 процентов в соплях! Прочитал где то, что и тэг Дискрипшен сильно влияет на это. У меня его нет. А как вы думаете, влияет? Писать теперь для всех страниц?

Игорь, в принципе лишними не будет, но если сотни страниц, то будет проблематично :).

я пришел к такому выводу, что гугл за какие-то определенные действие накладывает фильтр на некоторые станицы на 3 мес или больше. Если он считает, что таким способом вы хотите повысить выдачу в поисковике.

У меня такое было 90% страниц были в соплях, прошло 3 мес и траф с 1-20 чел рванул на 100-200.

cospi,

Количество страниц в индексе вообще ничего не значит в смысле там могут быть дубли, которых современные движки могут наплодить бесчисленное множество, так что все надо всегда проверять!

SEO-Дилетант’ка, та ну.. вы попутали что-то. Такое возможно лишь в том случае, если синонимайз был проиндексирован раньше вашей статьи. Сейчас перед публикацией на сайт статьи стоит добавлять ее в раздел «оригинальные тексты» яндекс.вебмастер.

У меня посещаемость сайта тоже упала в последнее время, с 500 до 350 в день . По некоторым запросам вообще перестали переходить посетители. Грустно. надо перепроверить перелиновку страниц, и сделать ссылочки как рекомендует автор блога. спасибо за статью, столько всего нового появляется, не успеваешь узнавать.

А за какое время страницы вышли из соплей после внутренней перелинковки?

СеоСтудент, около 3-х месяцев.

Всем доброго времени суток,вот мой сайт wmsteh.com.ua. Занимаюсь продвижением уже пол года, закупаю в миралинкс и гогетлинкс ссылки со статей оч.дорогие (от 200 до 900 р за размещение), статьи пишут еще отдельно уникальные. Проблема в том что запросы ползут в топ настолько слабо, что я уже перестаю верить в их значимость. Прикупил порядка 15-20 жирных ссылок на каждый ВЧ СК ключ и только некоторые из них в ТОП10. ВОПРОС В СЛЕДУЮЩЕМ — «НАСКОЛЬКО СИЛЬНО ЭТИ СОПЛИ могут ВЛИЯТЬ НА АДСКИЙ ТРУД В ПРОДВИЖЕНИИ?». Если верить работе этого оператора site:com-seo.ru/& то в основном индексе гугла у меня всего 287 страниц, а в общем в выдаче гугла 3900 страниц, вот блин я и думаю не сопли ли портят мне житуху. Очень буду благодарен если кто нибудь посоветует че-нить реальное.))

Иван, само количество страниц, которое находится в основном индексе гугла не может влиять на его позиции. Это как бы характеристика качества самих страниц. Улучшайте сайт, контент на нем. Ссылки — это только один из многих факторов ранжирования.

Но соплей то у меня порядка 3500 — они разве не могут влиять на позиции сайта?Исходя из прочитанного у вас на ресурсе я так понял,что они тянут сайт в низ??

Иван, количество соплей — это следствие качества сайта, а не причина, которая влияет на ранжирование. Причиной, например, может быть некачественный контент, который не попал в основную выдачу и плохо ранжируется в google.

Я просто подумал,что количество соплей очень влияет на ранжирование(может не правильно понял то,что вы изложили в посте).А сами сопли ведь и из-за некачественного контента тоже и появляются,так ведь??

Иван, некачественный контент, плохая структура сайта.

Подскажите, а страницам в соплях присваивается PR?

Света, pagerank присваивается всем страницам, не зависимо от соплей. Зачастую, если у страницы есть PR, то она не будет в соплях.

Товарищи расскажите кто каким плагином пользуется для перелинковки, если можно в личку пишите slon291@yandex.ru

Интересно было почитать, спасибо всем за информацию

Подскажите, пожалуйста, а как проверить, что страницы попали в сопли? У меня как раз трафик пошел на спад. Уже месяц не могу понять причины. Статьи пишу каждый день, индексация проходит быстро, а в поиске страниц нету… Помогите, плизз!!!

Юлия, в этой статье подробнее написано про сами сопли google https://sosnovskij.ru/indexing-google/

Гугл вообще трудно понять. Я знаю сайты где мета тегов вообще нет или они все одинаковые или криво составленные. При этом сайты висят в топ 10 и посещаемость на них выше 60000 тыс хостов в сутки. Я имею ввиду сайты майнкрафт тематики. Лично мой сайт заполнен уникальным контентом и тексты я писал сам. Мета теги расставлены верно и это не помешало гуглу забить все мои файлы, ВСЕ в сопли за один день. Лично мое мнение пошли они в *опу.

Подскажите, как узнать адреса страниц в сопливой выдаче?

site:vasya.com -site:vasya.com/& ничего не выдает, хотя рдс бар показывает, что в основном индексе только 12%

ASlex, вручную Проиндексированные страниц минус страницы, которые находятся в основной выдаче.

Проиндексированные страниц минус страницы, которые находятся в основной выдаче.

Тоже сегодня заметил на одном онлайн сервисе что есть + страницы в supplemental. Но спасибо нашел понятливую статью, а то весь инет перерыл.

Спасибо за статью, интересно.

У меня вот интернет-магазин, и почти все страницы находятся в соплях, в основном только страницы категорий, новости, статьи и горстка товаров (329 против 8070). И это ещё полбеды, но я попробовал с одной из страниц новостей поставить ссылки на пару товаров, и они сразу попали в основной индекс. Прошло несколько дней, и их уже там нет, то есть страницы выпали.

Описания для каждого товара, разумеется, пишутся самостоятельно. Прям не знаю, что делать. Точнее, есть идеи поиграть со ссылками внутри сайта, но что-то в успех слабо верится. У конкурентов, кстати, в разы больше страниц в основной выдаче, закономерности пока не нашёл.

Казанова, «поиграться» стоит с внутренними/внешними ссылками, контентным составляющим.

А вообще карточки товаров часто попадают в сопли. Как вариант, из-за глубины их вложенности.

Sosnovskij, спасибо за комментарий. Ну, путь к товару близкий: клик в категорию, потом товар; или ещё подкатегория (одна) может быть на пути. Юрл вида сайт.юа/товар.

Возможно, но ведь полно магазинов, у которых товары не в соплях.

Я тоже когда провел перелинковку, полегче стало в плане развития сайта по поисковым запросам. Но дальше, что делать, чтобы войти в ТОП 10 не знаю.